Kanalcodierung/Klassifizierung von Signalen: Unterschied zwischen den Versionen

Ayush (Diskussion | Beiträge) |

|||

| (6 dazwischenliegende Versionen von einem anderen Benutzer werden nicht angezeigt) | |||

| Zeile 15: | Zeile 15: | ||

*Aufgrund der Gaußschen WDF kann das Ausgangssignal <i>y</i> = <i>x</i>̃ + <i>n</i> alle reellen Werte annehmen. Der Signalwert <i>y</i> ist zwar wie <i>x</i>̃ zeitdiskret, im Gegensatz zu diesem aber wertkontinuierlich.<br> | *Aufgrund der Gaußschen WDF kann das Ausgangssignal <i>y</i> = <i>x</i>̃ + <i>n</i> alle reellen Werte annehmen. Der Signalwert <i>y</i> ist zwar wie <i>x</i>̃ zeitdiskret, im Gegensatz zu diesem aber wertkontinuierlich.<br> | ||

| − | [[Datei:P ID2340 KC T 1 2 S1 v2.png|Modell und WDF des AWGN–Kanals|class=fit]]<br> | + | [[Datei:P ID2340 KC T 1 2 S1 v2.png|center|Modell und WDF des AWGN–Kanals|class=fit]]<br> |

Die rechte Grafik zeigt die bedingten Wahrscheinlichkeitsdichtefunktionen (in blau bzw. rot): | Die rechte Grafik zeigt die bedingten Wahrscheinlichkeitsdichtefunktionen (in blau bzw. rot): | ||

| Zeile 29: | Zeile 29: | ||

f_{y \hspace{0.03cm}| \hspace{0.03cm}x=1 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=1 )\right ]\hspace{0.05cm}.</math> | f_{y \hspace{0.03cm}| \hspace{0.03cm}x=1 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=1 )\right ]\hspace{0.05cm}.</math> | ||

| − | Die beiden schraffierten Flächen (jeweils <i>ε</i>) markieren Entscheidungsfehler unter der Voraussetzung | + | Die beiden schraffierten Flächen (jeweils <i>ε</i>) markieren Entscheidungsfehler unter der Voraussetzung <i>x</i> = 0 ⇒ <i>x</i>̃ = +1 (blau) bzw. <i>x</i> = 1 ⇒ <i>x</i>̃ = –1 (rot), wenn harte Entscheidungen getroffen werden: |

:<math>z = \left\{ \begin{array}{c} 0\\ | :<math>z = \left\{ \begin{array}{c} 0\\ | ||

| Zeile 51: | Zeile 51: | ||

== Binary Symmetric Channel – BSC == | == Binary Symmetric Channel – BSC == | ||

<br> | <br> | ||

| − | Das AWGN–Kanalmodell ist kein digitales Kanalmodell, wie wir es im Kapitel 1.1 zur Beschreibung der Kanalcodierverfahren vorausgesetzt haben. Berücksichtigen wir aber eine harte Entscheidung, so kommen wir zum digitalen Modell <i>Binary Symmetric Channel</i> (BSC):<br> | + | Das AWGN–Kanalmodell ist kein digitales Kanalmodell, wie wir es im [http://www.lntwww.de/Kanalcodierung/Zielsetzung_der_Kanalcodierung#Blockschaltbild_und_Voraussetzungen Kapitel 1.1] zur Beschreibung der Kanalcodierverfahren vorausgesetzt haben. Berücksichtigen wir aber eine harte Entscheidung, so kommen wir zum digitalen Modell <i>Binary Symmetric Channel</i> (BSC):<br> |

[[Datei:P ID2341 KC T 1 2 S2 v2.png|BSC–Modell und Zusammenhang mit dem AWGN–Modell|class=fit]]<br> | [[Datei:P ID2341 KC T 1 2 S2 v2.png|BSC–Modell und Zusammenhang mit dem AWGN–Modell|class=fit]]<br> | ||

| Zeile 59: | Zeile 59: | ||

:<math>\varepsilon = {\rm Q}(\sqrt{\rho})\hspace{0.05cm},</math> | :<math>\varepsilon = {\rm Q}(\sqrt{\rho})\hspace{0.05cm},</math> | ||

| − | so ist der Zusammenhang zum AWGN–Kanalmodell hergestellt. Die Entscheidungsgrenze liegt dabei bei <i>G</i> = 0, wodurch auch die Eigenschaft „symmetrisch” begründet ist.<br> | + | so ist der Zusammenhang zum [http://www.lntwww.de/Kanalcodierung/Kanalmodelle_und_Entscheiderstrukturen#AWGN.E2.80.93Kanal_bei_bin.C3.A4rem_Eingang AWGN–Kanalmodell] hergestellt. Die Entscheidungsgrenze liegt dabei bei <i>G</i> = 0, wodurch auch die Eigenschaft „symmetrisch” begründet ist.<br> |

<i>Hinweis:</i> Beim AWGN–Modell haben wir die binäre Ausgangsgröße (nach Schwellenwertentscheidung) mit <i>z</i> ∈ {0, 1} bezeichnet. Bei den digitalen Kanalmodellen (BSC, BEC, BSEC) bezeichnen wir nun den wertdiskreten Ausgang wieder mit <i>y</i>. Um Verwechslungen zu vermeiden, nennen wir das Ausgangssignal des AWGN –Modells nun <i>y</i><sub>A</sub>. Für das analoge Empfangssignal gilt <i>y</i><sub>A</sub> = <i>x</i>̃ + <i>n</i>.<br> | <i>Hinweis:</i> Beim AWGN–Modell haben wir die binäre Ausgangsgröße (nach Schwellenwertentscheidung) mit <i>z</i> ∈ {0, 1} bezeichnet. Bei den digitalen Kanalmodellen (BSC, BEC, BSEC) bezeichnen wir nun den wertdiskreten Ausgang wieder mit <i>y</i>. Um Verwechslungen zu vermeiden, nennen wir das Ausgangssignal des AWGN –Modells nun <i>y</i><sub>A</sub>. Für das analoge Empfangssignal gilt <i>y</i><sub>A</sub> = <i>x</i>̃ + <i>n</i>.<br> | ||

| Zeile 68: | Zeile 68: | ||

Zur Beschreibung gedächtnisbehafteter Kanäle müssen andere Modelle herangezogen werden, die im Kapitel 5 des Buches „Digitalsignalübertragung” behandelt werden, zum Beispiel Bündelfehler nach | Zur Beschreibung gedächtnisbehafteter Kanäle müssen andere Modelle herangezogen werden, die im Kapitel 5 des Buches „Digitalsignalübertragung” behandelt werden, zum Beispiel Bündelfehler nach | ||

| − | *dem Gilbert–Elliott–Modell,<br> | + | *dem [http://www.lntwww.de/Digitalsignal%C3%BCbertragung/B%C3%BCndelfehlerkan%C3%A4le#Kanalmodell_nach_Gilbert.E2.80.93Elliott_.281.29 Gilbert–Elliott–Modell,]<br> |

| − | *dem McCullough–Kanalmodell.<br><br> | + | *dem [http://www.lntwww.de/Digitalsignal%C3%BCbertragung/B%C3%BCndelfehlerkan%C3%A4le#Kanalmodell_nach_McCullough_.281.29 McCullough–Kanalmodell.]<br><br> |

Die Abbildung zeigt statistisch unabhängige Fehler nach dem BSC–Modell (links) und so genannte Bündelfehler gemäß Gilbert–Elliott (rechts), wobei die Bitfehlerrate in beiden Fällen 10% beträgt. Aus der rechten Grafik ist zu erkennen, dass das Bild zeilenweise übertragen wird.<br> | Die Abbildung zeigt statistisch unabhängige Fehler nach dem BSC–Modell (links) und so genannte Bündelfehler gemäß Gilbert–Elliott (rechts), wobei die Bitfehlerrate in beiden Fällen 10% beträgt. Aus der rechten Grafik ist zu erkennen, dass das Bild zeilenweise übertragen wird.<br> | ||

| Zeile 76: | Zeile 76: | ||

== Binary Erasure Channel – BEC == | == Binary Erasure Channel – BEC == | ||

<br> | <br> | ||

| − | Das BSC–Modell liefert nur die Aussagen „richtig” und „falsch”. Manche Empfänger – so zum Beispiel die so genannten Soft–in Soft–out Decoder – können jedoch auch gewisse Informationen über die Sicherheit der Entscheidung liefern, wobei sie natürlich darüber informiert werden müssen, welche ihrer Eingangswerte sicher sind und welche eher unsicher.<br> | + | Das BSC–Modell liefert nur die Aussagen „richtig” und „falsch”. Manche Empfänger – so zum Beispiel die so genannten [http://www.lntwww.de/Kanalcodierung/Soft%E2%80%93in_Soft%E2%80%93out_Decoder#Hard_Decision_vs._Soft_Decision_.281.29 Soft–in Soft–out Decoder] – können jedoch auch gewisse Informationen über die Sicherheit der Entscheidung liefern, wobei sie natürlich darüber informiert werden müssen, welche ihrer Eingangswerte sicher sind und welche eher unsicher.<br> |

[[Datei:P ID2343 KC T 1 2 S3 v2.png|Binary Erasure Channel (BEC) und Zusammenhang mit dem AWGN–Modell|class=fit]]<br> | [[Datei:P ID2343 KC T 1 2 S3 v2.png|Binary Erasure Channel (BEC) und Zusammenhang mit dem AWGN–Modell|class=fit]]<br> | ||

| Zeile 119: | Zeile 119: | ||

== MAP– und ML–Kriterium (1) == | == MAP– und ML–Kriterium (1) == | ||

<br> | <br> | ||

| − | Wir gehen nun von dem nachfolgend skizzierten Modell aus und wenden die bereits im Kapitel 4.2 des Buches „Digitalsignalübertragung” genannten Entscheidungskriterien auf den Decodiervorgang an.<br> | + | Wir gehen nun von dem nachfolgend skizzierten Modell aus und wenden die bereits im [http://www.lntwww.de/Digitalsignal%C3%BCbertragung/Struktur_des_optimalen_Empf%C3%A4ngers#Blockschaltbild_und_Voraussetzungen Kapitel 4.2] des Buches „Digitalsignalübertragung” genannten Entscheidungskriterien auf den Decodiervorgang an.<br> |

[[Datei:P ID2345 KC T 1 2 S5 v2.png|Modell zur Beschreibung von MAP– und ML–Decodierung|class=fit]]<br> | [[Datei:P ID2345 KC T 1 2 S5 v2.png|Modell zur Beschreibung von MAP– und ML–Decodierung|class=fit]]<br> | ||

| Zeile 156: | Zeile 156: | ||

:<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.03cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} {\rm Pr}( \underline{x}_{\hspace{0.03cm}i} |\hspace{0.05cm} \underline{y} ) \hspace{0.05cm}.</math> | :<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.03cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} {\rm Pr}( \underline{x}_{\hspace{0.03cm}i} |\hspace{0.05cm} \underline{y} ) \hspace{0.05cm}.</math> | ||

| − | Pr(<i><u>x</u></i><sub><i>i </i></sub>|<sub> </sub><i><u>y</u></i>) ist die bedingte Wahrscheinlichkeit, dass <i><u>x</u></i><sub><i>i</i></sub> gesendet wurde, wenn <i><u>y</u></i> empfangen wird.{{end}}<br> | + | Pr(<i><u>x</u></i><sub><i>i </i></sub>|<sub> </sub><i><u>y</u></i>) ist die [http://www.lntwww.de/Stochastische_Signaltheorie/Statistische_Abh%C3%A4ngigkeit_und_Unabh%C3%A4ngigkeit#Bedingte_Wahrscheinlichkeit_.281.29 bedingte Wahrscheinlichkeit,] dass <i><u>x</u></i><sub><i>i</i></sub> gesendet wurde, wenn <i><u>y</u></i> empfangen wird.{{end}}<br> |

| − | Nach dem Satz von Bayes kann die Rückschlusswahrscheinlichkeit wie folgt umgeformt werden: | + | Nach dem [http://www.lntwww.de/Stochastische_Signaltheorie/Statistische_Abh%C3%A4ngigkeit_und_Unabh%C3%A4ngigkeit#Bedingte_Wahrscheinlichkeit_.281.29 Satz von Bayes] kann die Rückschlusswahrscheinlichkeit wie folgt umgeformt werden: |

:<math>{\rm Pr}( \underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm}|\hspace{0.05cm} \underline{y} ) = | :<math>{\rm Pr}( \underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm}|\hspace{0.05cm} \underline{y} ) = | ||

| Zeile 173: | Zeile 173: | ||

Im Folgenden verwenden wir auf Blockebene stets den ML–Empfänger. Aufgrund der vorausgesetzten gleichwahrscheinlichen Informationsworte liefert auch dieser stets die bestmögliche Entscheidung.<br> | Im Folgenden verwenden wir auf Blockebene stets den ML–Empfänger. Aufgrund der vorausgesetzten gleichwahrscheinlichen Informationsworte liefert auch dieser stets die bestmögliche Entscheidung.<br> | ||

| − | Anders sieht es jedoch auf Bitebene aus. Ziel einer iterativen Decodierung ist es gerade, für alle Codebits <i>x</i><sub><i>i</i></sub> & | + | Anders sieht es jedoch auf Bitebene aus. Ziel einer iterativen Decodierung ist es gerade, für alle Codebits <i>x</i><sub><i>i</i></sub> ∈ {0, 1} Wahrscheinlichkeiten zu schätzen und diese an die nächste Stufe weiterzugeben. Hierzu benötigt man einen MAP–Empfänger.<br> |

{{Definition}}''':''' Der Maximum–a–posteriori–Empfänger auf Bitebene (kurz: bit–wise MAP) wählt für jedes Codebit <i>x</i><sub><i>i</i></sub> den Wert ( 0 oder 1) mit der größten Rückschlusswahrscheinlichkeit Pr(<i>x</i><sub><i>i </i></sub>|<sub> </sub><i><u>y</u></i>): | {{Definition}}''':''' Der Maximum–a–posteriori–Empfänger auf Bitebene (kurz: bit–wise MAP) wählt für jedes Codebit <i>x</i><sub><i>i</i></sub> den Wert ( 0 oder 1) mit der größten Rückschlusswahrscheinlichkeit Pr(<i>x</i><sub><i>i </i></sub>|<sub> </sub><i><u>y</u></i>): | ||

| Zeile 180: | Zeile 180: | ||

{{end}}<br> | {{end}}<br> | ||

| + | == ML–Entscheidung beim BSC–Kanal == | ||

| + | <br> | ||

| + | Wenden wir nun das ML–Kriterium auf den gedächtnislosen BSC–Kanal an. Dann gilt: | ||

| + | |||

| + | :<math>{\rm Pr}( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) = | ||

| + | \prod\limits_{l=1}^{n} {\rm Pr}( y_l \hspace{0.05cm}|\hspace{0.05cm} x_l ) \hspace{0.2cm}{\rm mit}\hspace{0.2cm} | ||

| + | {\rm Pr}( y_l \hspace{0.05cm}|\hspace{0.05cm} x_l ) = | ||

| + | \left\{ \begin{array}{c} 1 - \varepsilon\\ | ||

| + | \varepsilon \end{array} \right.\quad | ||

| + | \begin{array}{*{1}c} {\rm falls} \hspace{0.15cm} y_l = x_l \hspace{0.05cm},\\ | ||

| + | {\rm falls} \hspace{0.15cm}y_l \ne x_l\hspace{0.05cm}.\\ \end{array} | ||

| + | \hspace{0.05cm}.</math> | ||

| + | |||

| + | :<math>\Rightarrow \hspace{0.3cm} {\rm Pr}( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) = | ||

| + | \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot | ||

| + | (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} | ||

| + | \hspace{0.05cm}.</math> | ||

| + | |||

| + | Dies lässt sich wie folgt begründen: | ||

| + | *Die [http://www.lntwww.de/Kanalcodierung/Zielsetzung_der_Kanalcodierung#Einige_wichtige_Definitionen_zur_Blockcodierung Hamming–Distanz] <i>d</i><sub>H</sub>(<i><u>y</u></i>, <i><u>x</u><sub>i</sub></i>) gibt die Anzahl der Bitpositionen an, in denen sich die beiden Worte <i><u>y</u></i> und <i><u>x<sub>i</sub></u></i> mit jeweils <i>n</i> binären Elementen unterscheiden. Beispielsweise ist die Hamming–Distanz zwischen <i><u>y</u></i> = (0, 1, 0, 1, 0, 1, 1) und <i><u>x</u><sub>i</sub></i> = (0, 1, 0, 0, 1, 1, 1) gleich 2.<br> | ||

| + | |||

| + | *In <i>n</i> – <i>d</i><sub>H</Sub>(<i><u>y</u></i>, <i><u>x</u><sub>i</sub></i>) Positionen unterscheiden sich demnach die beiden Vektoren <i><u>y</u></i> und <i><u>x</u><sub>i</sub></i> nicht. Im obigen Beispiel sind 5 der <i>n</i> = 7 Bit identisch. Zu obiger Gleichung kommt man schließlich durch Einsetzen der Verfälschungswahrscheinlichkeit <i>ε</i> bzw. deren Ergänzung 1 – <i>ε</i>.<br><br> | ||

| + | |||

| + | Die Vorgehensweise bei der Maximum–Likelihood–Detektion ist, dasjenige Codewort <i><u>x</u><sub>i</sub></i> zu finden, das die Übergangswahrscheinlichkeit Pr(<i><u>y</u></i> | <i><u>x</u><sub>i</sub></i>) maximiert: | ||

| + | |||

| + | :<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | \left [ | ||

| + | \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot | ||

| + | (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} | ||

| + | \right ] \hspace{0.05cm}.</math> | ||

| + | |||

| + | Da der Logarithmus eine monoton steigende Funktion ist, erhält man das gleiche Ergebnis nach folgender Maximierung: | ||

| + | |||

| + | :<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | L(\underline{x}_{\hspace{0.03cm}i}) </math> | ||

| + | |||

| + | :<math>{\rm mit}\hspace{0.15cm} L(\underline{x}_{\hspace{0.03cm}i}) \hspace{-0.1cm} = \hspace{-0.1cm} \ln \left [ | ||

| + | \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot | ||

| + | (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} | ||

| + | \right ] =</math> | ||

| + | :<math> \hspace{2cm} = \hspace{-0.1cm} d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i}) \cdot \ln | ||

| + | \hspace{0.05cm} \varepsilon + [n -d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})] \cdot \ln | ||

| + | \hspace{0.05cm} (1- \varepsilon) = </math> | ||

| + | :<math>\hspace{2cm} = \hspace{-0.1cm} \ln \frac{\varepsilon}{1-\varepsilon} \cdot d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i}) + n \cdot \ln | ||

| + | \hspace{0.05cm} (1- \varepsilon) | ||

| + | \hspace{0.05cm}.</math> | ||

| + | |||

| + | Der zweite Term dieser Gleichung ist unabhängig von <i><u>x</u><sub>i</sub></i> und muss für die Maximierung nicht weiter betrachtet werden. Auch der Faktor vor der Hamming–Distanz ist für alle <i><u>x</u><sub>i</sub></i> gleich. Da aber ln <i>ε</i>/(1 – <i>ε</i>) negativ ist (zumindest für <i>ε</i> < 0.5, was ohne große Einschränkung vorausgestzt werden kann), wird aus der Maximierung eine Minimierung, und man erhält folgendes Endergebnis:<br> | ||

| + | |||

| + | ML–Entscheidung beim BSC–Kanal: Wähle von den 2<sup><i>k</i></sup> zulässigen Codeworten dasjenige mit der <i>geringsten Hamming–Distanz</i> <i>d</i><sub>H</sub>(<i><u>y</u></i>, <i><u>x<sub>i</sub></u></i>) zum Empfangsvektor <i><u>y</u></i> aus: | ||

| + | |||

| + | :<math>\underline{z} = {\rm arg} \min_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})\hspace{0.05cm}, \hspace{0.2cm} | ||

| + | \underline{y} \in {\rm GF}(2^n) \hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.</math> | ||

| + | |||

| + | Anwendungen der ML/BSC–Entscheidung finden Sie auf den folgenden Seiten: | ||

| + | *[http://www.lntwww.de/Kanalcodierung/Beispiele_bin%C3%A4rer_Blockcodes#Single_Parity.E2.80.93check_Codes_.281.29 Single Parity–check Code] (SPC)<br> | ||

| + | |||

| + | *[http://www.lntwww.de/Kanalcodierung/Beispiele_bin%C3%A4rer_Blockcodes#Wiederholungscodes_.281.29 Wiederholungscode] (englisch: <i>Repetition Code</i>, RC).<br> | ||

| + | |||

| + | == ML–Entscheidung beim AWGN–Kanal == | ||

| + | <br> | ||

| + | Das AWGN–Modell für einen (<i>n</i>, <i>k</i>)–Blockcode unterscheidet sich vom [http://www.lntwww.de/Kanalcodierung/Kanalmodelle_und_Entscheiderstrukturen#AWGN.E2.80.93Kanal_bei_bin.C3.A4rem_Eingang Modell] auf der ersten Seite dieses Kapitels dadurch, dass für <i>x</i>, <i>x</i>̃ und <i>y</i> nun die entsprechenden Vektoren <i><u>x</u></i>, <u><i>x</i></u>̃ und <i><u>y</u></i> verwendet werden müssen, jeweils bestehend aus <i>n</i> Elementen. Die Schritte zur Herleitung des ML–Entscheiders bei AWGN werden nachfolgend nur stichpunktartig angegeben: | ||

| + | *Der AWGN–Kanal ist per se gedächtnislos (hierfür steht das <i>White</i> im Namen), so dass für die bedingte Wahrscheinlichkeitsdichtefunktion geschrieben werden kann: | ||

| + | |||

| + | ::<math>f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}} ) = | ||

| + | \prod\limits_{l=1}^{n} f( y_l \hspace{0.05cm}|\hspace{0.05cm} \tilde{x}_l ) | ||

| + | \hspace{0.05cm}.</math> | ||

| + | |||

| + | *Die bedingte WDF ist für jedes einzelne Codeelement (<i>l</i> = 1, ... , <i>n</i>) gaußisch. Damit genügt auch die gesamte WDF einer (eindimensionalen) Gaußverteilung: | ||

| + | |||

| + | ::<math>f({y_l \hspace{0.03cm}| \hspace{0.03cm}\tilde{x}_l }) = | ||

| + | \frac {1}{\sqrt{2\pi} \cdot \sigma } \cdot \exp \left [ - \frac {(y_l - \tilde{x}_l)^2}{2\sigma^2} \right ]</math> | ||

| + | |||

| + | ::<math>\Rightarrow \hspace{0.3cm} f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}} ) = | ||

| + | \frac {1}{(2\pi)^{n/2} \cdot \sigma^n } \cdot \exp \left [ - \frac {1}{2\sigma^2} \cdot | ||

| + | \sum_{l=1}^{n} \hspace{0.2cm}(y_l - \tilde{x}_l)^2 | ||

| + | \right ] \hspace{0.05cm}.</math> | ||

| + | |||

| + | |||

| + | *Da <u><i>y</i></u> nun nicht mehr wie beim BSC–Modell wertdiskret ist, sondern wertkontinuierlich, müssen jetzt entsprechend der ML–Entscheidungsregel <i>Wahrscheinlichkeitsdichten</i> untersucht werden und nicht mehr Wahrscheinlichkeiten. Das optimale Ergebnis lautet: | ||

| + | |||

| + | ::<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}}_i )\hspace{0.05cm}, \hspace{0.8cm} | ||

| + | \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.</math> | ||

| + | |||

| + | *In der Algebra bezeichnet man den Abstand zweier Punkte <u><i>y</i></u> und <i>x</i>̃ im <i>n</i>–dimensionalen Raum als die Euklidische Distanz, benannt nach dem griechischen Mathematiker Euklid, der im dritten Jahrhundert vor Christus lebte: | ||

| + | |||

| + | ::<math>d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{\tilde{x}}) = | ||

| + | \sqrt{\sum_{l=1}^{n} \hspace{0.2cm}(y_l - \tilde{x}_l)^2}\hspace{0.05cm},\hspace{0.8cm} | ||

| + | \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in \mathcal{C} | ||

| + | \hspace{0.05cm}.</math> | ||

| + | |||

| + | *Damit lautet die ML–Entscheidungsregel beim AWGN–Kanal für einen jeden Blockcode unter Berücksichtigung der Tatsache, dass der erste Faktor der WDF <i>f</i>(<u><i>y</i></u> | <u><i>x</i></u>̃<sub><i>i</i></sub>) konstant ist: | ||

| + | |||

| + | ::<math>\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | \exp \left [ - \frac {d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{\tilde{x}}_i)}{2\sigma^2} | ||

| + | \right ]\hspace{0.05cm}, \hspace{0.8cm} | ||

| + | \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.</math> | ||

| + | |||

| + | Nach einigen weiteren Zwischenschritten kommt man zum Ergebnis:<br> | ||

| + | |||

| + | ML–Entscheidung beim AWGN–Kanal: Wähle von den 2<sup><i>k</i></sup> zulässigen Codeworten <i>x<sub>i</sub></i> dasjenige mit der <i>kleinsten Euklidischen Distanz</i> zum Empfangsvektor <u><i>y</i></u> aus: | ||

| + | |||

| + | :<math>\underline{z} = {\rm arg} \min_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} | ||

| + | d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})\hspace{0.05cm}, \hspace{0.8cm} | ||

| + | \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.</math> | ||

| + | |||

| + | ==Aufgaben== | ||

| + | <br> | ||

| + | [[Aufgaben:1.3 BSC–BEC–BSEC–AWGN|A1.3 BSC–BEC–BSEC–AWGN]] | ||

| + | |||

| + | [[Aufgaben:1.4 Maximum–Likelihood–Entscheidung|A1.4 Maximum–Likelihood–Entscheidung]] | ||

{{Display}} | {{Display}} | ||

Aktuelle Version vom 25. Juni 2019, 10:41 Uhr

Inhaltsverzeichnis

AWGN–Kanal bei binärem Eingang

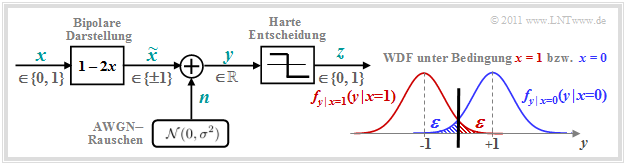

Wir betrachten das bekannte zeitdiskrete AWGN–Kanalmodell gemäß der unteren Grafik (links):

- Das binäre und zeitdiskrete Nachrichtensignal x nimmt mit gleicher Wahrscheinlichkeit die Werte 0 und 1 an, das heißt, es ist Pr(x = 0) = Pr(x̃ = +1) = 1/2 sowie Pr(x = 1) = Pr(x̃ = –1) = 1/2.

- Die Übertragung wird durch additives weißes gaußverteiltes Rauschen (AWGN) n mit der (normierten) Rauschleistung σ2 = N0/(2ES) beeinträchtigt. Die Streuung der Gauß–WDF ist σ.

- Aufgrund der Gaußschen WDF kann das Ausgangssignal y = x̃ + n alle reellen Werte annehmen. Der Signalwert y ist zwar wie x̃ zeitdiskret, im Gegensatz zu diesem aber wertkontinuierlich.

Die rechte Grafik zeigt die bedingten Wahrscheinlichkeitsdichtefunktionen (in blau bzw. rot):

\[f_{y \hspace{0.03cm}| \hspace{0.03cm}x=0 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=0 )\hspace{-0.1cm} = \hspace{-0.1cm} \frac {1}{\sqrt{2\pi} \cdot \sigma } \cdot \exp \left [ - \frac {(y-1)^2}{2\sigma^2} \right ]\hspace{0.05cm},\] \[f_{y \hspace{0.03cm}| \hspace{0.03cm}x=1 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=1 )\hspace{-0.1cm} = \hspace{-0.1cm} \frac {1}{\sqrt{2\pi} \cdot \sigma } \cdot \exp \left [ - \frac {(y+1)^2}{2\sigma^2} \right ]\hspace{0.05cm}.\]

Nicht dargestellt ist die gesamte (unbedingte) WDF, für die bei gleichwahrscheinlichen Symbolen gilt:

\[f_y(y) = {1}/{2} \cdot \left [ f_{y \hspace{0.03cm}| \hspace{0.03cm}x=0 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=0 ) + f_{y \hspace{0.03cm}| \hspace{0.03cm}x=1 } \hspace{0.05cm} (y \hspace{0.05cm}| \hspace{0.05cm}x=1 )\right ]\hspace{0.05cm}.\]

Die beiden schraffierten Flächen (jeweils ε) markieren Entscheidungsfehler unter der Voraussetzung x = 0 ⇒ x̃ = +1 (blau) bzw. x = 1 ⇒ x̃ = –1 (rot), wenn harte Entscheidungen getroffen werden:

\[z = \left\{ \begin{array}{c} 0\\ 1 \end{array} \right.\quad \begin{array}{*{1}c} {\rm falls} \hspace{0.15cm} y > 0\hspace{0.05cm},\\ {\rm falls} \hspace{0.15cm}y < 0\hspace{0.05cm}.\\ \end{array}\]

Bei gleichwahrscheinlichen Eingangssymbolen ist dann die mittlere Bitfehlerwahrscheinlichkeit Pr(z ≠ x) ebenfalls gleich ε. Mit dem Komplementären Gaußschen Fehlerintergral Please add link and do not upload flash videos. Q(x) gilt dabei:

\[\varepsilon = {\rm Q}(1/\sigma) = {\rm Q}(\sqrt{\rho}) = \frac {1}{\sqrt{2\pi} } \cdot \int_{\sqrt{\rho}}^{\infty}{\rm e}^{- \alpha^2/2} \hspace{0.1cm}{\rm d}\alpha \hspace{0.05cm}.\]

Hierbei bezeichnet ρ = 1/σ2 = 2 · ES/N0 das Signal–zu–Rauschverhältnis (SNR) vor dem Entscheider, wobei folgende Systemgrößen verwendet werden:

- ES ist die Signalenergie pro Symbol (ohne Codierung gleich EB, also der Signalenergie pro Bit),

- N0 bezeichnet die konstante (einseitige) Rauschleistungsdichte des AWGN–Kanals.

Wir verweisen hier auf das interaktive Flash–Modul Fehlerwahrscheinlichkeit von Digitalsystemen Please add link and do not upload flash videos.

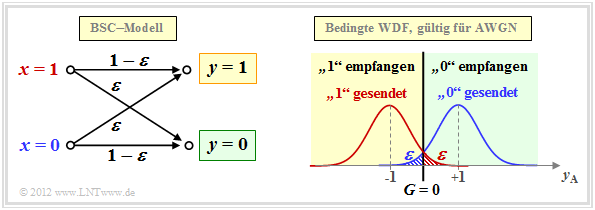

Binary Symmetric Channel – BSC

Das AWGN–Kanalmodell ist kein digitales Kanalmodell, wie wir es im Kapitel 1.1 zur Beschreibung der Kanalcodierverfahren vorausgesetzt haben. Berücksichtigen wir aber eine harte Entscheidung, so kommen wir zum digitalen Modell Binary Symmetric Channel (BSC):

Wählt man die Verfälschungswahrscheinlichkeiten Pr(y = 1 | x = 0) bzw. Pr(y = 0 | x = 1) jeweils zu

\[\varepsilon = {\rm Q}(\sqrt{\rho})\hspace{0.05cm},\]

so ist der Zusammenhang zum AWGN–Kanalmodell hergestellt. Die Entscheidungsgrenze liegt dabei bei G = 0, wodurch auch die Eigenschaft „symmetrisch” begründet ist.

Hinweis: Beim AWGN–Modell haben wir die binäre Ausgangsgröße (nach Schwellenwertentscheidung) mit z ∈ {0, 1} bezeichnet. Bei den digitalen Kanalmodellen (BSC, BEC, BSEC) bezeichnen wir nun den wertdiskreten Ausgang wieder mit y. Um Verwechslungen zu vermeiden, nennen wir das Ausgangssignal des AWGN –Modells nun yA. Für das analoge Empfangssignal gilt yA = x̃ + n.

Das BSC–Modell liefert eine statistisch unabhängige Fehlerfolge und eignet sich somit zur Modellierung gedächtnisloser rückkopplungsfreier Kanäle, die in diesem Buch ausnahmslos betrachtet werden.

Zur Beschreibung gedächtnisbehafteter Kanäle müssen andere Modelle herangezogen werden, die im Kapitel 5 des Buches „Digitalsignalübertragung” behandelt werden, zum Beispiel Bündelfehler nach

Die Abbildung zeigt statistisch unabhängige Fehler nach dem BSC–Modell (links) und so genannte Bündelfehler gemäß Gilbert–Elliott (rechts), wobei die Bitfehlerrate in beiden Fällen 10% beträgt. Aus der rechten Grafik ist zu erkennen, dass das Bild zeilenweise übertragen wird.

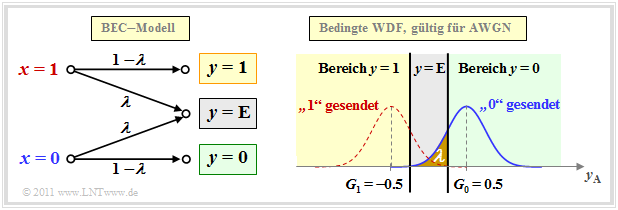

Binary Erasure Channel – BEC

Das BSC–Modell liefert nur die Aussagen „richtig” und „falsch”. Manche Empfänger – so zum Beispiel die so genannten Soft–in Soft–out Decoder – können jedoch auch gewisse Informationen über die Sicherheit der Entscheidung liefern, wobei sie natürlich darüber informiert werden müssen, welche ihrer Eingangswerte sicher sind und welche eher unsicher.

Der Binary Erasure Channel (BEC) liefert eine solche Information. Anhand der Grafik erkennt man:

- Das Eingangsalphabet des BEC–Kanalmodells ist binär ⇒ x ∈ {0, 1} und das Ausgangsalphabet ternär ⇒ y ∈ {0, 1, E}. Ein „E” kennzeichnet eine unsichere Entscheidung. Dieses neue „Symbol” steht für Erasure, zu deutsch: Auslöschung.

- Bitfehler werden durch das BEC–Modell per se ausgeschlossen. Eine unsichere Entscheidung (E) wird mit der Wahrscheinlichkeit λ getroffen, während die Wahrscheinlichkeit für eine richtige (und gleichzeitig sichere) Entscheidung 1 – λ beträgt.

- Rechts oben ist der Zusammenhang zwischen BEC– und AWGN–Kanalmodell dargestellt, wobei das Erasure–Entscheidungsgebiet („E”) grau hinterlegt ist. Man erkennt, dass es im Gegensatz zum BSC–Modell (G = 0) nun zwei Entscheidungsgrenzen G0 = G und G1 = –G gibt, und es gilt:

- \[\lambda = {\rm Q}[\sqrt{\rho} \cdot (1 - G)]\hspace{0.05cm}.\]

Wir weisen hier nochmals auf zwei interaktive Flash–Module hin:

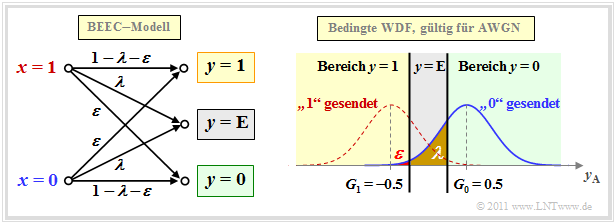

Binary Symmetric Error & Erasure Channel – BSEC

Das BEC–Modell ist aufgrund der Fehlerwahrscheinlichkeit 0 eher unrealistisch und nur eine Näherung für ein extrem großes Signal–zu–Rausch–Leistungsverhältnis (kurz SNR) ρ. Stärkere Störungen ⇒ ein kleineres ρ sollten besser durch den Binary Symmetric Error & Erasure Channel (BSEC) mit den zwei Parametern

- Verfälschungswahrscheinlichkeit ε = Pr (y = 1 | x = 0) = Pr (y = 0 | x = 1),

- Erasure–Wahrscheinlichkeit λ = Pr(y = E | x = 0) = Pr(y = E | x = 1)

modelliert werden. Es gilt auch hier x ∈ {0, 1} und y ∈ {0, 1, E}.

- für σ = 0.5 ⇒ ρ = 4:

- \[\varepsilon \hspace{-0.1cm} = \hspace{-0.1cm} {\rm Q}[\sqrt{\rho} \cdot (1 + G)] = {\rm Q}(3) \approx 0.14\%\hspace{0.05cm},\]

- \[{\it \lambda} \hspace{-0.1cm} = \hspace{-0.1cm} {\rm Q}[\sqrt{\rho} \cdot (1 - G)] - \varepsilon = {\rm Q}(1) - {\rm Q}(3) \approx 15.87\% - 0.14\% = 15.73\%\hspace{0.05cm},\]

- für σ = 0.25 ⇒ ρ = 16:

- \[\varepsilon = {\rm Q}(6) \approx 10^{-10}\hspace{0.05cm},\hspace{0.2cm} {\it \lambda} = {\rm Q}(2) \approx 2.27\%\hspace{0.05cm}.\]

MAP– und ML–Kriterium (1)

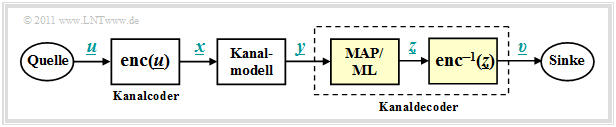

Wir gehen nun von dem nachfolgend skizzierten Modell aus und wenden die bereits im Kapitel 4.2 des Buches „Digitalsignalübertragung” genannten Entscheidungskriterien auf den Decodiervorgang an.

Aufgabe des Kanaldecoders ist es, den Ausgabevektor υ so zu bestimmen, dass er „möglichst gut” mit dem Informationswort u übereinstimmt. Etwas genauer formuliert: Die Blockfehlerwahrscheinlichkeit

\[{\rm Pr(Blockfehler)} = {\rm Pr}(\underline{v} \ne \underline{u}) \]

bezogen auf die Vektoren u und υ der Länge k soll möglichst gering sein. Aufgrund der eindeutigen Zuordnung x = enc(u) durch den Kanalcoder bzw. empfängerseitig υ = enc–1(z) gilt in gleicher Weise:

\[{\rm Pr(Blockfehler)} = {\rm Pr}(\underline{z} \ne \underline{x})\hspace{0.05cm}. \]

Der Kanaldecoder in obigem Modell besteht aus zwei Teilen:

- Der Codewortschätzer ermittelt aus dem Empfangsvektor y einen Schätzwert z ∈ C gemäß einem vorgegebenen Kriterium.

- Anschließend wird aus dem (empfangenen) Codewort z das (empfangene) Informationswort υ durch einfaches Mapping ermittelt, das möglichst mit u übereinstimmen sollte.

Für den Codewortschätzer gibt es insgesamt vier unterschiedliche Varianten, nämlich

- den Maximum–a–posteriori–Empfänger (MAP–Empfänger) für das gesamte Codewort x,

- den Maximum–a–posteriori–Empfänger (MAP–Empfänger) für die einzelnen Codebits xi,

- den Maximum–Likelihood–Empfänger (ML–Empfänger) für das gesamte Codewort x,

- den Maximum–Likelihood–Empfänger (ML–Empfänger) für die einzelnen Codebits xi.

Deren Definitionen folgen auf der nächsten Seite. Vorab aber gleich die wichtige Information:

- Ein MAP–Empfängerberücksichtigt im Gegensatz zum ML–Empfänger auch unterschiedliche Auftrittswahrscheinlichkeiten für das gesamte Codewort bzw. für deren einzelne Bits.

- Sind alle Codeworte bzw. alle Codebits xi der Codeworte gleichwahrscheinlich, so ist der einfachere ML–Empfänger zum entsprechenden MAP–Empfänger äquivalent.

MAP– und ML–Kriterium (2)

\[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.03cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} {\rm Pr}( \underline{x}_{\hspace{0.03cm}i} |\hspace{0.05cm} \underline{y} ) \hspace{0.05cm}.\]

Pr(xi | y) ist die bedingte Wahrscheinlichkeit, dass xi gesendet wurde, wenn y empfangen wird.

Nach dem Satz von Bayes kann die Rückschlusswahrscheinlichkeit wie folgt umgeformt werden:

\[{\rm Pr}( \underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm}|\hspace{0.05cm} \underline{y} ) = \frac{{\rm Pr}( \underline{y} \hspace{0.08cm} |\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) \cdot {\rm Pr}( \underline{x}_{\hspace{0.03cm}i} )}{{\rm Pr}( \underline{y} )} \hspace{0.05cm}.\]

Die Wahrscheinlichkeit Pr(y) ist unabhängig von xi und muss bei der Maximierung nicht berücksichtigt werden. Sind zudem alle 2k Informationsworte ui gleichwahrscheinlich, dann kann bei der Maximierung auch auf den Beitrag Pr(xi) = 2–k im Zähler verzichtet werden.

\[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} {\rm Pr}( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) \hspace{0.05cm}.\]

Die bedingte Wahrscheinlichkeit Pr(y | xi) ist nun in Vorwärtsrichtung zu verstehen, nämlich, dass der Vektor y empfangen wird, wenn das Codewort xi gesendet wurde.

Im Folgenden verwenden wir auf Blockebene stets den ML–Empfänger. Aufgrund der vorausgesetzten gleichwahrscheinlichen Informationsworte liefert auch dieser stets die bestmögliche Entscheidung.

Anders sieht es jedoch auf Bitebene aus. Ziel einer iterativen Decodierung ist es gerade, für alle Codebits xi ∈ {0, 1} Wahrscheinlichkeiten zu schätzen und diese an die nächste Stufe weiterzugeben. Hierzu benötigt man einen MAP–Empfänger.

\[\underline{z} = {\rm arg}\hspace{-0.1cm}{ \max_{{x}_{\hspace{0.03cm}i} \hspace{0.03cm} \in \hspace{0.05cm} \{0, 1\}} \hspace{0.03cm} {\rm Pr}( {x}_{\hspace{0.03cm}i} |\hspace{0.05cm} \underline{y} ) \hspace{0.05cm}}.\]

ML–Entscheidung beim BSC–Kanal

Wenden wir nun das ML–Kriterium auf den gedächtnislosen BSC–Kanal an. Dann gilt:

\[{\rm Pr}( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) = \prod\limits_{l=1}^{n} {\rm Pr}( y_l \hspace{0.05cm}|\hspace{0.05cm} x_l ) \hspace{0.2cm}{\rm mit}\hspace{0.2cm} {\rm Pr}( y_l \hspace{0.05cm}|\hspace{0.05cm} x_l ) = \left\{ \begin{array}{c} 1 - \varepsilon\\ \varepsilon \end{array} \right.\quad \begin{array}{*{1}c} {\rm falls} \hspace{0.15cm} y_l = x_l \hspace{0.05cm},\\ {\rm falls} \hspace{0.15cm}y_l \ne x_l\hspace{0.05cm}.\\ \end{array} \hspace{0.05cm}.\]

\[\Rightarrow \hspace{0.3cm} {\rm Pr}( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{x}_{\hspace{0.03cm}i} ) = \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \hspace{0.05cm}.\]

Dies lässt sich wie folgt begründen:

- Die Hamming–Distanz dH(y, xi) gibt die Anzahl der Bitpositionen an, in denen sich die beiden Worte y und xi mit jeweils n binären Elementen unterscheiden. Beispielsweise ist die Hamming–Distanz zwischen y = (0, 1, 0, 1, 0, 1, 1) und xi = (0, 1, 0, 0, 1, 1, 1) gleich 2.

- In n – dH(y, xi) Positionen unterscheiden sich demnach die beiden Vektoren y und xi nicht. Im obigen Beispiel sind 5 der n = 7 Bit identisch. Zu obiger Gleichung kommt man schließlich durch Einsetzen der Verfälschungswahrscheinlichkeit ε bzw. deren Ergänzung 1 – ε.

Die Vorgehensweise bei der Maximum–Likelihood–Detektion ist, dasjenige Codewort xi zu finden, das die Übergangswahrscheinlichkeit Pr(y | xi) maximiert:

\[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} \left [ \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \right ] \hspace{0.05cm}.\]

Da der Logarithmus eine monoton steigende Funktion ist, erhält man das gleiche Ergebnis nach folgender Maximierung:

\[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} L(\underline{x}_{\hspace{0.03cm}i}) \]

\[{\rm mit}\hspace{0.15cm} L(\underline{x}_{\hspace{0.03cm}i}) \hspace{-0.1cm} = \hspace{-0.1cm} \ln \left [ \varepsilon^{d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \cdot (1-\varepsilon)^{n-d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})} \right ] =\] \[ \hspace{2cm} = \hspace{-0.1cm} d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i}) \cdot \ln \hspace{0.05cm} \varepsilon + [n -d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})] \cdot \ln \hspace{0.05cm} (1- \varepsilon) = \] \[\hspace{2cm} = \hspace{-0.1cm} \ln \frac{\varepsilon}{1-\varepsilon} \cdot d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i}) + n \cdot \ln \hspace{0.05cm} (1- \varepsilon) \hspace{0.05cm}.\]

Der zweite Term dieser Gleichung ist unabhängig von xi und muss für die Maximierung nicht weiter betrachtet werden. Auch der Faktor vor der Hamming–Distanz ist für alle xi gleich. Da aber ln ε/(1 – ε) negativ ist (zumindest für ε < 0.5, was ohne große Einschränkung vorausgestzt werden kann), wird aus der Maximierung eine Minimierung, und man erhält folgendes Endergebnis:

ML–Entscheidung beim BSC–Kanal: Wähle von den 2k zulässigen Codeworten dasjenige mit der geringsten Hamming–Distanz dH(y, xi) zum Empfangsvektor y aus:

\[\underline{z} = {\rm arg} \min_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} d_{\rm H}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})\hspace{0.05cm}, \hspace{0.2cm} \underline{y} \in {\rm GF}(2^n) \hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.\]

Anwendungen der ML/BSC–Entscheidung finden Sie auf den folgenden Seiten:

- Single Parity–check Code (SPC)

- Wiederholungscode (englisch: Repetition Code, RC).

ML–Entscheidung beim AWGN–Kanal

Das AWGN–Modell für einen (n, k)–Blockcode unterscheidet sich vom Modell auf der ersten Seite dieses Kapitels dadurch, dass für x, x̃ und y nun die entsprechenden Vektoren x, x̃ und y verwendet werden müssen, jeweils bestehend aus n Elementen. Die Schritte zur Herleitung des ML–Entscheiders bei AWGN werden nachfolgend nur stichpunktartig angegeben:

- Der AWGN–Kanal ist per se gedächtnislos (hierfür steht das White im Namen), so dass für die bedingte Wahrscheinlichkeitsdichtefunktion geschrieben werden kann:

- \[f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}} ) = \prod\limits_{l=1}^{n} f( y_l \hspace{0.05cm}|\hspace{0.05cm} \tilde{x}_l ) \hspace{0.05cm}.\]

- Die bedingte WDF ist für jedes einzelne Codeelement (l = 1, ... , n) gaußisch. Damit genügt auch die gesamte WDF einer (eindimensionalen) Gaußverteilung:

- \[f({y_l \hspace{0.03cm}| \hspace{0.03cm}\tilde{x}_l }) = \frac {1}{\sqrt{2\pi} \cdot \sigma } \cdot \exp \left [ - \frac {(y_l - \tilde{x}_l)^2}{2\sigma^2} \right ]\]

- \[\Rightarrow \hspace{0.3cm} f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}} ) = \frac {1}{(2\pi)^{n/2} \cdot \sigma^n } \cdot \exp \left [ - \frac {1}{2\sigma^2} \cdot \sum_{l=1}^{n} \hspace{0.2cm}(y_l - \tilde{x}_l)^2 \right ] \hspace{0.05cm}.\]

- Da y nun nicht mehr wie beim BSC–Modell wertdiskret ist, sondern wertkontinuierlich, müssen jetzt entsprechend der ML–Entscheidungsregel Wahrscheinlichkeitsdichten untersucht werden und nicht mehr Wahrscheinlichkeiten. Das optimale Ergebnis lautet:

- \[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} f( \underline{y} \hspace{0.05cm}|\hspace{0.05cm} \underline{\tilde{x}}_i )\hspace{0.05cm}, \hspace{0.8cm} \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.\]

- In der Algebra bezeichnet man den Abstand zweier Punkte y und x̃ im n–dimensionalen Raum als die Euklidische Distanz, benannt nach dem griechischen Mathematiker Euklid, der im dritten Jahrhundert vor Christus lebte:

- \[d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{\tilde{x}}) = \sqrt{\sum_{l=1}^{n} \hspace{0.2cm}(y_l - \tilde{x}_l)^2}\hspace{0.05cm},\hspace{0.8cm} \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in \mathcal{C} \hspace{0.05cm}.\]

- Damit lautet die ML–Entscheidungsregel beim AWGN–Kanal für einen jeden Blockcode unter Berücksichtigung der Tatsache, dass der erste Faktor der WDF f(y | x̃i) konstant ist:

- \[\underline{z} = {\rm arg} \max_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} \exp \left [ - \frac {d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{\tilde{x}}_i)}{2\sigma^2} \right ]\hspace{0.05cm}, \hspace{0.8cm} \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.\]

Nach einigen weiteren Zwischenschritten kommt man zum Ergebnis:

ML–Entscheidung beim AWGN–Kanal: Wähle von den 2k zulässigen Codeworten xi dasjenige mit der kleinsten Euklidischen Distanz zum Empfangsvektor y aus:

\[\underline{z} = {\rm arg} \min_{\underline{x}_{\hspace{0.03cm}i} \hspace{0.05cm} \in \hspace{0.05cm} \mathcal{C}} \hspace{0.1cm} d_{\rm E}(\underline{y} \hspace{0.05cm}, \hspace{0.1cm}\underline{x}_{\hspace{0.03cm}i})\hspace{0.05cm}, \hspace{0.8cm} \underline{y} \in R^n\hspace{0.05cm}, \hspace{0.2cm}\underline{x}_{\hspace{0.03cm}i}\in {\rm GF}(2^n) \hspace{0.05cm}.\]

Aufgaben

A1.4 Maximum–Likelihood–Entscheidung