Stochastische Signaltheorie/Vom Zufallsexperiment zur Zufallsgröße: Unterschied zwischen den Versionen

| (22 dazwischenliegende Versionen von 3 Benutzern werden nicht angezeigt) | |||

| Zeile 6: | Zeile 6: | ||

}} | }} | ||

| − | Dieses Kapitel soll Sie mit diskreten Zufallsgrößen vertraut machen, wobei diese als statistisch unabhängig vorausgesetzt werden. Solche Zufallsgrößen werden in der Nachrichtentechnik zum Beispiel für die Simulation eines binären oder mehrstufigen Digitalsignals benötigt, aber ebenso zur Nachbildung eines Kanals mit statistisch unabhängigen Fehlern durch ein digitales Modell, zum Beispiel dem BSC-Modell. | + | == # ÜBERBLICK ZUM ZWEITEN HAUPTKAPITEL # == |

| + | <br> | ||

| + | Dieses Kapitel soll Sie mit '''diskreten Zufallsgrößen''' vertraut machen, wobei diese als statistisch unabhängig vorausgesetzt werden. Solche Zufallsgrößen werden in der Nachrichtentechnik zum Beispiel für die Simulation eines binären oder mehrstufigen Digitalsignals benötigt, aber ebenso zur Nachbildung eines Kanals mit statistisch unabhängigen Fehlern durch ein digitales Modell, zum Beispiel dem BSC-Modell. | ||

| + | |||

| + | Im Einzelnen werden behandelt: | ||

| + | *der »Zusammenhang zwischen Wahrscheinlichkeit und relativer Häufigkeit«, | ||

| + | *die »Erwartungswerte und Momente«, | ||

| + | *die »Binomial- und die Poissonverteilung« als Sonderfälle diskreter Verteilungen, | ||

| + | *die »Erzeugung pseudozufälliger Binärsymbole« mittels »PN-Generatoren«, und | ||

| + | *die »Erzeugung mehrstufiger Zufallsgrößen« an einem Digitalrechner. | ||

| + | |||

| + | |||

Weitere Informationen zum Thema „Diskrete Zufallsgrößen” sowie Aufgaben, Simulationen und Programmierübungen finden Sie im | Weitere Informationen zum Thema „Diskrete Zufallsgrößen” sowie Aufgaben, Simulationen und Programmierübungen finden Sie im | ||

| − | *Kapitel 1: Diskrete Zufallsgrößen (Programm dis) | + | *Kapitel 1: Diskrete Zufallsgrößen (Programm dis) |

| − | *Kapitel 2: Pseudonoise-Generatoren (Programm png) | + | *Kapitel 2: Pseudonoise-Generatoren (Programm png) |

| + | |||

| + | |||

| + | des Praktikums „Simulationsmethoden in der Nachrichtentechnik”. Diese (ehemalige) LNT-Lehrveranstaltung an der TU München basiert auf | ||

| + | |||

| + | *dem Lehrsoftwarepaket [http://www.lntwww.de/downloads/Sonstiges/Programme/LNTsim.zip LNTsim] ⇒ Link verweist auf die ZIP-Version des Programms, und | ||

| + | *der zugehörigen [http://www.lntwww.de/downloads/Sonstiges/Texte/Praktikum_LNTsim_Teil_A.pdf Praktikumsanleitung] ⇒ Link verweist auf die PDF-Version; Kapitel 1 und 2: Seite 7-32. | ||

| + | |||

| − | |||

| − | |||

| − | |||

==Zum Begriff der Zufallsgröße== | ==Zum Begriff der Zufallsgröße== | ||

| − | + | <br> | |

| + | Im ersten Kapitel dieses Buches wurde bereits der Begriff [[Stochastische_Signaltheorie/Einige_grundlegende_Definitionen|Zufallsexperiment]] erläutert. Darunter versteht man einen unter gleichen Bedingungen beliebig oft wiederholbaren Versuch mit ungewissem Ergebnis $E$, bei dem jedoch die Menge $\{E_μ \}$ der möglichen Ergebnisse angebbar ist. | ||

| − | Häufig sind die Versuchsergebnisse Zahlenwerte, | + | Häufig sind die Versuchsergebnisse Zahlenwerte, wie zum Beispiel beim Zufallsexperiment „Werfen eines Würfels”. Dagegen liefert das Experiment „Münzwurf” die möglichen Ergebnisse „Zahl” und „Bild”. |

| − | Zur einheitlichen Beschreibung verschiedenartiger Experimente und auch wegen der besseren Handhabbarkeit verwendet man den Begriff | + | Zur einheitlichen Beschreibung verschiedenartiger Experimente und auch wegen der besseren Handhabbarkeit verwendet man den Begriff der „Zufallsgröße”, oft auch als „Zufallsvariable” bezeichnet. |

| − | {{Definition | + | {{BlaueBox|TEXT= |

| − | + | [[Datei: P_ID455__Sto_T_2_1_S1_neu.png|right| |frame| Zur Definition der Zufallsgröße]] | |

| + | $\text{Definition:}$ | ||

| − | + | *Eine '''Zufallsgröße''' $z$ ist eine ein-eindeutige Abbildung der Ergebnismenge $\{E_μ \}$ auf die Menge der reellen Zahlen. | |

| − | |||

| − | { | ||

| + | |||

| + | *Ergänzend zu dieser Definition wird noch zugelassen, dass die Zufallsgröße neben dem Zahlenwert auch eine Einheit besitzt.}} | ||

Nachfolgend werden einige Beispiele für Zufallsgrößen genannt: | Nachfolgend werden einige Beispiele für Zufallsgrößen genannt: | ||

| − | *Beim Zufallsexperiment | + | *Beim Zufallsexperiment „Werfen einer Roulettekugel” hat eine Unterscheidung zwischen $E$ und $z$ keine praktischen Auswirkungen, kann aber aus formalen Gründen durchaus sinnvoll sein. So bezeichnet $E_μ = 8$, dass die Kugel in der mit „8“ markierten Vertiefung der Roulettescheibe zum Liegen gekommen ist. Arithmetische Operationen (zum Beispiel eine Erwartungswertbildung) sind anhand der Ergebnisse nicht möglich. '''–''' Dagegen bezeichnet die Zufallsgröße $z$ tatsächlich einen Zahlenwert $($hier ganzzahlig zwischen $0$ und $36)$, aus dem der zu erwartende Mittelwert der Zufallsgröße $($hier $18)$ ermittelt werden kann. Durchaus möglich, aber nicht sinnvoll wäre zum Beispiel die Zuordnung $E_μ = 8$ ⇔ $z_μ ≠ 8$. |

| − | *Beim Experiment | + | *Beim Experiment „Münzwurf” sind die möglichen Ergebnisse „Zahl” und „Bild”, worauf per se keine arithmetische Operationen angewendet werden können. Erst durch die zwar willkürliche, aber ein-eindeutige Zuordnung zwischen der Ereignismenge $\{E_μ\} = \{$„Zahl”, „Bild”$ \}$ und der Zahlenmenge $\{z_μ\} = \{0, 1\}$ kann hier überhaupt ein Kennwert angegeben werden. Ebenso könnte man aber auch die Zuordnung „Bild” ⇔ $0$ und „Zahl” ⇔ $1$ festlegen. |

| − | *In der Schaltungstechnik bezeichnet man die beiden möglichen logischen Zustände einer Speicherzelle | + | *In der Schaltungstechnik bezeichnet man die beiden möglichen logischen Zustände einer Speicherzelle (Flipflops) gemäß den möglichen Spannungspegeln mit $\rm L$ ("Low") und $\rm H$ ("High"). Diese Bezeichnungen übernehmen wir hier auch für Binärsymbole. Für praktische Arbeiten bildet man diese Symbole meist wieder auf Zufallsgrößen ab, wobei auch diese Zuordnung willkürlich ist, aber sinnvoll sein sollte. |

| + | *In der Codierungstheorie wird sinnvollerweise $\{ \text{L, H}\}$ auf $\{0, 1\}$ abgebildet, um die Möglichkeiten der Modulo-Algebra nutzen zu können. Zur Beschreibung der Modulation mit bipolaren (antipodalen) Signalen wählt man dagegen besser die Zuordnung $\{ \text{L, H}\}$ ⇔ $ \{-1, +1\}$. | ||

==Kontinuierliche und diskrete Zufallsgrößen== | ==Kontinuierliche und diskrete Zufallsgrößen== | ||

| − | Nach den möglichen Zahlenwerten $z_μ = z(E_μ)$ unterscheiden wir hier zwischen kontinuierlichen und diskreten Zufallsgrößen: | + | <br> |

| − | *Eine kontinuierliche Zufallsgröße $z$ kann – zumindest in gewissen Bereichen – unendlich viele verschiedene Werte annehmen. Genauer gesagt: Die Menge der zulässigen Werte ist bei solchen Größen auch nicht abzählbar. Beispiele für kontinuierliche Zufallsgrößen sind die Geschwindigkeit eines Autos (bei angemessener Fahrweise zwischen 0 und 120 km/h) oder auch die Rauschspannung bei einem Nachrichtensystem. Beide Zufallsgrößen haben neben einem Zahlenwert auch eine Einheit. | + | {{BlaueBox|TEXT= |

| − | *Ist dagegen die Menge { | + | $\text{Definition:}$ Nach den möglichen Zahlenwerten $z_μ = z(E_μ)$ unterscheiden wir hier zwischen kontinuierlichen und diskreten Zufallsgrößen: |

| + | *Eine '''kontinuierliche Zufallsgröße''' $z$ kann – zumindest in gewissen Bereichen – unendlich viele verschiedene Werte annehmen. Genauer gesagt: Die Menge der zulässigen Werte ist bei solchen Größen auch nicht abzählbar. | ||

| + | *Beispiele für kontinuierliche Zufallsgrößen sind die Geschwindigkeit eines Autos $($bei angemessener Fahrweise zwischen $v = 0$ und $v = 120 \ \rm km/h)$ oder auch die Rauschspannung bei einem Nachrichtensystem. Beide Zufallsgrößen haben neben einem Zahlenwert auch eine Einheit. | ||

| + | *Ist dagegen die Menge $\{z_μ\}$ abzählbar, so handelt es sich um eine '''diskrete Zufallsgröße'''. Meist ist die Zahl der möglichen Werte von $z$ auf $M$ begrenzt. In der Nachrichtentechnik nennt man $M$ den "Symbolumfang" (im Sinne der Codierungstheorie) bzw. die "Stufenzahl" (aus Sicht der Übertragungstechnik). }} | ||

| − | Zunächst beschränken wir uns auf diskrete, $M$ | + | Zunächst beschränken wir uns auf diskrete, $M$–stufige Zufallsgrößen ohne innere statistischen Bindungen, die gemäß dem Abschnitt [[Stochastische_Signaltheorie/Einige_grundlegende_Definitionen|Einige grundlegende Definitionen]] durch die $M$ Auftrittswahrscheinlichkeiten $p_μ ={\rm Pr}(z = z_μ)$ vollständig charakterisiert sind. Per Definition ist die Summe über alle $M$ Wahrscheinlichkeiten gleich $1$. |

| − | Dagegen ist die Wahrscheinlichkeit Pr( | + | Dagegen ist die Wahrscheinlichkeit ${\rm Pr}(z = z_μ)$ dafür, dass eine kontinuierliche Zufallsgröße $z$ einen ganz bestimmten Wert $z_μ$ annimmt, identisch Null. Hier muss, wie im folgenden Kapitel [[Stochastische_Signaltheorie/Wahrscheinlichkeitsdichtefunktion_(WDF)|Kontinuierliche Zufallsgrößen]] beschrieben wird, auf die "Wahrscheinlichkeitsdichtefunktion" $\rm (WDF)$ übergegangen werden. |

==Zufallsprozess und Zufallsfolge== | ==Zufallsprozess und Zufallsfolge== | ||

| − | Ein Zufallsprozess unterscheidet sich | + | <br> |

| − | + | {{BlaueBox|TEXT= | |

| − | + | $\text{Definition:}$ | |

| − | + | Ein '''Zufallsprozess''' unterscheidet sich vom bisher betrachteten Zufallsexperiment dadurch, | |

| − | + | *dass er nicht nur ein Ergebnis (Ereignis) liefert, | |

| − | + | *sondern eine „zeitliche Folge von Ergebnissen” (Ereignissen). }} | |

| − | |||

| − | + | Damit kommt man zur '''Zufallsfolge''' $\langle z_ν\rangle$ mit den folgenden für unsere Darstellung festgelegten Eigenschaften: | |

| + | *Die Laufvariable $ν$ beschreibt den zeitlichen Prozessablauf und kann Werte zwischen $1$ und $N$ annehmen. Häufig wird eine solche Folge auch als $N$–dimensionaler Vektor dargestellt. | ||

| + | *Zu jeder Zeit $ν$ kann die Zufallsgröße $z_ν$ einen von $M$ verschiedenen Werten annehmen. Wir verwenden hierfür folgende Nomenklatur: | ||

| + | :$$z_\nu \in z_\mu \hspace{0.3cm} {\rm mit} \hspace{0.3cm} \nu = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm}, N \hspace{0.3cm} {\rm und} \hspace{0.3cm} \mu = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm} , M.$$ | ||

| + | *Ist der Prozess [[Stochastische_Signaltheorie/Autokorrelationsfunktion_(AKF)#Ergodische_Zufallsprozesse|ergodisch]], so weist jede Zufallsfolge $\langle z_ν\rangle$ die gleichen statistischen Eigenschaften auf und kann als Repräsentant für den gesamten Zufallsprozess herangezogen werden. | ||

| + | *Wir setzen hier zunächst voraus, dass zwischen den einzelnen Folgenelementen keine statistischen Bindungen bestehen, das heißt, es gilt für die [[Stochastische_Signaltheorie/Statistische_Abhängigkeit_und_Unabhängigkeit#Bedingte_Wahrscheinlichkeit|bedingten Wahrscheinlichkeiten]]: | ||

| + | :$${\rm Pr}(z_\nu | z_{\nu \rm{ -1}} \hspace{0.1cm}\text{...} \hspace{0.1cm}z_{\rm 1})={\rm Pr}(z_\nu).$$ | ||

| − | {{Beispiel} | + | Mehr und vor allem Genaueres zu der Charakterisierung von Zufallsprozessen finden Sie im späteren Kapitel [[Stochastische_Signaltheorie/Autokorrelationsfunktion_(AKF)|Autokorrelationsfunktion]]. |

| − | Wiederholt man das Zufallsexperiment | + | |

| − | + | {{GraueBox|TEXT= | |

| + | $\text{Beispiel 1:}$ | ||

| + | Wiederholt man das Zufallsexperiment „Werfen einer Roulettekugel” zehnmal, so ergibt sich zum Beispiel folgende Zufallsfolge: | ||

| + | :$$\langle z_ν\rangle = \langle \ 8; \ 23; \ 0; \ 17; \ 36; \ 0; \ 33; \ 11; \ 11; \ 25 \ \rangle.$$ | ||

| + | Zu jedem Zeitpunkt sind trotzdem – unabhängig von der Vergangenheit – alle Zufallsgrößen zwischen $0$ und $36$ möglich und auch gleichwahrscheinlich, was aber aus einer solch kurzen Folge nicht abgelesen werden kann.}} | ||

==Bernoullisches Gesetz der großen Zahlen== | ==Bernoullisches Gesetz der großen Zahlen== | ||

| − | Zur Beschreibung einer $M$ | + | <br> |

| − | *Die Wahrscheinlichkeiten $p_μ = | + | {{BlaueBox|TEXT= |

| − | *Die relativen Häufigkeiten $h_μ^{(N)}$ sind | + | $\text{Definitionen:}$ Zur Beschreibung einer $M$–stufigen Zufallsgröße verwendet man folgende Beschreibungsgrößen, deren Summe über alle $μ = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm} , M$ jeweils den Wert $1$ ergeben: |

| − | $$h_{\mu}^{(N)} = \frac{n_{\mu}}{N}= | + | *Die '''Wahrscheinlichkeiten''' $p_μ = {\rm Pr}(z = z_μ)$ liefern Vorhersagen über das zu erwartende Ergebnis eines statistischen Versuchs und sind somit so genannte "A-priori-Kenngrößen". |

| − | \frac{{\rm Anzahl \hspace{0.15cm}der \hspace{0.15cm}Versuche \hspace{0.15cm}mit \hspace{0.15cm}dem\hspace{0.15cm} Ergebnis\hspace{0.15cm}}z_{\mu}} | + | *Die '''relativen Häufigkeiten''' $h_μ^{(N)}$ sind "A-posteriori-Kenngrößen" und erlauben statistische Aussagen bezüglich eines vorher durchgeführten Versuches. Sie werden wie folgt ermittelt: |

| − | {{\rm Anzahl \hspace{0.15cm}aller \hspace{0.15cm}Versuche }} \hspace{1cm}(\mu=1,...,M).$$ | + | :$$h_{\mu}^{(N)} = \frac{n_{\mu} }{N}= |

| + | \frac{ {\rm Anzahl \hspace{0.15cm}der \hspace{0.15cm}Versuche \hspace{0.15cm}mit \hspace{0.15cm}dem\hspace{0.15cm} Ergebnis\hspace{0.15cm} }z_{\mu} } | ||

| + | { {\rm Anzahl \hspace{0.15cm}aller \hspace{0.15cm}Versuche } } \hspace{1cm}(\mu=1,\hspace{0.1cm}\text{...} \hspace{0.1cm},M).$$}} | ||

| + | |||

| + | |||

| + | Nur im Grenzfall $N → ∞$ stimmen die relativen Häufigkeiten mit den entsprechenden Wahrscheinlichkeiten „exakt” überein, zumindest im statistischen Sinne. Dagegen gilt nach dem von [https://de.wikipedia.org/wiki/Jakob_I._Bernoulli Jakob I. Bernoulli] formulierten „Gesetz der großen Zahlen” für endliche Werte von $N$: | ||

| + | :$$\rm Pr \left( \it \mid h_\mu^{(N)} - p_\mu\mid \hspace{0.1cm} \ge \varepsilon \hspace{0.1cm} \right) \le \frac{1}{\rm 4\cdot \it N\cdot \varepsilon^{\rm 2}}.$$ | ||

| + | |||

| + | Daraus folgt auch die Aussage, dass bei unendlich langen Zufallsfolgen $(N → ∞)$ die relativen Häufigkeiten $h_μ^{(N)}$ und die Wahrscheinlichkeiten $p_μ$ mit der Wahrscheinlichkeit $1$ identisch sind. | ||

| + | |||

| + | {{GraueBox|TEXT= | ||

| + | $\text{Beispiel 2:}$ Eine Binärdatei besteht aus $N = 10^6$ Binärsymbolen („Bit”), wobei die Nullen und Einsen gleichwahrscheinlich sind: $p_0 = p_1 = 0.5$. | ||

| + | :Das Bernoullische Gesetz der großen Zahlen $($mit $\varepsilon = 0.01)$ besagt nun, dass die Wahrscheinlichkeit des Ereignisses „die Anzahl der Einsen in der Datei liegt zwischen $495 \hspace{0.05cm}000$ und $505\hspace{0.05cm}000$” größer oder gleich $1 - 1/400 = 99.75\%$ ist. }} | ||

| − | |||

| − | |||

| − | + | Die Wahrscheinlichkeit, dass sich die relative Häufigkeit $h_μ^{(N)}$ eines Ereignisses $E_μ$ und die zugehörige Wahrscheinlichkeit $p_μ$ betragsmäßig um mehr als einen Wert $\varepsilon$ unterscheiden, ist nach obiger Gleichung nicht größer als $1/(4 · N · ε^2)$. Für ein gegebenes $\varepsilon$ und eine zu garantierende Wahrscheinlichkeit kann daraus der minimal erforderliche Wert von $N$ berechnet werden. | |

| − | + | Weiter ist anzumerken: | |

| − | + | *Der monotone Abfall mit $N$ gilt nur im statistischen Sinne und nicht für jede einzelne Realisierung. | |

| − | + | *So können beim Experiment „Münzwurf” durchaus nach $N = 1000$ Würfen die relative Häufigkeiten von „Zahl” und „Bild” exakt gleich $0.5$ sein (wenn $n_{\rm Zahl} = n_{\rm Bild} = 500$ ist) und nach $N = 2000$ Würfen wieder mehr oder weniger stark davon abweichen. | |

| + | *Führen mehrere Probanden parallel dass Experiment „Münzwurf” durch und stellt man jeweils die relative Häufigkeit in Abhängigkeit von $N$ dar, so ergeben sich dementsprechend Kurvenverläufe, die zwar tendenziell, aber nicht monoton abfallen. | ||

| + | *Berechnet man aber den Mittelwert über unendlich viele solcher Kurven, so erhält man den monoton mit $N$ abfallenden Verlauf gemäß der Bernouillischen Vorhersage. | ||

| − | + | Mit dieser Thematik, speziell mit dem Experiment von [https://de.wikipedia.org/wiki/Karl_Pearson Karl Pearson], beschäftigt sich das Lernvideo [[Bernoullisches_Gesetz_der_großen_Zahlen_(Lernvideo)|Bernoullisches Gesetz der großen Zahlen]]. | |

| − | |||

| − | |||

| − | |||

| + | ==Aufgaben zum Kapitel== | ||

| + | <br> | ||

| + | [[Aufgaben:2.1 Wahlnachfrage|Aufgabe 2.1: Wahlnachfrage]] | ||

| + | [[Aufgaben:2.1Z_Signalverläufe|Aufgabe 2.1Z: Signalverläufe]] | ||

| − | |||

| − | |||

{{Display}} | {{Display}} | ||

Aktuelle Version vom 3. Dezember 2021, 15:17 Uhr

Inhaltsverzeichnis

# ÜBERBLICK ZUM ZWEITEN HAUPTKAPITEL #

Dieses Kapitel soll Sie mit diskreten Zufallsgrößen vertraut machen, wobei diese als statistisch unabhängig vorausgesetzt werden. Solche Zufallsgrößen werden in der Nachrichtentechnik zum Beispiel für die Simulation eines binären oder mehrstufigen Digitalsignals benötigt, aber ebenso zur Nachbildung eines Kanals mit statistisch unabhängigen Fehlern durch ein digitales Modell, zum Beispiel dem BSC-Modell.

Im Einzelnen werden behandelt:

- der »Zusammenhang zwischen Wahrscheinlichkeit und relativer Häufigkeit«,

- die »Erwartungswerte und Momente«,

- die »Binomial- und die Poissonverteilung« als Sonderfälle diskreter Verteilungen,

- die »Erzeugung pseudozufälliger Binärsymbole« mittels »PN-Generatoren«, und

- die »Erzeugung mehrstufiger Zufallsgrößen« an einem Digitalrechner.

Weitere Informationen zum Thema „Diskrete Zufallsgrößen” sowie Aufgaben, Simulationen und Programmierübungen finden Sie im

- Kapitel 1: Diskrete Zufallsgrößen (Programm dis)

- Kapitel 2: Pseudonoise-Generatoren (Programm png)

des Praktikums „Simulationsmethoden in der Nachrichtentechnik”. Diese (ehemalige) LNT-Lehrveranstaltung an der TU München basiert auf

- dem Lehrsoftwarepaket LNTsim ⇒ Link verweist auf die ZIP-Version des Programms, und

- der zugehörigen Praktikumsanleitung ⇒ Link verweist auf die PDF-Version; Kapitel 1 und 2: Seite 7-32.

Zum Begriff der Zufallsgröße

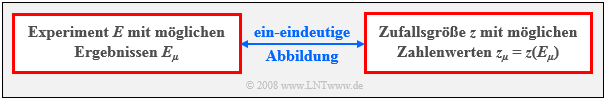

Im ersten Kapitel dieses Buches wurde bereits der Begriff Zufallsexperiment erläutert. Darunter versteht man einen unter gleichen Bedingungen beliebig oft wiederholbaren Versuch mit ungewissem Ergebnis $E$, bei dem jedoch die Menge $\{E_μ \}$ der möglichen Ergebnisse angebbar ist.

Häufig sind die Versuchsergebnisse Zahlenwerte, wie zum Beispiel beim Zufallsexperiment „Werfen eines Würfels”. Dagegen liefert das Experiment „Münzwurf” die möglichen Ergebnisse „Zahl” und „Bild”.

Zur einheitlichen Beschreibung verschiedenartiger Experimente und auch wegen der besseren Handhabbarkeit verwendet man den Begriff der „Zufallsgröße”, oft auch als „Zufallsvariable” bezeichnet.

$\text{Definition:}$

- Eine Zufallsgröße $z$ ist eine ein-eindeutige Abbildung der Ergebnismenge $\{E_μ \}$ auf die Menge der reellen Zahlen.

- Ergänzend zu dieser Definition wird noch zugelassen, dass die Zufallsgröße neben dem Zahlenwert auch eine Einheit besitzt.

Nachfolgend werden einige Beispiele für Zufallsgrößen genannt:

- Beim Zufallsexperiment „Werfen einer Roulettekugel” hat eine Unterscheidung zwischen $E$ und $z$ keine praktischen Auswirkungen, kann aber aus formalen Gründen durchaus sinnvoll sein. So bezeichnet $E_μ = 8$, dass die Kugel in der mit „8“ markierten Vertiefung der Roulettescheibe zum Liegen gekommen ist. Arithmetische Operationen (zum Beispiel eine Erwartungswertbildung) sind anhand der Ergebnisse nicht möglich. – Dagegen bezeichnet die Zufallsgröße $z$ tatsächlich einen Zahlenwert $($hier ganzzahlig zwischen $0$ und $36)$, aus dem der zu erwartende Mittelwert der Zufallsgröße $($hier $18)$ ermittelt werden kann. Durchaus möglich, aber nicht sinnvoll wäre zum Beispiel die Zuordnung $E_μ = 8$ ⇔ $z_μ ≠ 8$.

- Beim Experiment „Münzwurf” sind die möglichen Ergebnisse „Zahl” und „Bild”, worauf per se keine arithmetische Operationen angewendet werden können. Erst durch die zwar willkürliche, aber ein-eindeutige Zuordnung zwischen der Ereignismenge $\{E_μ\} = \{$„Zahl”, „Bild”$ \}$ und der Zahlenmenge $\{z_μ\} = \{0, 1\}$ kann hier überhaupt ein Kennwert angegeben werden. Ebenso könnte man aber auch die Zuordnung „Bild” ⇔ $0$ und „Zahl” ⇔ $1$ festlegen.

- In der Schaltungstechnik bezeichnet man die beiden möglichen logischen Zustände einer Speicherzelle (Flipflops) gemäß den möglichen Spannungspegeln mit $\rm L$ ("Low") und $\rm H$ ("High"). Diese Bezeichnungen übernehmen wir hier auch für Binärsymbole. Für praktische Arbeiten bildet man diese Symbole meist wieder auf Zufallsgrößen ab, wobei auch diese Zuordnung willkürlich ist, aber sinnvoll sein sollte.

- In der Codierungstheorie wird sinnvollerweise $\{ \text{L, H}\}$ auf $\{0, 1\}$ abgebildet, um die Möglichkeiten der Modulo-Algebra nutzen zu können. Zur Beschreibung der Modulation mit bipolaren (antipodalen) Signalen wählt man dagegen besser die Zuordnung $\{ \text{L, H}\}$ ⇔ $ \{-1, +1\}$.

Kontinuierliche und diskrete Zufallsgrößen

$\text{Definition:}$ Nach den möglichen Zahlenwerten $z_μ = z(E_μ)$ unterscheiden wir hier zwischen kontinuierlichen und diskreten Zufallsgrößen:

- Eine kontinuierliche Zufallsgröße $z$ kann – zumindest in gewissen Bereichen – unendlich viele verschiedene Werte annehmen. Genauer gesagt: Die Menge der zulässigen Werte ist bei solchen Größen auch nicht abzählbar.

- Beispiele für kontinuierliche Zufallsgrößen sind die Geschwindigkeit eines Autos $($bei angemessener Fahrweise zwischen $v = 0$ und $v = 120 \ \rm km/h)$ oder auch die Rauschspannung bei einem Nachrichtensystem. Beide Zufallsgrößen haben neben einem Zahlenwert auch eine Einheit.

- Ist dagegen die Menge $\{z_μ\}$ abzählbar, so handelt es sich um eine diskrete Zufallsgröße. Meist ist die Zahl der möglichen Werte von $z$ auf $M$ begrenzt. In der Nachrichtentechnik nennt man $M$ den "Symbolumfang" (im Sinne der Codierungstheorie) bzw. die "Stufenzahl" (aus Sicht der Übertragungstechnik).

Zunächst beschränken wir uns auf diskrete, $M$–stufige Zufallsgrößen ohne innere statistischen Bindungen, die gemäß dem Abschnitt Einige grundlegende Definitionen durch die $M$ Auftrittswahrscheinlichkeiten $p_μ ={\rm Pr}(z = z_μ)$ vollständig charakterisiert sind. Per Definition ist die Summe über alle $M$ Wahrscheinlichkeiten gleich $1$.

Dagegen ist die Wahrscheinlichkeit ${\rm Pr}(z = z_μ)$ dafür, dass eine kontinuierliche Zufallsgröße $z$ einen ganz bestimmten Wert $z_μ$ annimmt, identisch Null. Hier muss, wie im folgenden Kapitel Kontinuierliche Zufallsgrößen beschrieben wird, auf die "Wahrscheinlichkeitsdichtefunktion" $\rm (WDF)$ übergegangen werden.

Zufallsprozess und Zufallsfolge

$\text{Definition:}$ Ein Zufallsprozess unterscheidet sich vom bisher betrachteten Zufallsexperiment dadurch,

- dass er nicht nur ein Ergebnis (Ereignis) liefert,

- sondern eine „zeitliche Folge von Ergebnissen” (Ereignissen).

Damit kommt man zur Zufallsfolge $\langle z_ν\rangle$ mit den folgenden für unsere Darstellung festgelegten Eigenschaften:

- Die Laufvariable $ν$ beschreibt den zeitlichen Prozessablauf und kann Werte zwischen $1$ und $N$ annehmen. Häufig wird eine solche Folge auch als $N$–dimensionaler Vektor dargestellt.

- Zu jeder Zeit $ν$ kann die Zufallsgröße $z_ν$ einen von $M$ verschiedenen Werten annehmen. Wir verwenden hierfür folgende Nomenklatur:

- $$z_\nu \in z_\mu \hspace{0.3cm} {\rm mit} \hspace{0.3cm} \nu = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm}, N \hspace{0.3cm} {\rm und} \hspace{0.3cm} \mu = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm} , M.$$

- Ist der Prozess ergodisch, so weist jede Zufallsfolge $\langle z_ν\rangle$ die gleichen statistischen Eigenschaften auf und kann als Repräsentant für den gesamten Zufallsprozess herangezogen werden.

- Wir setzen hier zunächst voraus, dass zwischen den einzelnen Folgenelementen keine statistischen Bindungen bestehen, das heißt, es gilt für die bedingten Wahrscheinlichkeiten:

- $${\rm Pr}(z_\nu | z_{\nu \rm{ -1}} \hspace{0.1cm}\text{...} \hspace{0.1cm}z_{\rm 1})={\rm Pr}(z_\nu).$$

Mehr und vor allem Genaueres zu der Charakterisierung von Zufallsprozessen finden Sie im späteren Kapitel Autokorrelationsfunktion.

$\text{Beispiel 1:}$ Wiederholt man das Zufallsexperiment „Werfen einer Roulettekugel” zehnmal, so ergibt sich zum Beispiel folgende Zufallsfolge:

- $$\langle z_ν\rangle = \langle \ 8; \ 23; \ 0; \ 17; \ 36; \ 0; \ 33; \ 11; \ 11; \ 25 \ \rangle.$$

Zu jedem Zeitpunkt sind trotzdem – unabhängig von der Vergangenheit – alle Zufallsgrößen zwischen $0$ und $36$ möglich und auch gleichwahrscheinlich, was aber aus einer solch kurzen Folge nicht abgelesen werden kann.

Bernoullisches Gesetz der großen Zahlen

$\text{Definitionen:}$ Zur Beschreibung einer $M$–stufigen Zufallsgröße verwendet man folgende Beschreibungsgrößen, deren Summe über alle $μ = 1,\hspace{0.1cm}\text{...} \hspace{0.1cm} , M$ jeweils den Wert $1$ ergeben:

- Die Wahrscheinlichkeiten $p_μ = {\rm Pr}(z = z_μ)$ liefern Vorhersagen über das zu erwartende Ergebnis eines statistischen Versuchs und sind somit so genannte "A-priori-Kenngrößen".

- Die relativen Häufigkeiten $h_μ^{(N)}$ sind "A-posteriori-Kenngrößen" und erlauben statistische Aussagen bezüglich eines vorher durchgeführten Versuches. Sie werden wie folgt ermittelt:

- $$h_{\mu}^{(N)} = \frac{n_{\mu} }{N}= \frac{ {\rm Anzahl \hspace{0.15cm}der \hspace{0.15cm}Versuche \hspace{0.15cm}mit \hspace{0.15cm}dem\hspace{0.15cm} Ergebnis\hspace{0.15cm} }z_{\mu} } { {\rm Anzahl \hspace{0.15cm}aller \hspace{0.15cm}Versuche } } \hspace{1cm}(\mu=1,\hspace{0.1cm}\text{...} \hspace{0.1cm},M).$$

Nur im Grenzfall $N → ∞$ stimmen die relativen Häufigkeiten mit den entsprechenden Wahrscheinlichkeiten „exakt” überein, zumindest im statistischen Sinne. Dagegen gilt nach dem von Jakob I. Bernoulli formulierten „Gesetz der großen Zahlen” für endliche Werte von $N$:

- $$\rm Pr \left( \it \mid h_\mu^{(N)} - p_\mu\mid \hspace{0.1cm} \ge \varepsilon \hspace{0.1cm} \right) \le \frac{1}{\rm 4\cdot \it N\cdot \varepsilon^{\rm 2}}.$$

Daraus folgt auch die Aussage, dass bei unendlich langen Zufallsfolgen $(N → ∞)$ die relativen Häufigkeiten $h_μ^{(N)}$ und die Wahrscheinlichkeiten $p_μ$ mit der Wahrscheinlichkeit $1$ identisch sind.

$\text{Beispiel 2:}$ Eine Binärdatei besteht aus $N = 10^6$ Binärsymbolen („Bit”), wobei die Nullen und Einsen gleichwahrscheinlich sind: $p_0 = p_1 = 0.5$.

- Das Bernoullische Gesetz der großen Zahlen $($mit $\varepsilon = 0.01)$ besagt nun, dass die Wahrscheinlichkeit des Ereignisses „die Anzahl der Einsen in der Datei liegt zwischen $495 \hspace{0.05cm}000$ und $505\hspace{0.05cm}000$” größer oder gleich $1 - 1/400 = 99.75\%$ ist.

Die Wahrscheinlichkeit, dass sich die relative Häufigkeit $h_μ^{(N)}$ eines Ereignisses $E_μ$ und die zugehörige Wahrscheinlichkeit $p_μ$ betragsmäßig um mehr als einen Wert $\varepsilon$ unterscheiden, ist nach obiger Gleichung nicht größer als $1/(4 · N · ε^2)$. Für ein gegebenes $\varepsilon$ und eine zu garantierende Wahrscheinlichkeit kann daraus der minimal erforderliche Wert von $N$ berechnet werden.

Weiter ist anzumerken:

- Der monotone Abfall mit $N$ gilt nur im statistischen Sinne und nicht für jede einzelne Realisierung.

- So können beim Experiment „Münzwurf” durchaus nach $N = 1000$ Würfen die relative Häufigkeiten von „Zahl” und „Bild” exakt gleich $0.5$ sein (wenn $n_{\rm Zahl} = n_{\rm Bild} = 500$ ist) und nach $N = 2000$ Würfen wieder mehr oder weniger stark davon abweichen.

- Führen mehrere Probanden parallel dass Experiment „Münzwurf” durch und stellt man jeweils die relative Häufigkeit in Abhängigkeit von $N$ dar, so ergeben sich dementsprechend Kurvenverläufe, die zwar tendenziell, aber nicht monoton abfallen.

- Berechnet man aber den Mittelwert über unendlich viele solcher Kurven, so erhält man den monoton mit $N$ abfallenden Verlauf gemäß der Bernouillischen Vorhersage.

Mit dieser Thematik, speziell mit dem Experiment von Karl Pearson, beschäftigt sich das Lernvideo Bernoullisches Gesetz der großen Zahlen.

Aufgaben zum Kapitel