Kanalcodierung/Grundlegendes zu den Low–density Parity–check Codes: Unterschied zwischen den Versionen

| (8 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) | |||

| Zeile 8: | Zeile 8: | ||

== Einige Charakteristika der LDPC–Codes == | == Einige Charakteristika der LDPC–Codes == | ||

<br> | <br> | ||

| − | Die <i>Low–density Parity–check Codes</i> – kurz LDPC–Codes – wurden bereits Anfang der 1960er Jahre erfunden und gehen auf die Dissertation [Gal63]<ref name ='Gal63'>Gallager, R. G.: ''Low–density Parity–check Codes.'' MIT Press, Cambridge, MA, 1963.</ref> von [https://de.wikipedia.org/wiki/Robert_Gray_Gallager Robert G. Gallager] zurück.<br> | + | Die <i>Low–density Parity–check Codes</i> – kurz '''LDPC–Codes''' – wurden bereits Anfang der 1960er Jahre erfunden und gehen auf die Dissertation [Gal63]<ref name ='Gal63'>Gallager, R. G.: ''Low–density Parity–check Codes.'' MIT Press, Cambridge, MA, 1963.</ref> von [https://de.wikipedia.org/wiki/Robert_Gray_Gallager Robert G. Gallager] zurück.<br> |

| − | Die Idee kam allerdings aufgrund der damaligen Prozessorentechnologie um einige Jahrzehnte zu früh. Schon drei Jahre nach Berrou's Erfindung der Turbocodes 1993 erkannten dann allerdings [https://de.wikipedia.org/wiki/David_MacKay David J. C. MacKay] und [https://en.wikipedia.org/wiki/Radford_M._Neal Radford M. Neal] das riesige Potential der LDPC–Codes, wenn man diese ebenso wie die Turbocodes iterativ symbolweise decodiert. Sie erfanden die LDPC–Codes quasi neu.<br> | + | Die Idee kam allerdings aufgrund der damaligen Prozessorentechnologie um einige Jahrzehnte zu früh. Schon drei Jahre nach Berrou's Erfindung der Turbocodes 1993 erkannten dann allerdings [https://de.wikipedia.org/wiki/David_MacKay David J. C. MacKay] und [https://en.wikipedia.org/wiki/Radford_M._Neal Radford M. Neal] das riesige Potential der LDPC–Codes, wenn man diese ebenso wie die Turbocodes iterativ symbolweise decodiert. Sie erfanden die LDPC–Codes quasi neu.<br> |

| − | Wie aus dem Namensbestandteil „Parity–check” bereits hervorgeht, handelt es sich bei diesen Codes um lineare Blockcodes entsprechend den Ausführungen im [[Kanalcodierung/Zielsetzung_der_Kanalcodierung#.23_.C3.9CBERBLICK_ZUM_ERSTEN_HAUPTKAPITEL_.23|ersten Hauptkapitel ]]. Deshalb gilt auch hier: | + | Wie aus dem Namensbestandteil „Parity–check” bereits hervorgeht, handelt es sich bei diesen Codes um lineare Blockcodes entsprechend den Ausführungen im [[Kanalcodierung/Zielsetzung_der_Kanalcodierung#.23_.C3.9CBERBLICK_ZUM_ERSTEN_HAUPTKAPITEL_.23|ersten Hauptkapitel ]]. Deshalb gilt auch hier: |

| − | *Das Codewort ergibt sich aus dem Informationswort $\underline{u}$ (dargestellt mit $k$ Binärsymbolen) und der [[Kanalcodierung/Allgemeine_Beschreibung_linearer_Blockcodes#Codefestlegung_durch_die_Generatormatrix| Generatormatrix]] $\mathbf{G}$ der Dimension $k × n$ zu $\underline{x} = \underline{u} \cdot \mathbf{G}$ ⇒ Codewortlänge $n$.<br> | + | *Das Codewort ergibt sich aus dem Informationswort $\underline{u}$ (dargestellt mit $k$ Binärsymbolen) und der [[Kanalcodierung/Allgemeine_Beschreibung_linearer_Blockcodes#Codefestlegung_durch_die_Generatormatrix| Generatormatrix]] $\mathbf{G}$ der Dimension $k × n$ zu $\underline{x} = \underline{u} \cdot \mathbf{G}$ ⇒ Codewortlänge $n$.<br> |

| − | *Die Prüfgleichungen ergeben sich aus der Identität $\underline{x} \cdot \mathbf{H}^{\rm T} ≡ 0$, wobei $\mathbf{H}$ die Prüfmatrix bezeichnet. Diese besteht aus $m$ Zeilen und $n$ Spalten. Während im ersten Kapitel grundsätzlich $m = n -k$ gegolten hat, fordern wir für die LPDC–Codes lediglich noch $m ≥ n -k$.<br><br> | + | *Die Prüfgleichungen ergeben sich aus der Identität $\underline{x} \cdot \mathbf{H}^{\rm T} ≡ 0$, wobei $\mathbf{H}$ die Prüfmatrix bezeichnet. Diese besteht aus $m$ Zeilen und $n$ Spalten. Während im ersten Kapitel grundsätzlich $m = n -k$ gegolten hat, fordern wir für die LPDC–Codes lediglich noch $m ≥ n -k$.<br><br> |

| − | Ein gravierender Unterschied zwischen einem LDPC–Code und einem herkömmlichen Blockcode nach der Beschreibung im ersten Kapitel ist, dass die Prüfmatrix $\mathbf{H}$ nur spärlich mit Einsen besetzt ist.<br> | + | Ein gravierender Unterschied zwischen einem LDPC–Code und einem herkömmlichen Blockcode nach der Beschreibung im ersten Kapitel ist, dass die Prüfmatrix $\mathbf{H}$ nur spärlich mit Einsen besetzt ist („''Low–density''”).<br> |

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

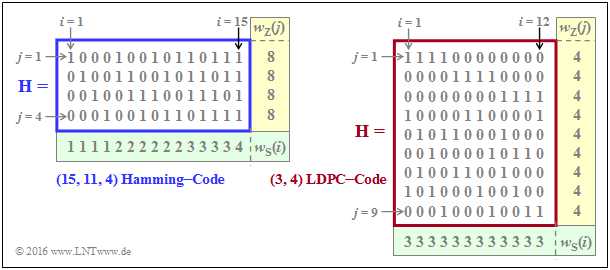

| − | $\text{Beispiel 1:}$ Die Grafik zeigt beispielhaft die Prüfmatrizen $\mathbf{H}$ für | + | $\text{Beispiel 1:}$ Die Grafik zeigt beispielhaft die Prüfmatrizen $\mathbf{H}$ für |

| − | *den Hamming–Code mit Codelänge $n = 15, \ m = 4$ ⇒ $k = 11$ Informationsbits,<br> | + | *den Hamming–Code mit Codelänge $n = 15, \ m = 4$ ⇒ $k = 11$ Informationsbits,<br> |

| − | *den LDPC–Code aus [Liv15]<ref name='Liv15'>Liva, G.: ''Channels Codes for Iterative Decoding.'' Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2015.</ref> der Länge $n = 12$ und mit $m = 9$ Prüfgleichungen ⇒ $k ≥ 3$.<br><br> | + | *den LDPC–Code aus [Liv15]<ref name='Liv15'>Liva, G.: ''Channels Codes for Iterative Decoding.'' Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2015.</ref> der Länge $n = 12$ und mit $m = 9$ Prüfgleichungen ⇒ $k ≥ 3$.<br><br> |

[[Datei:P ID3065 KC T 4 4 S1a v3 einfacher Rahmen.png|center|frame|Prüfmatrizen eines Hamming–Codes und eines LDPC–Codes|class=fit]] | [[Datei:P ID3065 KC T 4 4 S1a v3 einfacher Rahmen.png|center|frame|Prüfmatrizen eines Hamming–Codes und eines LDPC–Codes|class=fit]] | ||

| − | *In der linken Grafik beträgt der Anteil der Einsen $32/60 \approx 53.3\%$, wohingegen in der rechten Grafik der Einsen–Anteil mit $36/108 = 33.3\%$ geringer ist. | + | *In der linken Grafik beträgt der Anteil der Einsen $32/60 \approx 53.3\%$, wohingegen in der rechten Grafik der Einsen–Anteil mit $36/108 = 33.3\%$ geringer ist. |

*Bei den für die Praxis relevanten LDPC–Codes (großer Länge) ist der Einsen–Anteil noch deutlich niedriger.<br>}}<br> | *Bei den für die Praxis relevanten LDPC–Codes (großer Länge) ist der Einsen–Anteil noch deutlich niedriger.<br>}}<br> | ||

| + | Wir analysieren nun die beiden Prüfmatrizen anhand der Rate und des Hamming–Gewichts:<br> | ||

| + | *Die Rate des betrachteten Hamming–Codes (linke Grafik) ist $R = k/n = 11/15 \approx 0.733$. Das Hamming–Gewicht einer jeden der vier Zeilen ist $w_{\rm Z}= 8$, während die Hamming–Gewichte $w_{\rm S}(i)$ der Spalten zwischen 1 und 4 variieren. Für die Spalten–Laufvariable gilt hier: $1 ≤ i ≤ 15$. | ||

| − | + | *Beim betrachteten LDPC–Code gibt es in allen Zeilen vier Einsen ⇒ $w_{\rm Z} = 4$ und in allen Spalten drei Einsen ⇒ $w_{\rm S} = 3$. Die Codebezeichnung $(w_{\rm Z}, \ w_{\rm S})$ LDPC–Code verwendet genau diese Parameter. Beachten Sie die unterschiedliche Nomenklatur zum „$(n, \ k, \ m)$ Hamming–Code”. | |

| − | |||

| − | * | + | *Man spricht hier von einem <b>regulären LDPC–Code</b>, da alle Zeilengewichte $w_{\rm Z}(j)$ für $1 ≤ j ≤ m$ konstant gleich $w_{\rm Z}$ sind und auch alle Spaltengewichte $($mit den Indizes $1 ≤ i ≤ n)$ gleich sind: $w_{\rm S}(i) = w_{\rm S} = {\rm const.}$ Ist diese Bedingung nicht erfüllt, so liegt ein <i>irregulärer LDPC–Code</i> vor. |

| − | |||

| − | + | {{BlaueBox|TEXT= | |

| + | $\text{Merkmal der LDPC-Codes}$ | ||

| + | Für die Coderate kann man allgemein (wenn $k$ nicht bekannt ist) nur eine Schranke angeben: | ||

| + | :$$R ≥ 1 - w_{\rm S}/w_{\rm Z}.$$ | ||

| + | *Das Gleichheitszeichen gilt dann, wenn alle Zeilen von $\mathbf{H}$ linear unabhängig sind ⇒ $m = n \, – k$. Dann ergibt sich die herkömmliche Gleichung: | ||

:$$R = 1 - w_{\rm S}/w_{\rm Z} = 1 - m/n = k/n.$$ | :$$R = 1 - w_{\rm S}/w_{\rm Z} = 1 - m/n = k/n.$$ | ||

| − | *Dagegen gilt für die Coderate eines irregulären LDPC–Codes und auch für den links skizzierten $(15, 11, 4)$ Hammingcode: | + | *Dagegen gilt für die Coderate eines irregulären LDPC–Codes und auch für den links skizzierten $(15, 11, 4)$ Hammingcode: |

| − | : | + | :$$R \ge 1 - \frac{ {\rm E}[w_{\rm S}]}{ {\rm E}[w_{\rm Z}]} |

\hspace{0.5cm}{\rm mit}\hspace{0.5cm} | \hspace{0.5cm}{\rm mit}\hspace{0.5cm} | ||

{\rm E}[w_{\rm S}] =\frac{1}{n} \cdot \sum_{i = 1}^{n}w_{\rm S}(i) | {\rm E}[w_{\rm S}] =\frac{1}{n} \cdot \sum_{i = 1}^{n}w_{\rm S}(i) | ||

\hspace{0.5cm}{\rm und}\hspace{0.5cm} | \hspace{0.5cm}{\rm und}\hspace{0.5cm} | ||

{\rm E}[w_{\rm Z}] =\frac{1}{m} \cdot \sum_{j = 1}^{ m}w_{\rm Z}(j) | {\rm E}[w_{\rm Z}] =\frac{1}{m} \cdot \sum_{j = 1}^{ m}w_{\rm Z}(j) | ||

| − | \hspace{0.05cm}. | + | \hspace{0.05cm}.$$ |

| − | :Da beim Hamming–Code die $m = n | + | :Da beim Hamming–Code die $m = n - k$ Prüfgleichungen linear voneinander unabhängig sind, kann das „$≥$”–Zeichen durch das Gleichheitszeichen ersetzt werden, was gleichzeitig $R = k/n$ bedeutet.}}<br> |

| − | Weitere Informationen zu diesem Thema finden Sie in | + | Weitere Informationen zu diesem Thema finden Sie in [[Aufgaben:4.11_Analyse_von_Pr%C3%BCfmatrizen| Aufgabe 4.11]] und [[Aufgaben:4.11Z_Coderate_aus_der_Pr%C3%BCfmatrix| Aufgabe 4.11Z]]. |

== Zweiteilige LDPC–Graphenrepräsentation – Tanner–Graph == | == Zweiteilige LDPC–Graphenrepräsentation – Tanner–Graph == | ||

<br> | <br> | ||

| − | Alle wesentlichen Merkmale eines LDPC–Codes sind in der Prüfmatrix $\mathbf{H} = (h_{j,\hspace{0.05cm}i})$ enthalten und lassen sich durch einen so genannten | + | Alle wesentlichen Merkmale eines LDPC–Codes sind in der Prüfmatrix $\mathbf{H} = (h_{j,\hspace{0.05cm}i})$ enthalten und lassen sich durch einen so genannten '''Tanner–Graphen''' darstellen. Es handelt sich um eine <i>Bipartite Graph Representation</i>, wobei die deutsche Übersetzung von „bipartite” in etwa „zweiteilig” lautet. Bevor wir beispielhafte Tanner–Graphen genauer betrachten und analysieren, müssen zuerst noch einige geeignete Beschreibungsgrößen definiert werden: |

| − | *Die $n$ Spalten der Prüfmatrix $\mathbf{H}$ stehen jeweils für ein Codewortbit. Da jedes Codewortbit sowohl ein Informationsbit als auch ein Prüfbit sein kann, hat sich hierfür die neutrale Bezeichnung <b>Varibale Node</b> (VN) durchgesetzt. Das $i$–te Codewortbit wird $V_i$ genannt und die Menge aller <i>Variable Nodes</i> (VNs) ist $\{V_1, \ \text{...}\hspace{0.05cm} , \ V_i, \ \text{...}\hspace{0.05cm} , \ V_n\}$.<br> | + | *Die $n$ Spalten der Prüfmatrix $\mathbf{H}$ stehen jeweils für ein Codewortbit. Da jedes Codewortbit sowohl ein Informationsbit als auch ein Prüfbit sein kann, hat sich hierfür die neutrale Bezeichnung <b>Varibale Node</b> (VN) durchgesetzt. Das $i$–te Codewortbit wird $V_i$ genannt und die Menge aller <i>Variable Nodes</i> (VNs) ist $\{V_1, \ \text{...}\hspace{0.05cm} , \ V_i, \ \text{...}\hspace{0.05cm} , \ V_n\}$.<br> |

| − | *Die $m$ Zeilen von $\mathbf{H}$ beschreiben jeweils eine Prüfgleichung (englisch: <i>Parity–check Equation</i>). Wir bezeichnen im folgenden eine solche Prüfgleichung als <b>Check Node</b> (CN). Die Menge aller <i>Check Nodes</i> (CNs) ist $\{C_1, \ \text{...}\hspace{0.05cm} , \ C_j, \ \text{...}\hspace{0.05cm} , \ C_m\}$, wobei $C_j$ die Prüfgleichung der $j$–ten Zeile angibt.<br> | + | *Die $m$ Zeilen von $\mathbf{H}$ beschreiben jeweils eine Prüfgleichung (englisch: <i>Parity–check Equation</i>). Wir bezeichnen im folgenden eine solche Prüfgleichung als <b>Check Node</b> (CN). Die Menge aller <i>Check Nodes</i> (CNs) ist $\{C_1, \ \text{...}\hspace{0.05cm} , \ C_j, \ \text{...}\hspace{0.05cm} , \ C_m\}$, wobei $C_j$ die Prüfgleichung der $j$–ten Zeile angibt.<br> |

| − | *Im Tanner–Graphen werden die $n$ <i>Variable Nodes</i> $V_i$ als Kreise und die $m$ <i>Check Nodes</i> $C_j$ als Quadrate dargestellt. Ist das Matrixelement in Zeile $j$ und Spalte $i ⇒ h_{j,\hspace{0.05cm}i} = 1$, so gibt es eine Verbindungslinie (englisch: <i>Edge</i>) zwischen dem <i>Variable Node</i> $V_i$ und dem <i>Check Node</i> $C_j$.<br><br> | + | *Im Tanner–Graphen werden die $n$ <i>Variable Nodes</i> $V_i$ als Kreise und die $m$ <i>Check Nodes</i> $C_j$ als Quadrate dargestellt. Ist das Matrixelement in Zeile $j$ und Spalte $i \hspace{0.15cm} ⇒ \hspace{0.15cm} h_{j,\hspace{0.05cm}i} = 1$, so gibt es eine Verbindungslinie (englisch: <i>Edge</i>) zwischen dem <i>Variable Node</i> $V_i$ und dem <i>Check Node</i> $C_j$.<br><br> |

[[Datei:P ID3069 KC T 4 4 S2a v3.png|right|frame|Einfaches Beispiel für einen Tanner–Graphen|class=fit]] | [[Datei:P ID3069 KC T 4 4 S2a v3.png|right|frame|Einfaches Beispiel für einen Tanner–Graphen|class=fit]] | ||

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

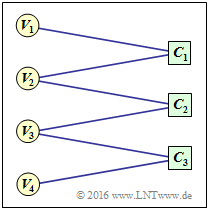

$\text{Beispiel 2:}$ Zur Verdeutlichung obiger Begriffe ist rechts ein beispielhafter Tannergraphen mit | $\text{Beispiel 2:}$ Zur Verdeutlichung obiger Begriffe ist rechts ein beispielhafter Tannergraphen mit | ||

| − | *den <i>Variable Nodes</i> (kurz: VNs) $V_1$ bis $V_4$, und<br> | + | *den <i>Variable Nodes</i> (kurz: VNs) $V_1$ bis $V_4$, und<br> |

| − | *den <i>Check Nodes</i> (kurz: CNs) $C_1$ bis $C_3$ | + | *den <i>Check Nodes</i> (kurz: CNs) $C_1$ bis $C_3$<br><br> |

angegeben. Der zugehörige Code hat allerdings keinerlei praktische Bedeutung. | angegeben. Der zugehörige Code hat allerdings keinerlei praktische Bedeutung. | ||

Man erkennt aus der Grafik: | Man erkennt aus der Grafik: | ||

| − | *Die Codelänge ist $n = 4$ und es gibt $m = 3$ Prüfgleichungen. Damit hat die Prüfmatrix $\mathbf{H}$ die Dimension $3×4$.<br> | + | *Die Codelänge ist $n = 4$ und es gibt $m = 3$ Prüfgleichungen. Damit hat die Prüfmatrix $\mathbf{H}$ die Dimension $3×4$.<br> |

| − | *Es gibt insgesamt sechs Verbindungslinien (englisch: <i>Edges</i>). Damit sind sechs der zwölf Elemente $h_{j,\hspace{0.05cm}i}$ von $\mathbf{H}$ Einsen.<br> | + | *Es gibt insgesamt sechs Verbindungslinien (englisch: <i>Edges</i>). Damit sind sechs der zwölf Elemente $h_{j,\hspace{0.05cm}i}$ von $\mathbf{H}$ Einsen.<br> |

| − | *Bei jedem <i>Check Node</i> kommen zwei Linien an | + | *Bei jedem <i>Check Node</i> kommen zwei Linien an ⇒ Die Hamming–Gewichte aller Zeilen gleich sind: $w_{\rm Z}(j) = 2 = w_{\rm Z}$.<br> |

| − | *Von den Knoten $V_1$ und $V_4$ gibt es jeweils nur einen Übergang zu einem <i>Check Node</i>, von $V_2$ und $V_3$ dagegen zwei. Aus diesem Grund handelt es sich um einen <i>irregulären Code</i>.<br><br> | + | *Von den Knoten $V_1$ und $V_4$ gibt es jeweils nur einen Übergang zu einem <i>Check Node</i>, von $V_2$ und $V_3$ dagegen zwei. <br>Aus diesem Grund handelt es sich um einen <i>irregulären Code</i>.<br><br> |

Die Prüfmatrix lautet demnach: | Die Prüfmatrix lautet demnach: | ||

| − | :<math>{ \boldsymbol{\rm H} } = | + | ::<math>{ \boldsymbol{\rm H} } = |

\begin{pmatrix} | \begin{pmatrix} | ||

1 &1 &0 &0\\ | 1 &1 &0 &0\\ | ||

| Zeile 89: | Zeile 93: | ||

\end{pmatrix}\hspace{0.05cm}.</math>}}<br> | \end{pmatrix}\hspace{0.05cm}.</math>}}<br> | ||

| + | {{GraueBox|TEXT= | ||

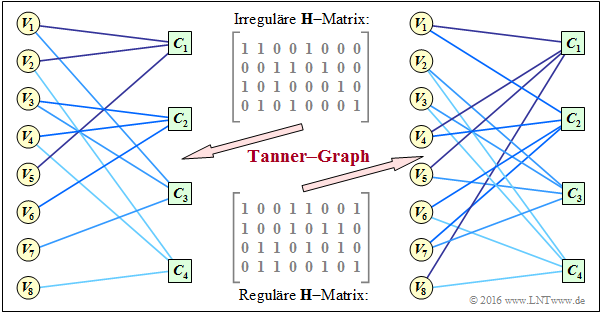

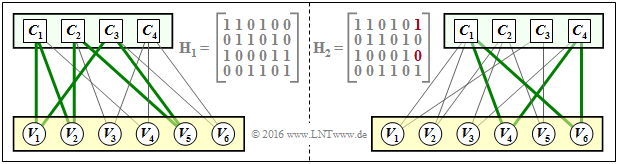

| + | $\text{Beispiel 3:}$ Es folgt nun ein praxisrelevanteres Beispiel. In der [[Aufgaben:4.11_Analyse_von_Pr%C3%BCfmatrizen|Aufgabe 4.11]] wurden zwei Prüfmatrizen analysiert: | ||

| + | *Der Coder entsprechend der Matrix $\mathbf{H}_1$ ist systematisch. Die Codeparameter sind $n = 8, \ k = 4$ und $m = 4$ ⇒ Rate $1/2$. Der Code ist irregulär, da die Hamming–Gewichte nicht für alle Spalten gleich sind. In der Grafik ist diese „irreguläre $\mathbf{H}$–Matrix” oben angegeben.<br> | ||

| − | + | *Unten angegeben ist die „reguläre $\mathbf{H}$–Matrix” entsprechend der Matrix $\mathbf{H}_3$ in Aufgabe 4.11. Die Zeilen sind Linearkombinationen der oberen Matrix. Für diesen nicht systematischen Coder gilt mit $w_{\rm S} = 2$ und $w_{\rm Z} = 4$ für die Rate: $R \ge 1 - w_{\rm S}/w_{\rm Z} = 1/2$. | |

| − | $\ | ||

| − | |||

| − | |||

[[Datei:P ID3071 KC T 4 4 S2b v4.png|center|frame|Tanner–Graph eines regulären und eines irregelären Codes|class=fit]] | [[Datei:P ID3071 KC T 4 4 S2b v4.png|center|frame|Tanner–Graph eines regulären und eines irregelären Codes|class=fit]] | ||

Die Grafik zeigt die zugehörigen Tanner–Graphen: | Die Grafik zeigt die zugehörigen Tanner–Graphen: | ||

| − | *Der linke Graph bezieht sich auf die obere (irreguläre) Matrix. Die acht <i>Variable Nodes</i> (abgekürzt VNs) $V_i$ sind mit den vier <i>Check Nodes</i> (abgekürzt CNs) $C_j$ verbunden, falls das Element in Zeile $j$ und Spalte | + | *Der linke Graph bezieht sich auf die obere (irreguläre) Matrix. Die acht <i>Variable Nodes</i> (abgekürzt VNs) $V_i$ sind mit den vier <i>Check Nodes</i> (abgekürzt CNs) $C_j$ verbunden, falls das Element in Zeile $j$ und Spalte $i \hspace{0.15cm} ⇒ \hspace{0.15cm} h_{j,\hspace{0.05cm}i}$ gleich $1$ ist. Andernfalls $($falls $h_{j,\hspace{0.05cm}i} = 0)$ besteht keine Verbindung.<br> |

| − | *Dieser Graph ist für die [[Kanalcodierung/Grundlegendes_zu_den_Low%E2%80%93density_Parity%E2%80%93check_Codes#Iterative_Decodierung_von_LDPC.E2.80.93Codes| iterative symbolweise Decodierung]] nicht sonderlich gut geeignet. Die VNs $V_5, \ \text{...}\hspace{0.05cm} , \ V_8$ sind jeweils nur mit einem CN verbunden, was für die Decodierung | + | *Dieser Graph ist für die [[Kanalcodierung/Grundlegendes_zu_den_Low%E2%80%93density_Parity%E2%80%93check_Codes#Iterative_Decodierung_von_LDPC.E2.80.93Codes| iterative symbolweise Decodierung]] nicht sonderlich gut geeignet. Die VNs $V_5, \ \text{...}\hspace{0.05cm} , \ V_8$ sind jeweils nur mit einem CN verbunden, was für die Decodierung keine Information liefert.<br> |

| − | *Im rechten Tanner–Graph für den regulären Code erkennt man, dass hier von jedem | + | *Im rechten Tanner–Graph für den regulären Code erkennt man, dass hier von jedem <i>Variable Node</i> $V_i$ zwei Verbindungslinien (englisch: <i>Edges</i>) abgehen und von jedem <i>Check Node</i> $C_j$ deren vier. Damit ist bei der Decodierung in jeder Iterationsschleife ein Informationsgewinn möglich.<br> |

| − | *Man erkennt zudem, dass hier beim Übergang vom irregulären zum äquivalenten regulären Code der Einsen–Anteil zunimmt, im Beispiel von $37.5\%$ auf $50\%$. Diese Aussage kann allerdings nicht verallgemeinert werden.}}<br> | + | *Man erkennt zudem, dass hier beim Übergang vom irregulären zum äquivalenten regulären Code der Einsen–Anteil zunimmt, im Beispiel von $37.5\%$ auf $50\%$. Diese Aussage kann allerdings nicht verallgemeinert werden.}}<br> |

== Iterative Decodierung von LDPC–Codes == | == Iterative Decodierung von LDPC–Codes == | ||

<br> | <br> | ||

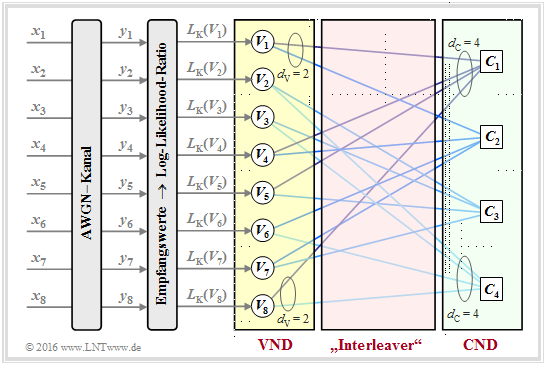

| − | Als Beispiel für die iterative LDPC–Decodierung wird nun der so genannte <i>Message–passing Algorithm</i> beschrieben. Wir verdeutlichen diesen anhand des rechten Tanner–Graphen im [[Kanalcodierung/Grundlegendes_zu_den_Low%E2%80%93density_Parity%E2%80%93check_Codes#Zweiteilige_LDPC.E2.80.93Graphenrepr.C3.A4sentation_.E2.80.93_Tanner|Beispiel 3]] auf der vorherigen Seite und damit für die dort angegebene reguläre Prüfmatrix.<br> | + | Als Beispiel für die iterative LDPC–Decodierung wird nun der so genannte <i>Message–passing Algorithm</i> beschrieben. Wir verdeutlichen diesen anhand des rechten Tanner–Graphen im [[Kanalcodierung/Grundlegendes_zu_den_Low%E2%80%93density_Parity%E2%80%93check_Codes#Zweiteilige_LDPC.E2.80.93Graphenrepr.C3.A4sentation_.E2.80.93_Tanner|$\text{Beispiel 3}$]] auf der vorherigen Seite und damit für die dort angegebene reguläre Prüfmatrix.<br> |

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Prinzip:}$ Beim <b>Message–passing Algorithm</b> erfolgt abwechselnd (oder iterativ) ein Informationsaustausch zwischen den <i>Variable Nodes </i> (VNs) $V_1, \ \text{...}\hspace{0.05cm} , \ V_n$ und den <i>Check Nodes </i> (CNs) $C_1 , \ \text{...}\hspace{0.05cm} , \ C_m$.}}<br> | + | $\text{Prinzip:}$ Beim <b>Message–passing Algorithm</b> erfolgt abwechselnd (oder iterativ) ein Informationsaustausch zwischen den <i>Variable Nodes </i> (VNs) $V_1, \ \text{...}\hspace{0.05cm} , \ V_n$ und den <i>Check Nodes </i> (CNs) $C_1 , \ \text{...}\hspace{0.05cm} , \ C_m$.}}<br> |

[[Datei:P ID3075 KC T 4 4 S3a v1.png|center|frame|Iterative Decodierung von LDPC–Codes|class=fit]] | [[Datei:P ID3075 KC T 4 4 S3a v1.png|center|frame|Iterative Decodierung von LDPC–Codes|class=fit]] | ||

Für das betrachtete Beispiel gilt: | Für das betrachtete Beispiel gilt: | ||

| − | *Es gibt $n = 8$ <i>Variable Nodes </i> und $m = 4$ <i>Check Nodes </i>. Da ein regulärer LDPC–Code vorliegt, gehen von jedem <i>Variable Node </i> $d_{\rm V} = 2$ Verbindungslinien zu einem <i>Check Node </i> und jeder <i>Check Node </i> ist mit $d_{\rm C} = 4$ <i>Variable Nodes </i> verbunden. | + | *Es gibt $n = 8$ <i>Variable Nodes </i> und $m = 4$ <i>Check Nodes </i>. Da ein regulärer LDPC–Code vorliegt, gehen von jedem <i>Variable Node </i> $d_{\rm V} = 2$ Verbindungslinien zu einem <i>Check Node </i> und jeder <i>Check Node </i> ist mit $d_{\rm C} = 4$ <i>Variable Nodes </i> verbunden. |

| − | *Der <i>Variable Node Degree</i> $d_{\rm V}$ ist gleich dem Hamming–Gewicht einer jeden Spalte $(w_{\rm S})$ und für den <i>Check Node Degree</i> gilt: $d_{\rm C} = w_{\rm Z}$ (Hamming–Gewicht einer jeden Zeile). | + | *Der <i>Variable Node Degree</i> $d_{\rm V}$ ist gleich dem Hamming–Gewicht einer jeden Spalte $(w_{\rm S})$ und für den <i>Check Node Degree</i> gilt: $d_{\rm C} = w_{\rm Z}$ (Hamming–Gewicht einer jeden Zeile). |

| − | *In der folgenden Beschreibung verwenden wir auch die Begriffe <i>Nachbarn eines Variable Nodes</i> ⇒ $N(V_i)$ sowie <i>Nachbarn eines Check Nodes</i> ⇒ $N(C_j)$, wobei wir uns hier auf implizite Definitionen beschränken: | + | *In der folgenden Beschreibung verwenden wir auch die Begriffe <i>Nachbarn eines Variable Nodes</i> ⇒ $N(V_i)$ sowie <i>Nachbarn eines Check Nodes</i> ⇒ $N(C_j)$, wobei wir uns hier auf implizite Definitionen beschränken: |

| − | ::<math>N(V_1) | + | ::<math>N(V_1) = \{ C_1, C_2\}\hspace{0.05cm}, \hspace{0.3cm}N(V_2) = \{ C_3, C_4\}\hspace{0.05cm}, \hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.15cm},\hspace{0.3cm}N(V_8) = \{ C_1, C_4\}\hspace{0.05cm},</math> |

| − | ::<math>N(C_1) | + | ::<math>N(C_1) = \{ V_1, V_4, V_5, V_8\}\hspace{0.05cm}, \hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.15cm}\hspace{0.05cm}, \hspace{0.3cm}N(C_4) = \{ V_2, V_3, V_6, V_8\}\hspace{0.05cm}.</math> |

| − | [[Datei:P ID3085 KC T 4 4 S3c v2.png|right|frame|Informationsaustausch zwischen | + | [[Datei:P ID3085 KC T 4 4 S3c v2.png|right|frame|Informationsaustausch zwischen <i>Variable Nodes</i> und <i>Check Nodes </i>]] |

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

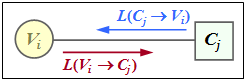

| − | $\text{Beispiel 4:}$ Die Skizze aus [Liv15]<ref name='Liv15'>Liva, G.: ''Channels Codes for Iterative Decoding.'' Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2015.</ref> zeigt den Austausch von Information zwischen dem <i>Variable Node</i> $V_i$ und dem <i>Check Node</i> $C_j$ – ausgedrückt durch [[Kanalcodierung/Soft%E2%80%93in_Soft%E2%80%93out_Decoder#Zuverl.C3.A4ssigkeitsinformation_.E2.80.93_Log_Likelihood_Ratio| Log–Likelihood Ratios]] (kurz: $L$–Werte). Der Informationsaustausch geschieht in zwei Richtungen: | + | $\text{Beispiel 4:}$ Die Skizze aus [Liv15]<ref name='Liv15'>Liva, G.: ''Channels Codes for Iterative Decoding.'' Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2015.</ref> zeigt den Austausch von Information zwischen dem <i>Variable Node</i> $V_i$ und dem <i>Check Node</i> $C_j$ – ausgedrückt durch [[Kanalcodierung/Soft%E2%80%93in_Soft%E2%80%93out_Decoder#Zuverl.C3.A4ssigkeitsinformation_.E2.80.93_Log_Likelihood_Ratio| Log–Likelihood Ratios]] (kurz: $L$–Werte). |

| − | *<b>$L(V_i → C_j)$</b>: Extrinsische Information aus $V_i$–Sicht, Apriori–Information aus $C_j$–Sicht.<br> | + | |

| + | Der Informationsaustausch geschieht in zwei Richtungen: | ||

| + | *<b>$L(V_i → C_j)$</b>: Extrinsische Information aus $V_i$–Sicht, Apriori–Information aus $C_j$–Sicht.<br> | ||

| + | |||

| + | *<b>$L(C_j → V_i)$</b>: Extrinsische Information aus $C_j$–Sicht, Apriori–Information aus $V_i$–Sicht.}} | ||

| − | |||

Die Beschreibung des Decodieralgorithmus wird fortgesetzt:<br> | Die Beschreibung des Decodieralgorithmus wird fortgesetzt:<br> | ||

| − | <b>Initialisierung:</b> Zu Beginn der Decodierung erhalten die <i>Variable Nodes</i> (VNs) keine Apriori–Information von den <i>Check Nodes</i> (CNs), und es gilt für $1 ≤ i ≤ n \text{:} | + | <b>Initialisierung:</b> Zu Beginn der Decodierung erhalten die <i>Variable Nodes</i> (VNs) keine Apriori–Information von den <i>Check Nodes</i> (CNs), und es gilt für $1 ≤ i ≤ n \text{:}$ |

| + | :$$L(V_i → C_j) = L_{\rm K}(V_i).$$ | ||

| + | |||

| + | Wie aus der Grafik am Seitenbeginn ersichtlich, ergeben sich diese Kanal–$L$–Werte $L_{\rm K}(V_i)$ aus den Empfangswerten $y_i$.<br><br> | ||

| + | |||

| + | <b>Check Node Decoder</b>: Jeder Knoten $C_j$ repräsentiert eine Prüfgleichung. So steht $C_1$ für die Gleichung $V_1 + V_4 + V_5 + V_8 = 0$. Man erkennt den Zusammenhang zur extrinsischen Information bei der symbolweisen Decodierung des <i>Single Parity–check Codes</i>. | ||

| − | + | In Analogie zur Seite [[Kanalcodierung/Soft–in_Soft–out_Decoder#Zur_Berechnung_der_extrinsischen_L.E2.80.93Werte| Zur Berechnung der extrinsischen L–Werte]] und zur [[Aufgaben:Aufgabe_4.4:_Extrinsische_L–Werte_beim_SPC|Aufgabe 4.4]] gilt somit für den extrinsischen $L$–Wert von $C_j$ und gleichzeitig für die Apriori–Information bezüglich $V_i$: | |

::<math>L(C_j \rightarrow V_i) = 2 \cdot {\rm tanh}^{-1}\left [ \prod\limits_{V \in N(C_j)\hspace{0.05cm},\hspace{0.1cm} V \ne V_i} \hspace{-0.35cm}{\rm tanh}\left [L(V \rightarrow C_j \right ] /2) \right ] | ::<math>L(C_j \rightarrow V_i) = 2 \cdot {\rm tanh}^{-1}\left [ \prod\limits_{V \in N(C_j)\hspace{0.05cm},\hspace{0.1cm} V \ne V_i} \hspace{-0.35cm}{\rm tanh}\left [L(V \rightarrow C_j \right ] /2) \right ] | ||

\hspace{0.05cm}.</math> | \hspace{0.05cm}.</math> | ||

| − | |||

| − | In Analogie zu zur Seite [[Kanalcodierung/Soft–in_Soft–out_Decoder#Zur_Berechnung_der_extrinsischen_L.E2.80.93Werte| Zur Berechnung der extrinsischen L–Werte]] gilt für den extrinsischen $L$–Wert von $V_i$ und gleichzeitig für die Apriori–Information bezüglich $C_j$: | + | <b>Variable Node Decoder</b>: Im Gegensatz zum <i>Check Node Decoder</i> (CND) besteht beim <i>Variable Node Decoder</i> (VND) eine Verwandtschaft zur Decodierung eines <i>Repetition Codes</i>, weil alle mit $V_i$ verbundenen <i>Check Nodes</i> $C_j$ demselben Bit entsprechen ⇒ dieses Bit wird quasi $d_{\rm V}$ mal wiederholt.<br> |

| + | |||

| + | In Analogie zu zur Seite [[Kanalcodierung/Soft–in_Soft–out_Decoder#Zur_Berechnung_der_extrinsischen_L.E2.80.93Werte| Zur Berechnung der extrinsischen L–Werte]] gilt für den extrinsischen $L$–Wert von $V_i$ und gleichzeitig für die Apriori–Information bezüglich $C_j$: | ||

::<math>L(V_i \rightarrow C_j) = L_{\rm K}(V_i) + \hspace{-0.55cm} \sum\limits_{C \hspace{0.05cm}\in\hspace{0.05cm} N(V_i)\hspace{0.05cm},\hspace{0.1cm} C \hspace{0.05cm}\ne\hspace{0.05cm} C_j} \hspace{-0.55cm}L(C \rightarrow V_i) | ::<math>L(V_i \rightarrow C_j) = L_{\rm K}(V_i) + \hspace{-0.55cm} \sum\limits_{C \hspace{0.05cm}\in\hspace{0.05cm} N(V_i)\hspace{0.05cm},\hspace{0.1cm} C \hspace{0.05cm}\ne\hspace{0.05cm} C_j} \hspace{-0.55cm}L(C \rightarrow V_i) | ||

\hspace{0.05cm}.</math> | \hspace{0.05cm}.</math> | ||

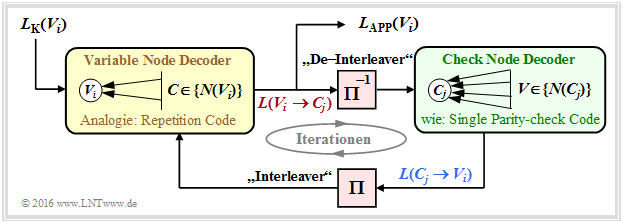

| − | Das folgende Schaubild des beschriebenen Decodieralgorithmus' für LDPC–Codes zeigt Ähnlichkeiten mit der Vorgehensweise bei [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Seriell_verkettete_Turbocodes_.E2.80.93_SCCC| seriell verketteten Turbocodes]]. | + | Das folgende Schaubild des beschriebenen Decodieralgorithmus' für LDPC–Codes zeigt Ähnlichkeiten mit der Vorgehensweise bei [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Seriell_verkettete_Turbocodes_.E2.80.93_SCCC| seriell verketteten Turbocodes]]. |

| − | * Um eine vollständige Analogie zwischen der LDPC– und der Turbodecodierung herzustellen, ist auch hier zwischen dem <i>Variable Node Decoder</i> (VND) und dem <i>Check Node Decoder</i> (CND) ein <i>Interleaver</i> sowie ein <i>De–Interleaver</i> eingezeichnet. | + | |

| + | [[Datei:P ID3078 KC T 4 4 S3b v3.png|center|frame|Zusammenhang zwischen LDPC–Decodierung und serieller Turbo–Decodierung|class=fit]] | ||

| + | |||

| + | * Um eine vollständige Analogie zwischen der LDPC– und der Turbodecodierung herzustellen, ist auch hier zwischen dem <i>Variable Node Decoder</i> (VND) und dem <i>Check Node Decoder</i> (CND) ein „<i>Interleaver</i> ” sowie ein „<i>De–Interleaver</i> ” eingezeichnet. | ||

*Da es sich hierbei nicht um reale Systemkomponenten handelt, sondern nur um Analogien, haben wir diese Begriffe in Hochkommata gesetzt.<br> | *Da es sich hierbei nicht um reale Systemkomponenten handelt, sondern nur um Analogien, haben wir diese Begriffe in Hochkommata gesetzt.<br> | ||

| − | |||

== Leistungsfähigkeit regulärer LDPC–Codes == | == Leistungsfähigkeit regulärer LDPC–Codes == | ||

<br> | <br> | ||

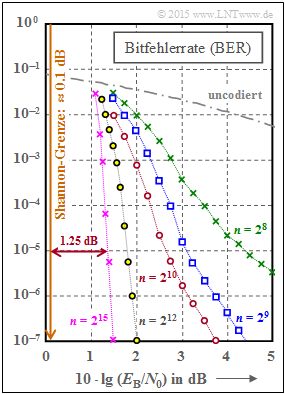

[[Datei:P ID3079 KC T 4 4 S4a v5.png|right|frame|Bitfehlerrate von LDPC–Codes]] | [[Datei:P ID3079 KC T 4 4 S4a v5.png|right|frame|Bitfehlerrate von LDPC–Codes]] | ||

| − | Wir betrachten nun wie in [Str14]<ref name='Str14'>Strutz, T.: ''Low–density Parity–check Codes – Eine Einführung''. Vorlesungsmaterial. Hochschule für Telekommunikation, Leipzig, 2014. PDF-Dokument [http://www1.hft-leipzig.de/strutz/Kanalcodierung/ldpc_tutorial.pdf PDF-Dokument].</ref> fünf reguläre LDPC–Codes. Die Grafik zeigt die Bitfehlerrate (BER) abhängig vom AWGN–Parameter $10 \cdot {\rm lg} \, E_{\rm B}/N_0$. Zum Vergleich ist die Kurve für uncodierte Übertragung eingezeichnet.<br> | + | Wir betrachten nun wie in [Str14]<ref name='Str14'>Strutz, T.: ''Low–density Parity–check Codes – Eine Einführung''. Vorlesungsmaterial. Hochschule für Telekommunikation, Leipzig, 2014. PDF-Dokument [http://www1.hft-leipzig.de/strutz/Kanalcodierung/ldpc_tutorial.pdf PDF-Dokument].</ref> fünf reguläre LDPC–Codes. Die Grafik zeigt die Bitfehlerrate $\rm (BER)$ abhängig vom AWGN–Parameter $10 \cdot {\rm lg} \, E_{\rm B}/N_0$. Zum Vergleich ist auch die Kurve für uncodierte Übertragung eingezeichnet.<br> |

Diese LDPC–Codes zeigen folgende Eigenschaften: | Diese LDPC–Codes zeigen folgende Eigenschaften: | ||

| − | *Die Prüfmatrizen $\mathbf{H}$ weisen jeweils $n$ Spalten und $m = n/2$ linear voneinander unabhängige Zeilen auf. In jeder Zeile gibt es $w_{\rm Z} = 6$ Einsen und in jeder Spalte $w_{\rm S} = 3$ Einsen.<br> | + | *Die Prüfmatrizen $\mathbf{H}$ weisen jeweils $n$ Spalten und $m = n/2$ linear voneinander unabhängige Zeilen auf. In jeder Zeile gibt es $w_{\rm Z} = 6$ Einsen und in jeder Spalte $w_{\rm S} = 3$ Einsen.<br> |

| − | *Der Einsen–Anteil beträgt $w_{\rm Z}/n = w_{\rm S}/m$, so dass bei großer Codewortlänge $n$ die Klassifizierung „<i>Low–density</i>” gerechtfertigt ist. Für die rote Kurve $(n = 2^{10})$ | + | *Der Einsen–Anteil beträgt $w_{\rm Z}/n = w_{\rm S}/m$, so dass bei großer Codewortlänge $n$ die Klassifizierung „<i>Low–density</i>” gerechtfertigt ist. Für die rote Kurve $(n = 2^{10})$ beträgt der Einsen–Anteil $0.6\%$.<br> |

| − | *Die Rate aller Codes beträgt $R = 1 | + | *Die Rate aller Codes beträgt $R = 1 - w_{\rm S}/w_{\rm Z} = 1/2$. Wegen der linearen Unabhängigkeit der Matrixzeilen gilt aber auch $R = k/n$ mit der Informationswortlänge $k = n - m = n/2$.<br><br> |

Aus der Grafik erkennt man: | Aus der Grafik erkennt man: | ||

| − | *Die Bitfehlerrate ist um so kleiner, je länger der Code ist | + | *Die Bitfehlerrate ist um so kleiner, je länger der Code ist: |

| + | :*Für $10 \cdot {\rm lg} \, E_{\rm B}/N_0 = 2 \ \rm dB$ und $n = 2^8 = 256$ ergibt sich ${\rm BER} \approx 10^{-2}$. | ||

| + | :*Für $n = 2^{12} = 4096$ dagegen nur ${\rm BER} \approx 2 \cdot 10^{-7}$.<br> | ||

| − | *Mit $n = 2^{15} = 32768$ (violette Kurve) benötigt man $10 \cdot {\rm lg} \, E_{\rm B}/N_0 \approx 1.35 \ \rm dB$ für ${\rm BER} = 10^{-5}$. Der Abstand von der Shannon–Grenze ( | + | *Mit $n = 2^{15} = 32768$ (violette Kurve) benötigt man $10 \cdot {\rm lg} \, E_{\rm B}/N_0 \approx 1.35 \ \rm dB$ für ${\rm BER} = 10^{-5}$. |

| + | *Der Abstand von der Shannon–Grenze $(0.18 \ \rm dB$ für $R = 1/2$ und BPSK$)$ beträgt ca. $1.2 \ \rm dB$. | ||

<br clear=all> | <br clear=all> | ||

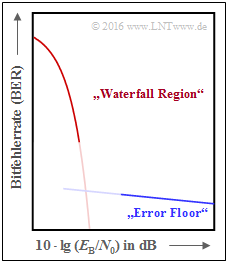

| − | Die Kurven für $n = 2^8$ bis $n = 2^{10}$ weisen zudem auf einen Effekt hin, den wir schon bei den [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Leistungsf.C3.A4higkeit_der_Turbocodes| Turbocodes]] festgestellt haben: | + | [[Datei:P ID3080 KC T 4 4 S4b v4.png|right|frame| „Waterfall Region & Error Floor”]] |

| − | + | Die Kurven für $n = 2^8$ bis $n = 2^{10}$ weisen zudem auf einen Effekt hin, den wir schon bei den [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Leistungsf.C3.A4higkeit_der_Turbocodes| Turbocodes]] festgestellt haben: | |

| − | |||

| − | |||

| − | |||

| + | *Zuerst fällt die BER–Kurve steil ab ⇒ „Waterfall Region”. | ||

| + | *Danach folgt ein Knick und ein Verlauf mit deutlich geringerer Steigung ⇒ „Error Floor”. | ||

| + | *Die qualitative untere Grafik verdeutlicht den Effekt, der natürlich nicht abrupt einsetzt (Übergang nicht eingezeichnet).<br> | ||

| − | Ein (LDPC–)Code ist immer dann als gut zu bezeichnen, wenn | + | |

| + | Ein (LDPC–) Code ist immer dann als gut zu bezeichnen, wenn | ||

* die BER–Kurve nahe der Shannon–Grenze steil abfällt,<br> | * die BER–Kurve nahe der Shannon–Grenze steil abfällt,<br> | ||

| − | * der „Error Floor” bei sehr niedrigen BER–Werten liegt (Ursachen hierfür siehe nächste Seite, Beispiel 5),<br> | + | * der „Error Floor” bei sehr niedrigen BER–Werten liegt (Ursachen hierfür siehe nächste Seite, $\text{Beispiel 5)}$,<br> |

* die Anzahl der erforderlichen Iterationen handhabbar ist, und<br> | * die Anzahl der erforderlichen Iterationen handhabbar ist, und<br> | ||

| Zeile 192: | Zeile 211: | ||

<br> | <br> | ||

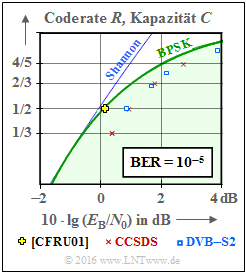

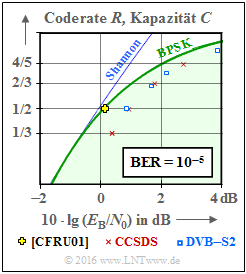

[[Datei:P ID3087 KC T 4 4 S5a v3.png|right|frame|LDPC–Codes im Vergleich zur Shannon–Grenze]] | [[Datei:P ID3087 KC T 4 4 S5a v3.png|right|frame|LDPC–Codes im Vergleich zur Shannon–Grenze]] | ||

| − | In diesem Kapitel wurden vorwiegend reguläre LDPC–Codes behandelt, auch im BER–Diagramm auf der letzten Seite. | + | In diesem Kapitel wurden vorwiegend reguläre LDPC–Codes behandelt, auch im $\rm BER$–Diagramm auf der letzten Seite. Die Ignoranz der irregulären LDPC–Codes ist nur der Kürze dieses Kapitels geschuldet, nicht deren Leistungsfähigkeit. Im Gegenteil: |

| − | |||

| − | Die Ignoranz der irregulären LDPC–Codes ist nur der Kürze dieses Kapitels geschuldet, nicht deren Leistungsfähigkeit. Im Gegenteil: | ||

* Irreguläre LDPC–Codes gehören zu den besten Kanalcodes überhaupt. | * Irreguläre LDPC–Codes gehören zu den besten Kanalcodes überhaupt. | ||

| − | *Das gelbe Kreuz in der Grafik liegt praktisch auf der informationstheoretischen Grenzkurve für binäre Eingangssignale (grüne Kurve, mit BPSK beschriftet). | + | *Das gelbe Kreuz in der Grafik liegt praktisch auf der informationstheoretischen Grenzkurve für binäre Eingangssignale (grüne Kurve, mit $\rm BPSK$ beschriftet). |

| − | *Die Codewortlänge dieses irregulären Rate–1/2–Codes von [CFRU01]<ref>Chung S.Y; Forney Jr., G.D.; Richardson, T.J.; Urbanke, R.: ''On the Design of Low-Density Parity- Check Codes within 0.0045 dB of the Shannon Limit.'' – In: IEEE Communications Letters, vol. 5, no. 2 (2001), pp. 58–60.</ref> beträgt $2 \cdot 10^6$. | + | *Die Codewortlänge dieses irregulären Rate–$1/2$–Codes von [CFRU01]<ref>Chung S.Y; Forney Jr., G.D.; Richardson, T.J.; Urbanke, R.: ''On the Design of Low-Density Parity- Check Codes within 0.0045 dB of the Shannon Limit.'' – In: IEEE Communications Letters, vol. 5, no. 2 (2001), pp. 58–60.</ref> beträgt $n = 2 \cdot 10^6$. |

| − | *Daraus ist schon ersichtlich, dass dieser Code nicht für den praktischen Einsatz gedacht war, sondern für einen Rekordversuch getunt wurde.<br> | + | *Daraus ist schon ersichtlich, dass dieser Code nicht für den praktischen Einsatz gedacht war, sondern sogar für einen Rekordversuch getunt wurde.<br> |

| − | Bei der LDPC–Codekonstruktion geht man ja stets von der Prüfmatrix $\mathbf{H}$ aus. Für den gerade genannten Code hat diese die Dimension $1 \cdot 10^6 × 2 \cdot 10^6$, beinhaltet also $2 \cdot 10^{12}$ Matrixelemente. | + | Bei der LDPC–Codekonstruktion geht man ja stets von der Prüfmatrix $\mathbf{H}$ aus. Für den gerade genannten Code hat diese die Dimension $1 \cdot 10^6 × 2 \cdot 10^6$, beinhaltet also $2 \cdot 10^{12}$ Matrixelemente. |

<br clear=all> | <br clear=all> | ||

{{BlaueBox|TEXT= | {{BlaueBox|TEXT= | ||

| − | $\text{Fazit:}$ Füllt man die Matrix per Zufallsgenerator mit (wenigen) Einsen ⇒ „<i>Low–density</i>” | + | $\text{Fazit:}$ Füllt man die Matrix per Zufallsgenerator mit (wenigen) Einsen ⇒ „<i>Low–density</i>”, so spricht man von <b>unstrukturiertem Code–Design</b>. Dies kann zu langen Codes mit guter Performance führen, manchmal aber auch zu folgenden Problemen: |

| − | *Die Komplexität des Coders kann zunehmen, da trotz Modifikation der Prüfmatrix $\mathbf{H}$ sichergestellt werden muss, dass die Generatormatrix $\mathbf{G}$ systematisch | + | *Die Komplexität des Coders kann zunehmen, da trotz Modifikation der Prüfmatrix $\mathbf{H}$ sichergestellt werden muss, dass die Generatormatrix $\mathbf{G}$ systematisch ist.<br> |

| − | * | + | *Es erfordert eine aufwändige Hardware–Realisierung des iterativen Decoders.<br> |

| − | *„Error Floor” durch einzelne Einsen in einer Spalte (oder Zeile) sowie kurze Schleifen ⇒ siehe Beispiel | + | *Es kommt zu einem „Error Floor” durch einzelne Einsen in einer Spalte (oder Zeile) sowie durch kurze Schleifen ⇒ siehe nachfolgendes Beispiel.}}<br><br> |

{{GraueBox|TEXT= | {{GraueBox|TEXT= | ||

| − | $\text{Beispiel 5:}$ Im linken Teil der Grafik ist der Tanner–Graph für einen regulären LDPC–Code mit der Prüfmatrix $\mathbf{H}_1$ dargestellt. Grün eingezeichnet ist ein Beispiel für die minimale Schleifenlänge (englisch: <i>Girth</i>). Diese Kenngröße gibt an, wieviele Kanten man mindestens durchläuft, bis man von einem <i>Check Node</i> $C_j$ wieder bei diesem landet (oder von $V_i$ zu $V_i$ | + | $\text{Beispiel 5:}$ Im linken Teil der Grafik ist der Tanner–Graph für einen regulären LDPC–Code mit der Prüfmatrix $\mathbf{H}_1$ dargestellt. Grün eingezeichnet ist ein Beispiel für die minimale Schleifenlänge (englisch: <i>Girth</i>). Diese Kenngröße gibt an, wieviele Kanten man mindestens durchläuft, bis man von einem <i>Check Node</i> $C_j$ wieder bei diesem landet $($oder von $V_i$ zu $V_i)$. Im linken Beispiel ergibt sich die minimale Kantenlänge $6$, zum Beispiel der Weg $C_1 → V_1 → C_3 → V_5 → C_2 → V_2 → C_1$.<br> |

[[Datei:P ID3088 KC T 4 4 S4c v3.png|center|frame|Zur Definition eines „Girth”|class=fit]] | [[Datei:P ID3088 KC T 4 4 S4c v3.png|center|frame|Zur Definition eines „Girth”|class=fit]] | ||

| − | Vertauscht man in der Prüfmatrix nur zwei Einsen ⇒ Matrix $\mathbf{H}_2$, so wird der LDPC–Code irregulär: | + | Vertauscht man in der Prüfmatrix nur zwei Einsen ⇒ Matrix $\mathbf{H}_2$, so wird der LDPC–Code irregulär: |

| − | *Die minimale Schleifenlänge ist nun $4$, von $C_1 → V_4 → C_4 → V_6 → C_1$. | + | *Die minimale Schleifenlänge ist nun $4$, von $C_1 → V_4 → C_4 → V_6 → C_1$. |

| − | *Ein kleiner <i>Girth</i> führt zu einem | + | *Ein kleiner <i>Girth</i> führt zu einem ausgeprägten „Error Floor” im BER–Verlauf.}}<br> |

== Einige Anwendungsgebiete für LDPC–Codes == | == Einige Anwendungsgebiete für LDPC–Codes == | ||

| Zeile 225: | Zeile 242: | ||

Im nebenstehenden Schaubild sind im Vergleich zur AWGN–Kanalkapazität zwei Kommunikations–Standards eingetragen, die auf strukturierten (regulären) LDPC–Codes basieren.<br> | Im nebenstehenden Schaubild sind im Vergleich zur AWGN–Kanalkapazität zwei Kommunikations–Standards eingetragen, die auf strukturierten (regulären) LDPC–Codes basieren.<br> | ||

| − | Anzumerken ist, dass für die eingezeichneten standardisierten Codes die Bitfehlerrate $10^{-5}$ zugrunde liegt, während die Kapazitätskurven (entsprechend der Informationstheorie) für die Fehlerwahrscheinlichkeit | + | Anzumerken ist, dass für die eingezeichneten standardisierten Codes die Bitfehlerrate ${\rm BER}=10^{-5}$ zugrunde liegt, während die Kapazitätskurven (entsprechend der Informationstheorie) für die Fehlerwahrscheinlichkeit „Null” gelten. |

| − | Rote Kreuze zeigen die '''LDPC–Codes nach CCSDS''' (<i>Consultative Comittee for Space Data Systems</i>), entwickelt für ferne Weltraummissionen: | + | Rote Kreuze zeigen die '''LDPC–Codes nach CCSDS''' (<i>Consultative Comittee for Space Data Systems</i>), entwickelt für ferne Weltraummissionen: |

| − | *Diese Klasse stellt Codes der Rate $1/3$, $1/2$, $2/3$ und $4/5$ bereit. | + | *Diese Klasse stellt Codes der Rate $1/3$, $1/2$, $2/3$ und $4/5$ bereit. |

| − | *Alle Punkte liegen ca. $1 \ \rm dB$ rechts von der Kapazitätskurve für binären Eingang (grüne Kurve „BPSK”).<br> | + | *Alle Punkte liegen ca. $1 \ \rm dB$ rechts von der Kapazitätskurve für binären Eingang (grüne Kurve „BPSK”).<br> |

| − | Die blauen Rechtecke markieren die '''LDPC–Codes für DVB–T2/S2'''. Die Abkürzungen stehen für „Digital Video Broadcasting – Terrestrial” bzw. „Digital Video Broadcasting – Satellite”, und die „$2$” macht deutlich, dass es sich jeweils um die zweite Generation (von 2005 bzw. 2009) handelt. | + | Die blauen Rechtecke markieren die '''LDPC–Codes für DVB–T2/S2'''. Die Abkürzungen stehen für „Digital Video Broadcasting – Terrestrial” bzw. „Digital Video Broadcasting – Satellite”, und die Kennzeichnung „$2$” macht deutlich, dass es sich jeweils um die zweite Generation (von 2005 bzw. 2009) handelt. |

| − | *Der Standard ist durch 22 Prüfmatrizen definiert, die Raten von etwa $0.2$ bis zu $19/20$ zur Verfügung stellen. | + | *Der Standard ist durch $22$ Prüfmatrizen definiert, die Raten von etwa $0.2$ bis zu $19/20$ zur Verfügung stellen. |

| − | *Je elf Varianten gelten für die Codelänge $64800$ Bit (<i>Normal FECFRAME</i>) bzw. $16200$ Bit (<i>Short FECFRAME</i>). | + | *Je elf Varianten gelten für die Codelänge $64800$ Bit (<i>Normal FECFRAME</i>) bzw. $16200$ Bit (<i>Short FECFRAME</i>). |

| − | *Kombiniert mit [[Modulationsverfahren/Quadratur%E2%80%93Amplitudenmodulation#Weitere_Signalraumkonstellationen| Modulationsverfahren hoher Ordnung]] (8PSK, 16–ASK/PSK, | + | *Kombiniert mit [[Modulationsverfahren/Quadratur%E2%80%93Amplitudenmodulation#Weitere_Signalraumkonstellationen| Modulationsverfahren hoher Ordnung]] (8PSK, 16–ASK/PSK, ... ) zeichnen sich die Codes durch eine große spektrale Effizienz aus.<br> |

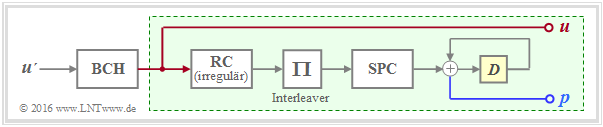

| − | Die DVB–Codes gehören zu den <i>Irregular Repeat Accumulate</i> (IRA) Codes die erstmals im Jahr 2000 in [JKE00]<ref name='JKE00'>Jin, H.; Khandekar, A.; McEliece, R.: ''Irregular Repeat–Accumulate Codes.'' Proc. of the 2nd Int. Symp. on Turbo Codes and Related Topics, Best, France, S. 1–8., Sept. 2000.</ref> vorgestellt wurden. | + | Die DVB–Codes gehören zu den <i>Irregular Repeat Accumulate</i> $\rm (IRA)$ Codes, die erstmals im Jahr 2000 in [JKE00]<ref name='JKE00'>Jin, H.; Khandekar, A.; McEliece, R.: ''Irregular Repeat–Accumulate Codes.'' Proc. of the 2nd Int. Symp. on Turbo Codes and Related Topics, Best, France, S. 1–8., Sept. 2000.</ref> vorgestellt wurden. |

[[Datei:P ID3082 KC T 4 4 S6a v3.png|center|frame|IRA–Coder bei DVB–S2/T2|class=fit]] | [[Datei:P ID3082 KC T 4 4 S6a v3.png|center|frame|IRA–Coder bei DVB–S2/T2|class=fit]] | ||

Die Grafik zeigt die Grundstruktur des Coders. | Die Grafik zeigt die Grundstruktur des Coders. | ||

| − | *Der grün hinterlegte Teil – mit Repetition Code (RC), Interleaver, Single Parity–Code (SPC) sowie Akkumulator – entspricht exakt einem seriell–verketteten Turbocode ⇒ siehe [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Einige_Anwendungsgebiete_f.C3.BCr_Turbocodes| RA–Coder]]. | + | *Der grün hinterlegte Teil – mit Repetition Code $\rm (RC)$, Interleaver, Single Parity–Code $\rm (SPC)$ sowie Akkumulator – entspricht exakt einem seriell–verketteten Turbocode ⇒ siehe [[Kanalcodierung/Grundlegendes_zu_den_Turbocodes#Einige_Anwendungsgebiete_f.C3.BCr_Turbocodes| RA–Coder]]. |

| − | *Die Beschreibung des IRA–Codes basiert aber allein auf der Prüfmatrix $\mathbf{H}$, die sich durch den <i>irregulären Repetition Code</i> in eine für die Decodierung günstige Form bringen lässt. | + | *Die Beschreibung des IRA–Codes basiert aber allein auf der Prüfmatrix $\mathbf{H}$, die sich durch den <i>irregulären Repetition Code</i> in eine für die Decodierung günstige Form bringen lässt. |

| − | *Als äußerer Code wird zudem ein hochratiger BCH–Code (von | + | *Als äußerer Code wird zudem ein hochratiger BCH–Code (von $\rm B$ose–$\rm C$haudhuri–$\rm H$ocquenghem) verwendet, der den <i>Error Floor</i> herabsetzen soll.<br> |

In der Grafik am Seitenanfang nicht eingetragen sind | In der Grafik am Seitenanfang nicht eingetragen sind | ||

| − | *die LDPC–Codes für den Standard <i>DVB Return Channel Terrestrial</i> (RCS), | + | *die LDPC–Codes für den Standard <i>DVB Return Channel Terrestrial</i> (RCS), |

| − | *die LDPC–Codes für den WiMax–Standard (IEEE 802.16), sowie | + | *die LDPC–Codes für den WiMax–Standard (IEEE 802.16), sowie |

| − | *die LDPC–Codes für das 10GBASE–T–Ethernet, | + | *die LDPC–Codes für das 10GBASE–T–Ethernet, |

| + | |||

die gewisse Ähnlichkeiten mit den IRA–Codes aufweisen.<br> | die gewisse Ähnlichkeiten mit den IRA–Codes aufweisen.<br> | ||

| Zeile 258: | Zeile 276: | ||

== Aufgaben zum Kapitel == | == Aufgaben zum Kapitel == | ||

<br> | <br> | ||

| − | [[Aufgaben:4.11 Analyse von Prüfmatrizen|Aufgabe 4.11: | + | [[Aufgaben:4.11 Analyse von Prüfmatrizen|Aufgabe 4.11: Analyse von Prüfmatrizen]] |

| − | [[Aufgaben:4.11Z_Coderate_aus_der_Pr%C3%BCfmatrix|Zusatzaufgabe 4.11Z: | + | [[Aufgaben:4.11Z_Coderate_aus_der_Pr%C3%BCfmatrix|Zusatzaufgabe 4.11Z: Coderate aus der Prüfmatrix]] |

| − | [[Aufgaben: | + | [[Aufgaben:Aufgabe_4.12:_Regulärer_und_irregulärer_Tanner–Graph|Aufgabe 4.12: Regulärer/irregulärer Tanner–Graph]] |

| − | [[Aufgaben:4.13 Decodierung von LDPC–Codes|Aufgabe 4.13: | + | [[Aufgaben:4.13 Decodierung von LDPC–Codes|Aufgabe 4.13: Decodierung von LDPC–Codes]] |

==Quellenverzeichnis== | ==Quellenverzeichnis== | ||

Aktuelle Version vom 15. Dezember 2022, 17:08 Uhr

Inhaltsverzeichnis

- 1 Einige Charakteristika der LDPC–Codes

- 2 Zweiteilige LDPC–Graphenrepräsentation – Tanner–Graph

- 3 Iterative Decodierung von LDPC–Codes

- 4 Leistungsfähigkeit regulärer LDPC–Codes

- 5 Leistungsfähigkeit irregulärer LDPC–Codes

- 6 Einige Anwendungsgebiete für LDPC–Codes

- 7 Aufgaben zum Kapitel

- 8 Quellenverzeichnis

Einige Charakteristika der LDPC–Codes

Die Low–density Parity–check Codes – kurz LDPC–Codes – wurden bereits Anfang der 1960er Jahre erfunden und gehen auf die Dissertation [Gal63][1] von Robert G. Gallager zurück.

Die Idee kam allerdings aufgrund der damaligen Prozessorentechnologie um einige Jahrzehnte zu früh. Schon drei Jahre nach Berrou's Erfindung der Turbocodes 1993 erkannten dann allerdings David J. C. MacKay und Radford M. Neal das riesige Potential der LDPC–Codes, wenn man diese ebenso wie die Turbocodes iterativ symbolweise decodiert. Sie erfanden die LDPC–Codes quasi neu.

Wie aus dem Namensbestandteil „Parity–check” bereits hervorgeht, handelt es sich bei diesen Codes um lineare Blockcodes entsprechend den Ausführungen im ersten Hauptkapitel . Deshalb gilt auch hier:

- Das Codewort ergibt sich aus dem Informationswort $\underline{u}$ (dargestellt mit $k$ Binärsymbolen) und der Generatormatrix $\mathbf{G}$ der Dimension $k × n$ zu $\underline{x} = \underline{u} \cdot \mathbf{G}$ ⇒ Codewortlänge $n$.

- Die Prüfgleichungen ergeben sich aus der Identität $\underline{x} \cdot \mathbf{H}^{\rm T} ≡ 0$, wobei $\mathbf{H}$ die Prüfmatrix bezeichnet. Diese besteht aus $m$ Zeilen und $n$ Spalten. Während im ersten Kapitel grundsätzlich $m = n -k$ gegolten hat, fordern wir für die LPDC–Codes lediglich noch $m ≥ n -k$.

Ein gravierender Unterschied zwischen einem LDPC–Code und einem herkömmlichen Blockcode nach der Beschreibung im ersten Kapitel ist, dass die Prüfmatrix $\mathbf{H}$ nur spärlich mit Einsen besetzt ist („Low–density”).

$\text{Beispiel 1:}$ Die Grafik zeigt beispielhaft die Prüfmatrizen $\mathbf{H}$ für

- den Hamming–Code mit Codelänge $n = 15, \ m = 4$ ⇒ $k = 11$ Informationsbits,

- den LDPC–Code aus [Liv15][2] der Länge $n = 12$ und mit $m = 9$ Prüfgleichungen ⇒ $k ≥ 3$.

- In der linken Grafik beträgt der Anteil der Einsen $32/60 \approx 53.3\%$, wohingegen in der rechten Grafik der Einsen–Anteil mit $36/108 = 33.3\%$ geringer ist.

- Bei den für die Praxis relevanten LDPC–Codes (großer Länge) ist der Einsen–Anteil noch deutlich niedriger.

Wir analysieren nun die beiden Prüfmatrizen anhand der Rate und des Hamming–Gewichts:

- Die Rate des betrachteten Hamming–Codes (linke Grafik) ist $R = k/n = 11/15 \approx 0.733$. Das Hamming–Gewicht einer jeden der vier Zeilen ist $w_{\rm Z}= 8$, während die Hamming–Gewichte $w_{\rm S}(i)$ der Spalten zwischen 1 und 4 variieren. Für die Spalten–Laufvariable gilt hier: $1 ≤ i ≤ 15$.

- Beim betrachteten LDPC–Code gibt es in allen Zeilen vier Einsen ⇒ $w_{\rm Z} = 4$ und in allen Spalten drei Einsen ⇒ $w_{\rm S} = 3$. Die Codebezeichnung $(w_{\rm Z}, \ w_{\rm S})$ LDPC–Code verwendet genau diese Parameter. Beachten Sie die unterschiedliche Nomenklatur zum „$(n, \ k, \ m)$ Hamming–Code”.

- Man spricht hier von einem regulären LDPC–Code, da alle Zeilengewichte $w_{\rm Z}(j)$ für $1 ≤ j ≤ m$ konstant gleich $w_{\rm Z}$ sind und auch alle Spaltengewichte $($mit den Indizes $1 ≤ i ≤ n)$ gleich sind: $w_{\rm S}(i) = w_{\rm S} = {\rm const.}$ Ist diese Bedingung nicht erfüllt, so liegt ein irregulärer LDPC–Code vor.

$\text{Merkmal der LDPC-Codes}$ Für die Coderate kann man allgemein (wenn $k$ nicht bekannt ist) nur eine Schranke angeben:

- $$R ≥ 1 - w_{\rm S}/w_{\rm Z}.$$

- Das Gleichheitszeichen gilt dann, wenn alle Zeilen von $\mathbf{H}$ linear unabhängig sind ⇒ $m = n \, – k$. Dann ergibt sich die herkömmliche Gleichung:

- $$R = 1 - w_{\rm S}/w_{\rm Z} = 1 - m/n = k/n.$$

- Dagegen gilt für die Coderate eines irregulären LDPC–Codes und auch für den links skizzierten $(15, 11, 4)$ Hammingcode:

- $$R \ge 1 - \frac{ {\rm E}[w_{\rm S}]}{ {\rm E}[w_{\rm Z}]} \hspace{0.5cm}{\rm mit}\hspace{0.5cm} {\rm E}[w_{\rm S}] =\frac{1}{n} \cdot \sum_{i = 1}^{n}w_{\rm S}(i) \hspace{0.5cm}{\rm und}\hspace{0.5cm} {\rm E}[w_{\rm Z}] =\frac{1}{m} \cdot \sum_{j = 1}^{ m}w_{\rm Z}(j) \hspace{0.05cm}.$$

- Da beim Hamming–Code die $m = n - k$ Prüfgleichungen linear voneinander unabhängig sind, kann das „$≥$”–Zeichen durch das Gleichheitszeichen ersetzt werden, was gleichzeitig $R = k/n$ bedeutet.

Weitere Informationen zu diesem Thema finden Sie in Aufgabe 4.11 und Aufgabe 4.11Z.

Zweiteilige LDPC–Graphenrepräsentation – Tanner–Graph

Alle wesentlichen Merkmale eines LDPC–Codes sind in der Prüfmatrix $\mathbf{H} = (h_{j,\hspace{0.05cm}i})$ enthalten und lassen sich durch einen so genannten Tanner–Graphen darstellen. Es handelt sich um eine Bipartite Graph Representation, wobei die deutsche Übersetzung von „bipartite” in etwa „zweiteilig” lautet. Bevor wir beispielhafte Tanner–Graphen genauer betrachten und analysieren, müssen zuerst noch einige geeignete Beschreibungsgrößen definiert werden:

- Die $n$ Spalten der Prüfmatrix $\mathbf{H}$ stehen jeweils für ein Codewortbit. Da jedes Codewortbit sowohl ein Informationsbit als auch ein Prüfbit sein kann, hat sich hierfür die neutrale Bezeichnung Varibale Node (VN) durchgesetzt. Das $i$–te Codewortbit wird $V_i$ genannt und die Menge aller Variable Nodes (VNs) ist $\{V_1, \ \text{...}\hspace{0.05cm} , \ V_i, \ \text{...}\hspace{0.05cm} , \ V_n\}$.

- Die $m$ Zeilen von $\mathbf{H}$ beschreiben jeweils eine Prüfgleichung (englisch: Parity–check Equation). Wir bezeichnen im folgenden eine solche Prüfgleichung als Check Node (CN). Die Menge aller Check Nodes (CNs) ist $\{C_1, \ \text{...}\hspace{0.05cm} , \ C_j, \ \text{...}\hspace{0.05cm} , \ C_m\}$, wobei $C_j$ die Prüfgleichung der $j$–ten Zeile angibt.

- Im Tanner–Graphen werden die $n$ Variable Nodes $V_i$ als Kreise und die $m$ Check Nodes $C_j$ als Quadrate dargestellt. Ist das Matrixelement in Zeile $j$ und Spalte $i \hspace{0.15cm} ⇒ \hspace{0.15cm} h_{j,\hspace{0.05cm}i} = 1$, so gibt es eine Verbindungslinie (englisch: Edge) zwischen dem Variable Node $V_i$ und dem Check Node $C_j$.

$\text{Beispiel 2:}$ Zur Verdeutlichung obiger Begriffe ist rechts ein beispielhafter Tannergraphen mit

- den Variable Nodes (kurz: VNs) $V_1$ bis $V_4$, und

- den Check Nodes (kurz: CNs) $C_1$ bis $C_3$

angegeben. Der zugehörige Code hat allerdings keinerlei praktische Bedeutung.

Man erkennt aus der Grafik:

- Die Codelänge ist $n = 4$ und es gibt $m = 3$ Prüfgleichungen. Damit hat die Prüfmatrix $\mathbf{H}$ die Dimension $3×4$.

- Es gibt insgesamt sechs Verbindungslinien (englisch: Edges). Damit sind sechs der zwölf Elemente $h_{j,\hspace{0.05cm}i}$ von $\mathbf{H}$ Einsen.

- Bei jedem Check Node kommen zwei Linien an ⇒ Die Hamming–Gewichte aller Zeilen gleich sind: $w_{\rm Z}(j) = 2 = w_{\rm Z}$.

- Von den Knoten $V_1$ und $V_4$ gibt es jeweils nur einen Übergang zu einem Check Node, von $V_2$ und $V_3$ dagegen zwei.

Aus diesem Grund handelt es sich um einen irregulären Code.

Die Prüfmatrix lautet demnach:

- \[{ \boldsymbol{\rm H} } = \begin{pmatrix} 1 &1 &0 &0\\ 0 &1 &1 &0\\ 0 &0 &1 &1 \end{pmatrix}\hspace{0.05cm}.\]

$\text{Beispiel 3:}$ Es folgt nun ein praxisrelevanteres Beispiel. In der Aufgabe 4.11 wurden zwei Prüfmatrizen analysiert:

- Der Coder entsprechend der Matrix $\mathbf{H}_1$ ist systematisch. Die Codeparameter sind $n = 8, \ k = 4$ und $m = 4$ ⇒ Rate $1/2$. Der Code ist irregulär, da die Hamming–Gewichte nicht für alle Spalten gleich sind. In der Grafik ist diese „irreguläre $\mathbf{H}$–Matrix” oben angegeben.

- Unten angegeben ist die „reguläre $\mathbf{H}$–Matrix” entsprechend der Matrix $\mathbf{H}_3$ in Aufgabe 4.11. Die Zeilen sind Linearkombinationen der oberen Matrix. Für diesen nicht systematischen Coder gilt mit $w_{\rm S} = 2$ und $w_{\rm Z} = 4$ für die Rate: $R \ge 1 - w_{\rm S}/w_{\rm Z} = 1/2$.

Die Grafik zeigt die zugehörigen Tanner–Graphen:

- Der linke Graph bezieht sich auf die obere (irreguläre) Matrix. Die acht Variable Nodes (abgekürzt VNs) $V_i$ sind mit den vier Check Nodes (abgekürzt CNs) $C_j$ verbunden, falls das Element in Zeile $j$ und Spalte $i \hspace{0.15cm} ⇒ \hspace{0.15cm} h_{j,\hspace{0.05cm}i}$ gleich $1$ ist. Andernfalls $($falls $h_{j,\hspace{0.05cm}i} = 0)$ besteht keine Verbindung.

- Dieser Graph ist für die iterative symbolweise Decodierung nicht sonderlich gut geeignet. Die VNs $V_5, \ \text{...}\hspace{0.05cm} , \ V_8$ sind jeweils nur mit einem CN verbunden, was für die Decodierung keine Information liefert.

- Im rechten Tanner–Graph für den regulären Code erkennt man, dass hier von jedem Variable Node $V_i$ zwei Verbindungslinien (englisch: Edges) abgehen und von jedem Check Node $C_j$ deren vier. Damit ist bei der Decodierung in jeder Iterationsschleife ein Informationsgewinn möglich.

- Man erkennt zudem, dass hier beim Übergang vom irregulären zum äquivalenten regulären Code der Einsen–Anteil zunimmt, im Beispiel von $37.5\%$ auf $50\%$. Diese Aussage kann allerdings nicht verallgemeinert werden.

Iterative Decodierung von LDPC–Codes

Als Beispiel für die iterative LDPC–Decodierung wird nun der so genannte Message–passing Algorithm beschrieben. Wir verdeutlichen diesen anhand des rechten Tanner–Graphen im $\text{Beispiel 3}$ auf der vorherigen Seite und damit für die dort angegebene reguläre Prüfmatrix.

$\text{Prinzip:}$ Beim Message–passing Algorithm erfolgt abwechselnd (oder iterativ) ein Informationsaustausch zwischen den Variable Nodes (VNs) $V_1, \ \text{...}\hspace{0.05cm} , \ V_n$ und den Check Nodes (CNs) $C_1 , \ \text{...}\hspace{0.05cm} , \ C_m$.

Für das betrachtete Beispiel gilt:

- Es gibt $n = 8$ Variable Nodes und $m = 4$ Check Nodes . Da ein regulärer LDPC–Code vorliegt, gehen von jedem Variable Node $d_{\rm V} = 2$ Verbindungslinien zu einem Check Node und jeder Check Node ist mit $d_{\rm C} = 4$ Variable Nodes verbunden.

- Der Variable Node Degree $d_{\rm V}$ ist gleich dem Hamming–Gewicht einer jeden Spalte $(w_{\rm S})$ und für den Check Node Degree gilt: $d_{\rm C} = w_{\rm Z}$ (Hamming–Gewicht einer jeden Zeile).

- In der folgenden Beschreibung verwenden wir auch die Begriffe Nachbarn eines Variable Nodes ⇒ $N(V_i)$ sowie Nachbarn eines Check Nodes ⇒ $N(C_j)$, wobei wir uns hier auf implizite Definitionen beschränken:

- \[N(V_1) = \{ C_1, C_2\}\hspace{0.05cm}, \hspace{0.3cm}N(V_2) = \{ C_3, C_4\}\hspace{0.05cm}, \hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.15cm},\hspace{0.3cm}N(V_8) = \{ C_1, C_4\}\hspace{0.05cm},\]

- \[N(C_1) = \{ V_1, V_4, V_5, V_8\}\hspace{0.05cm}, \hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.05cm}.\hspace{0.15cm}\hspace{0.05cm}, \hspace{0.3cm}N(C_4) = \{ V_2, V_3, V_6, V_8\}\hspace{0.05cm}.\]

$\text{Beispiel 4:}$ Die Skizze aus [Liv15][2] zeigt den Austausch von Information zwischen dem Variable Node $V_i$ und dem Check Node $C_j$ – ausgedrückt durch Log–Likelihood Ratios (kurz: $L$–Werte).

Der Informationsaustausch geschieht in zwei Richtungen:

- $L(V_i → C_j)$: Extrinsische Information aus $V_i$–Sicht, Apriori–Information aus $C_j$–Sicht.

- $L(C_j → V_i)$: Extrinsische Information aus $C_j$–Sicht, Apriori–Information aus $V_i$–Sicht.

Die Beschreibung des Decodieralgorithmus wird fortgesetzt:

Initialisierung: Zu Beginn der Decodierung erhalten die Variable Nodes (VNs) keine Apriori–Information von den Check Nodes (CNs), und es gilt für $1 ≤ i ≤ n \text{:}$

- $$L(V_i → C_j) = L_{\rm K}(V_i).$$

Wie aus der Grafik am Seitenbeginn ersichtlich, ergeben sich diese Kanal–$L$–Werte $L_{\rm K}(V_i)$ aus den Empfangswerten $y_i$.

Check Node Decoder: Jeder Knoten $C_j$ repräsentiert eine Prüfgleichung. So steht $C_1$ für die Gleichung $V_1 + V_4 + V_5 + V_8 = 0$. Man erkennt den Zusammenhang zur extrinsischen Information bei der symbolweisen Decodierung des Single Parity–check Codes.

In Analogie zur Seite Zur Berechnung der extrinsischen L–Werte und zur Aufgabe 4.4 gilt somit für den extrinsischen $L$–Wert von $C_j$ und gleichzeitig für die Apriori–Information bezüglich $V_i$:

- \[L(C_j \rightarrow V_i) = 2 \cdot {\rm tanh}^{-1}\left [ \prod\limits_{V \in N(C_j)\hspace{0.05cm},\hspace{0.1cm} V \ne V_i} \hspace{-0.35cm}{\rm tanh}\left [L(V \rightarrow C_j \right ] /2) \right ] \hspace{0.05cm}.\]

Variable Node Decoder: Im Gegensatz zum Check Node Decoder (CND) besteht beim Variable Node Decoder (VND) eine Verwandtschaft zur Decodierung eines Repetition Codes, weil alle mit $V_i$ verbundenen Check Nodes $C_j$ demselben Bit entsprechen ⇒ dieses Bit wird quasi $d_{\rm V}$ mal wiederholt.

In Analogie zu zur Seite Zur Berechnung der extrinsischen L–Werte gilt für den extrinsischen $L$–Wert von $V_i$ und gleichzeitig für die Apriori–Information bezüglich $C_j$:

- \[L(V_i \rightarrow C_j) = L_{\rm K}(V_i) + \hspace{-0.55cm} \sum\limits_{C \hspace{0.05cm}\in\hspace{0.05cm} N(V_i)\hspace{0.05cm},\hspace{0.1cm} C \hspace{0.05cm}\ne\hspace{0.05cm} C_j} \hspace{-0.55cm}L(C \rightarrow V_i) \hspace{0.05cm}.\]

Das folgende Schaubild des beschriebenen Decodieralgorithmus' für LDPC–Codes zeigt Ähnlichkeiten mit der Vorgehensweise bei seriell verketteten Turbocodes.

- Um eine vollständige Analogie zwischen der LDPC– und der Turbodecodierung herzustellen, ist auch hier zwischen dem Variable Node Decoder (VND) und dem Check Node Decoder (CND) ein „Interleaver ” sowie ein „De–Interleaver ” eingezeichnet.

- Da es sich hierbei nicht um reale Systemkomponenten handelt, sondern nur um Analogien, haben wir diese Begriffe in Hochkommata gesetzt.

Leistungsfähigkeit regulärer LDPC–Codes

Wir betrachten nun wie in [Str14][3] fünf reguläre LDPC–Codes. Die Grafik zeigt die Bitfehlerrate $\rm (BER)$ abhängig vom AWGN–Parameter $10 \cdot {\rm lg} \, E_{\rm B}/N_0$. Zum Vergleich ist auch die Kurve für uncodierte Übertragung eingezeichnet.

Diese LDPC–Codes zeigen folgende Eigenschaften:

- Die Prüfmatrizen $\mathbf{H}$ weisen jeweils $n$ Spalten und $m = n/2$ linear voneinander unabhängige Zeilen auf. In jeder Zeile gibt es $w_{\rm Z} = 6$ Einsen und in jeder Spalte $w_{\rm S} = 3$ Einsen.

- Der Einsen–Anteil beträgt $w_{\rm Z}/n = w_{\rm S}/m$, so dass bei großer Codewortlänge $n$ die Klassifizierung „Low–density” gerechtfertigt ist. Für die rote Kurve $(n = 2^{10})$ beträgt der Einsen–Anteil $0.6\%$.

- Die Rate aller Codes beträgt $R = 1 - w_{\rm S}/w_{\rm Z} = 1/2$. Wegen der linearen Unabhängigkeit der Matrixzeilen gilt aber auch $R = k/n$ mit der Informationswortlänge $k = n - m = n/2$.

Aus der Grafik erkennt man:

- Die Bitfehlerrate ist um so kleiner, je länger der Code ist:

- Für $10 \cdot {\rm lg} \, E_{\rm B}/N_0 = 2 \ \rm dB$ und $n = 2^8 = 256$ ergibt sich ${\rm BER} \approx 10^{-2}$.

- Für $n = 2^{12} = 4096$ dagegen nur ${\rm BER} \approx 2 \cdot 10^{-7}$.

- Mit $n = 2^{15} = 32768$ (violette Kurve) benötigt man $10 \cdot {\rm lg} \, E_{\rm B}/N_0 \approx 1.35 \ \rm dB$ für ${\rm BER} = 10^{-5}$.

- Der Abstand von der Shannon–Grenze $(0.18 \ \rm dB$ für $R = 1/2$ und BPSK$)$ beträgt ca. $1.2 \ \rm dB$.

Die Kurven für $n = 2^8$ bis $n = 2^{10}$ weisen zudem auf einen Effekt hin, den wir schon bei den Turbocodes festgestellt haben:

- Zuerst fällt die BER–Kurve steil ab ⇒ „Waterfall Region”.

- Danach folgt ein Knick und ein Verlauf mit deutlich geringerer Steigung ⇒ „Error Floor”.

- Die qualitative untere Grafik verdeutlicht den Effekt, der natürlich nicht abrupt einsetzt (Übergang nicht eingezeichnet).

Ein (LDPC–) Code ist immer dann als gut zu bezeichnen, wenn

- die BER–Kurve nahe der Shannon–Grenze steil abfällt,

- der „Error Floor” bei sehr niedrigen BER–Werten liegt (Ursachen hierfür siehe nächste Seite, $\text{Beispiel 5)}$,

- die Anzahl der erforderlichen Iterationen handhabbar ist, und

- diese Eigenschaften nicht erst bei nicht mehr praktikablen Blocklängen erreicht werden.

Leistungsfähigkeit irregulärer LDPC–Codes

In diesem Kapitel wurden vorwiegend reguläre LDPC–Codes behandelt, auch im $\rm BER$–Diagramm auf der letzten Seite. Die Ignoranz der irregulären LDPC–Codes ist nur der Kürze dieses Kapitels geschuldet, nicht deren Leistungsfähigkeit. Im Gegenteil:

- Irreguläre LDPC–Codes gehören zu den besten Kanalcodes überhaupt.

- Das gelbe Kreuz in der Grafik liegt praktisch auf der informationstheoretischen Grenzkurve für binäre Eingangssignale (grüne Kurve, mit $\rm BPSK$ beschriftet).

- Die Codewortlänge dieses irregulären Rate–$1/2$–Codes von [CFRU01][4] beträgt $n = 2 \cdot 10^6$.

- Daraus ist schon ersichtlich, dass dieser Code nicht für den praktischen Einsatz gedacht war, sondern sogar für einen Rekordversuch getunt wurde.

Bei der LDPC–Codekonstruktion geht man ja stets von der Prüfmatrix $\mathbf{H}$ aus. Für den gerade genannten Code hat diese die Dimension $1 \cdot 10^6 × 2 \cdot 10^6$, beinhaltet also $2 \cdot 10^{12}$ Matrixelemente.

$\text{Fazit:}$ Füllt man die Matrix per Zufallsgenerator mit (wenigen) Einsen ⇒ „Low–density”, so spricht man von unstrukturiertem Code–Design. Dies kann zu langen Codes mit guter Performance führen, manchmal aber auch zu folgenden Problemen:

- Die Komplexität des Coders kann zunehmen, da trotz Modifikation der Prüfmatrix $\mathbf{H}$ sichergestellt werden muss, dass die Generatormatrix $\mathbf{G}$ systematisch ist.

- Es erfordert eine aufwändige Hardware–Realisierung des iterativen Decoders.

- Es kommt zu einem „Error Floor” durch einzelne Einsen in einer Spalte (oder Zeile) sowie durch kurze Schleifen ⇒ siehe nachfolgendes Beispiel.

$\text{Beispiel 5:}$ Im linken Teil der Grafik ist der Tanner–Graph für einen regulären LDPC–Code mit der Prüfmatrix $\mathbf{H}_1$ dargestellt. Grün eingezeichnet ist ein Beispiel für die minimale Schleifenlänge (englisch: Girth). Diese Kenngröße gibt an, wieviele Kanten man mindestens durchläuft, bis man von einem Check Node $C_j$ wieder bei diesem landet $($oder von $V_i$ zu $V_i)$. Im linken Beispiel ergibt sich die minimale Kantenlänge $6$, zum Beispiel der Weg $C_1 → V_1 → C_3 → V_5 → C_2 → V_2 → C_1$.

Vertauscht man in der Prüfmatrix nur zwei Einsen ⇒ Matrix $\mathbf{H}_2$, so wird der LDPC–Code irregulär:

- Die minimale Schleifenlänge ist nun $4$, von $C_1 → V_4 → C_4 → V_6 → C_1$.

- Ein kleiner Girth führt zu einem ausgeprägten „Error Floor” im BER–Verlauf.

Einige Anwendungsgebiete für LDPC–Codes

Im nebenstehenden Schaubild sind im Vergleich zur AWGN–Kanalkapazität zwei Kommunikations–Standards eingetragen, die auf strukturierten (regulären) LDPC–Codes basieren.

Anzumerken ist, dass für die eingezeichneten standardisierten Codes die Bitfehlerrate ${\rm BER}=10^{-5}$ zugrunde liegt, während die Kapazitätskurven (entsprechend der Informationstheorie) für die Fehlerwahrscheinlichkeit „Null” gelten.

Rote Kreuze zeigen die LDPC–Codes nach CCSDS (Consultative Comittee for Space Data Systems), entwickelt für ferne Weltraummissionen:

- Diese Klasse stellt Codes der Rate $1/3$, $1/2$, $2/3$ und $4/5$ bereit.

- Alle Punkte liegen ca. $1 \ \rm dB$ rechts von der Kapazitätskurve für binären Eingang (grüne Kurve „BPSK”).

Die blauen Rechtecke markieren die LDPC–Codes für DVB–T2/S2. Die Abkürzungen stehen für „Digital Video Broadcasting – Terrestrial” bzw. „Digital Video Broadcasting – Satellite”, und die Kennzeichnung „$2$” macht deutlich, dass es sich jeweils um die zweite Generation (von 2005 bzw. 2009) handelt.

- Der Standard ist durch $22$ Prüfmatrizen definiert, die Raten von etwa $0.2$ bis zu $19/20$ zur Verfügung stellen.

- Je elf Varianten gelten für die Codelänge $64800$ Bit (Normal FECFRAME) bzw. $16200$ Bit (Short FECFRAME).

- Kombiniert mit Modulationsverfahren hoher Ordnung (8PSK, 16–ASK/PSK, ... ) zeichnen sich die Codes durch eine große spektrale Effizienz aus.

Die DVB–Codes gehören zu den Irregular Repeat Accumulate $\rm (IRA)$ Codes, die erstmals im Jahr 2000 in [JKE00][5] vorgestellt wurden.

Die Grafik zeigt die Grundstruktur des Coders.

- Der grün hinterlegte Teil – mit Repetition Code $\rm (RC)$, Interleaver, Single Parity–Code $\rm (SPC)$ sowie Akkumulator – entspricht exakt einem seriell–verketteten Turbocode ⇒ siehe RA–Coder.

- Die Beschreibung des IRA–Codes basiert aber allein auf der Prüfmatrix $\mathbf{H}$, die sich durch den irregulären Repetition Code in eine für die Decodierung günstige Form bringen lässt.

- Als äußerer Code wird zudem ein hochratiger BCH–Code (von $\rm B$ose–$\rm C$haudhuri–$\rm H$ocquenghem) verwendet, der den Error Floor herabsetzen soll.

In der Grafik am Seitenanfang nicht eingetragen sind

- die LDPC–Codes für den Standard DVB Return Channel Terrestrial (RCS),

- die LDPC–Codes für den WiMax–Standard (IEEE 802.16), sowie

- die LDPC–Codes für das 10GBASE–T–Ethernet,

die gewisse Ähnlichkeiten mit den IRA–Codes aufweisen.

Aufgaben zum Kapitel

Aufgabe 4.11: Analyse von Prüfmatrizen

Zusatzaufgabe 4.11Z: Coderate aus der Prüfmatrix

Aufgabe 4.12: Regulärer/irregulärer Tanner–Graph

Aufgabe 4.13: Decodierung von LDPC–Codes

Quellenverzeichnis

- ↑ Gallager, R. G.: Low–density Parity–check Codes. MIT Press, Cambridge, MA, 1963.

- ↑ 2,0 2,1 Liva, G.: Channels Codes for Iterative Decoding. Vorlesungsmanuskript, Lehrstuhl für Nachrichtentechnik, TU München und DLR Oberpfaffenhofen, 2015.

- ↑ Strutz, T.: Low–density Parity–check Codes – Eine Einführung. Vorlesungsmaterial. Hochschule für Telekommunikation, Leipzig, 2014. PDF-Dokument PDF-Dokument.

- ↑ Chung S.Y; Forney Jr., G.D.; Richardson, T.J.; Urbanke, R.: On the Design of Low-Density Parity- Check Codes within 0.0045 dB of the Shannon Limit. – In: IEEE Communications Letters, vol. 5, no. 2 (2001), pp. 58–60.

- ↑ Jin, H.; Khandekar, A.; McEliece, R.: Irregular Repeat–Accumulate Codes. Proc. of the 2nd Int. Symp. on Turbo Codes and Related Topics, Best, France, S. 1–8., Sept. 2000.