Aufgaben:Aufgabe 1.1: Wetterentropie: Unterschied zwischen den Versionen

Aus LNTwww

Markus (Diskussion | Beiträge) |

Markus (Diskussion | Beiträge) |

||

| Zeile 109: | Zeile 109: | ||

| − | [[Category:Aufgaben zu Informationstheorie | + | [[Category:Aufgaben zu Informationstheorie|^1.1 Gedächtnislose Nachrichtenquellen^]] |

Version vom 24. November 2016, 16:23 Uhr

- Eine Wetterstation fragt täglich verschiedene Regionen ab und bekommt als Antwort jeweils eine Meldung x zurück, nämlich

- x = B: Das Wetter ist eher schlecht.

- x = G: Das Wetter ist eher gut.

- Die Daten wurden über viele Jahre für verschiedene Gebiete in Dateien abgelegt, so dass die Entropien der B/G–Folgen ermittelt werden können:

- $$H = p_{\rm B} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm B}} + p_{\rm G} \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{p_{\rm G}}$$

- mit dem Logarithmus dualis

- $${\rm log}_2\hspace{0.1cm}p=\frac{{\rm lg}\hspace{0.1cm}p}{{\rm lg}\hspace{0.1cm}2}\hspace{0.3cm} \left ( = {\rm ld}\hspace{0.1cm}p \right ) \hspace{0.05cm}.$$

- „lg” kennzeichnet hierbei den Logarithmus zur Basis 10. Zu erwähnen ist ferner, dass jeweils noch die Pseudoeinheit „bit/Anfrage” anzufügen ist.

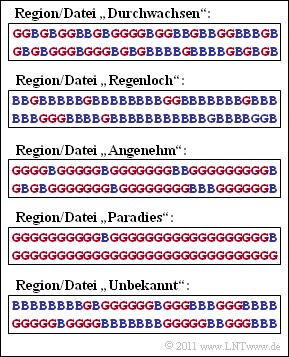

- Die Grafik zeigt diese binären Folgen jeweils für 60 Tage und folgende Regionen:

- Region „Durchwachsen”: pB = pG = 0.5,

- Region „Regenloch”: pB = 0.8, pG = 0.2,

- Region „Angenehm”: pB = 0.2, pG = 0.8,

- Region „Paradies”: pB = 1/30, pG = 29/30.

- Schließlich ist auch noch die Datei „Unbekannt” angegeben, deren statistische Eigenschaften zu schätzen sind.

- Hinweis: Die Aufgabe bezieht sich auf das Kapitel Gedächtnislose Nachrichtenquellen. Für die vier ersten Dateien wird vorausgesetzt, dass die Ereignisse „B” und „G” statistisch unabhängig seien, eine für die Wetterpraxis allerdings eher unrealistische Annahme.

Fragebogen

Musterlösung

1. Bei der Datei „Durchwachsen” sind die beiden Wahrscheinlichkeiten pG und pB gleich, jeweils 0.5. Damit ergibt sich für die Entropie:

- $$H_{\rm D} = 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} + 0.5 \cdot {\rm log}_2\hspace{0.1cm}\frac{1}{0.5} \hspace{0.15cm}\underline {= 1\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

- 2. Mit pB = 0.8 und pG = 0.2 erhält man einen kleineren Entropiewert:

- $$H_{\rm R} \hspace{0.1cm} = \hspace{0.1cm} 0.8 \cdot {\rm log}_2\hspace{0.1cm}\frac{5}{4} + 0.2 \cdot {\rm log}_2\hspace{0.1cm}\frac{5}{1}= 0.8 \cdot{\rm log}_2\hspace{0.1cm}5 - 0.8 \cdot {\rm log}_2\hspace{0.1cm}4 + 0.2 \cdot {\rm log}_2 \hspace{0.15cm} 5 =\\ \hspace{0.1cm} = \hspace{0.1cm}{\rm log}_2\hspace{0.1cm}5 - 0.8 \cdot {\rm log}_2\hspace{0.1cm}4 = \frac{{\rm lg} \hspace{0.1cm}5}{{\rm lg}\hspace{0.1cm}2} - 0.8 \cdot 2 = \frac{0.699}{0.301} - 1.6 \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

- 3. In der Datei „Angenehm” sind die Wahrscheinlichkeiten gegenüber der Datei „Regenloch” genau vertauscht. Durch diese Vertauschung wird die Entropie nicht verändert:

- $$H_{\rm A} = H_{\rm R} \hspace{0.15cm} \underline {= 0.722\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

- 4. Mit pB = 1/30 und pG = 29/30 ergeben sich folgende Informationsgehalte:

- $$I_{\rm B} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}30 = \frac{{\rm lg}\hspace{0.1cm}30}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} \underline {= 4.907\,{\rm bit/Anfrage}}\hspace{0.05cm},\\ I_{\rm G} \hspace{0.1cm} = \hspace{0.1cm} {\rm log}_2\hspace{0.1cm}\frac{30}{29} = \frac{{\rm lg}\hspace{0.1cm}1.034}{{\rm lg}\hspace{0.1cm}2} = \frac{1.477}{0.301} \hspace{0.15cm} \underline {= 0.049\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

- 5. Die Entropie HP ist der mittlere Informationsgehalt der beiden Ereignisse „B” und „G”:

- $$H_{\rm P} = \frac{1}{30} \cdot 4.907 + \frac{29}{30} \cdot 0.049 = 0.164 + 0.047 \hspace{0.15cm} \underline {= 0.211\,{\rm bit/Anfrage}}\hspace{0.05cm}.$$

- Obwohl das Ereignis „B” seltener auftritt als „G”, ist sein Beitrag zur Entropie größer.

- 6. Die Ereignisse „B” und „G” sind bei der Datei „Unbekannt” tatsächlich gleichwahrscheinlich: Die 60 dargestellten Symbole teilen sich auf in 30 mal „G” und 30 mal „B”. Es bestehen nun aber starke statistische Bindungen innerhalb der zeitlichen Folge. Nach längeren Schönwetterperioden folgen meist viele schlechte Tage am Stück.

- Aufgrund dieser statistischen Abhängigkeit innerhalb der B/G–Folge ist HU ≈ 0.72 bit/Anfrage kleiner als HD = 1 bit/Anfrage. HD ist gleichzeitig das Maximum für M = 2 ⇒ die letzte Aussage ist mit Sicherheit falsch. Richtig sind demnach die Aussagen 1 und 3.