Zur Verdeutlichung digitaler Filter

Inhaltsverzeichnis

Theoretischer Hintergrund

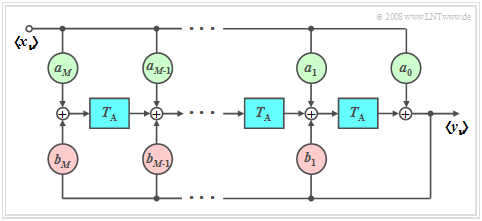

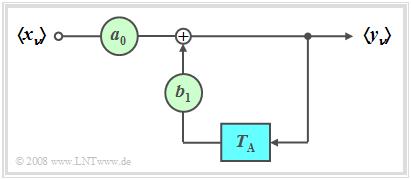

Allgemeines Blockschaltbild

Jedes Signal $x(t)$ kann an einem Rechner nur durch die Folge $〈x_ν〉$ seiner Abtastwerte dargestellt werden, wobei $x_ν$ für $x(ν · T_{\rm A})$ steht.

- Der zeitliche Abstand $T_{\rm A}$ zwischen zwei Abtastwerten ist dabei durch das Abtasttheorem nach oben begrenzt.

- Wir beschränken uns hier auf kausale Signale und Systeme, das heißt, es gilt $x_ν \equiv 0$ für $ν \le 0$.

- Um den Einfluss eines linearen Filters mit Frequenzgang $H(f)$ auf das zeitdiskrete Eingangssignal $〈x_ν〉$ zu erfassen, bietet es sich an, auch das Filter zeitdiskret zu beschreiben. Im Zeitbereich geschieht das mit der zeitdiskreten Impulsantwort $〈h_ν〉$.

- Rechts sehen Sie das entsprechende Blockschaltbild. Für die Abtastwerte des Ausgangssignals $〈y_ν〉$ gilt somit:

- $$y_\nu = \sum\limits_{\mu = 0}^M {a_\mu } \cdot x_{\nu - \mu } + \sum\limits_{\mu = 1}^M {b_\mu } \cdot y_{\nu - \mu } .$$

Hierzu ist Folgendes zu bemerken:

- Der Index $\nu$ bezieht sich auf Folgen, zum Beispiel Eingang $〈x_ν〉$ und Ausgang $〈y_ν〉$.

- Den Index $\mu$ verwenden wir dagegen für die Kennzeichnung der $a$– und $b$–Filterkoeffizienten.

- Die erste Summe beschreibt die Abhängigkeit des aktuellen Ausgangs $y_ν$ vom aktuellen Eingang $x_ν$ und von den $M$ vorherigen Eingangswerten $x_{ν-1}$, ... , $x_{ν-M}.$

- Die zweite Summe kennzeichnet die Beeinflussung von $y_ν$ durch die vorherigen Werte $y_{ν-1}$, ... , $y_{ν-M}$ am Filterausgang. Sie gibt den rekursiven Teil des Filters an.

- Den ganzzahligen Parameter $M$ bezeichnet man als die Ordnung des digitalen Filters. Im Programm ist dieser Wert auf $M\le 2$ begrenzt.

$\text{Definitionen:}$

(1) Man bezeichnet die Ausgangsfolge $〈y_ν〉$ als die zeitdiskrete Impulsantwort $〈h_ν〉$, wenn am Eingang die „zeitdiskrete Diracfunktion” anliegt:

- $$〈x_ν〉= 〈1,\ 0,\ 0,\ 0,\ 0,\ 0,\ 0, \text{...}〉 .$$

(2) Man bezeichnet die Ausgangsfolge $〈y_ν〉$ als die zeitdiskrete Sprungantwort $〈\sigma_ν〉$, wenn am Eingang die „zeitdiskrete Sprungfunktion” anliegt:

- $$〈x_ν〉= 〈1,\ 1,\ 1,\ 1,\ 1,\ 1,\ 1, \text{...}〉 .$$

(3) Man bezeichnet die Ausgangsfolge $〈y_ν〉$ als die zeitdiskrete Recheckantwort $〈\rho_ν^{(2, 4)}〉$, wenn am Eingang die „zeitdiskrete Rechteckfunktion” anliegt:

- $$〈x_ν〉= 〈0,\ 0,\ 1,\ 1,\ 1,\ 0,\ 0, \text{...}〉 .$$

- In Hochkommata angegeben sind hier der Beginn der Einsen $(2)$ und die Stelle der letzten Eins $(4)$.

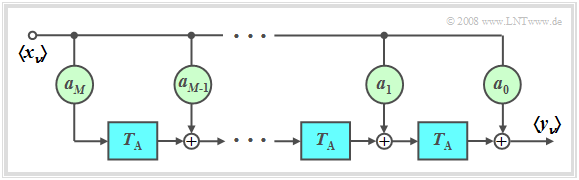

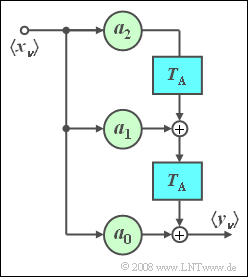

Nichtrekursives Filter – FIR–Filter

$\text{Definition:}$ Sind alle Rückführungskoeffizienten $b_{\mu} = 0$, so spricht von einem nichtrekursiven Filter. Insbesondere in der englischsprachigen Literatur ist hierfür auch die Bezeichnung FIR Filter (Finite Impulse Response) gebräuchlich.

Für die Ordnung $M$ gilt:

- Der Ausgangswert $y_ν$ hängt nur vom aktuellen und den $M$ vorherigen Eingangswerten ab:

- $$y_\nu = \sum\limits_{\mu = 0}^M {a_\mu \cdot x_{\mu - \nu } } .$$

- Zeitdikrete Impulsantwort mit $〈x_ν〉= 〈1,\ 0,\ 0,\ 0,\ 0,\ 0,\ 0, \text{...}〉$:

- $$〈h_\mu〉= 〈a_0,\ a_1,\ \text{...},\ a_M〉 .$$

$\text{Beispiel 1:}$ Ein Zweiwegekanal, bei dem

- das Signal auf dem Hauptpfad gegenüber dem Eingangssignal ungedämpft, aber um $2\ \rm µ s$ verzögert ankommt, und

- in $4\ \rm µ s$ Abstand – also absolut zur Zeit $t = 6\ \rm µ s$ – ein Echo mit halber Amplitude nachfolgt,

kann durch ein nichtrekursives Filter entsprechend obiger Skizze nachgebildet werden, wobei folgende Parameterwerte einzustellen sind:

- $$M = 3,\quad T_{\rm A} = 2\;{\rm{µ s} },\quad a_{\rm 0} = 0,\quad a_{\rm 1} = 1, \quad a_{\rm 2} = 0, \quad a_{\rm 3} = 0.5.$$

$\text{Beispiel 2:}$ Betrachtet wird ein nichtrekursives Filter mit den Filterkoeffizienten $a_0 = 1,\hspace{0.5cm} a_1 = 2,\hspace{0.5cm} a_2 = 1.$

(1) Die herkömmliche Impulsantwort lautet: $h(t) = \delta (t) + 2 \cdot \delta ( {t - T_{\rm A} } ) + \delta ( {t - 2T_{\rm A} } ).$

⇒ Zeitdiskrete Impulsantwort: $〈h_\mu〉= 〈1,\ 2,\ 1〉 .$

(2) Der Frequenzgang $H(f)$ ist die Fouriertransformierte von $h(t)$. Durch Anwendung des Verschiebungssatzes:

- $$H(f) = 2\big [ {1 + \cos ( {2{\rm{\pi }\cdot }f \cdot T_{\rm A} } )} \big ] \cdot {\rm{e} }^{ - {\rm{j} }2{\rm{\pi } }fT_{\rm A} }\hspace{0.5cm}\Rightarrow \hspace{0.5cm}H(f = 0) = 4.$$

(3) Daraus folgt: Die zeitdiskrete Sprungantwort $〈\sigma_ν〉$ tendiert für große $\nu$ gegen $4$.

(4) Die zeitdiskrete Faltung der Eingangsfolge $\left\langle \hspace{0.05cm}{x_\nu } \hspace{0.05cm}\right\rangle = \left\langle {\;1,\;0,\;0,\;0,\;1,\;0,\;0,\;0,\;\text{...} } \hspace{0.05cm} \right\rangle$ mit $\left\langle \hspace{0.05cm}{h_\nu } \hspace{0.05cm}\right\rangle = \left\langle \hspace{0.05cm}{1, \ 2,\ 1 } \hspace{0.05cm}\right\rangle$ ergibt

- $$\left\langle \hspace{0.05cm}{y_\nu } \hspace{0.05cm}\right\rangle = \left\langle {\;1,\;2,\;1,\;0,\;1,\;2,\;1,\;0,\;0,\;0,\;0,\; \text{...} \;} \right\rangle. $$

(5) Die zeitdiskrete Faltung der Eingangsfolge $\left\langle \hspace{0.05cm}{x_\nu } \hspace{0.05cm}\right\rangle = \left\langle {\;1,\;1,\;0,\;0,\;1,\;0,\;0,\;0,\;\text{...} } \hspace{0.05cm} \right\rangle$ mit $\left\langle \hspace{0.05cm}{h_\nu } \hspace{0.05cm}\right\rangle = \left\langle \hspace{0.05cm}{1, \ 2,\ 1 } \hspace{0.05cm}\right\rangle$ ergibt

- $$\left\langle \hspace{0.05cm}{y_\nu } \hspace{0.05cm}\right\rangle = \left\langle {\;1,\;3,\;3,\;1,\;0,\;0,\;0,\;0,\;0,\;0,\;0,\; \text{...} \;} \right\rangle. $$

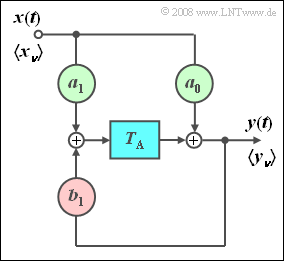

Rekursives Filter

$\text{Definition:}$ Sind alle Vorwärtskoeffizienten identisch $a_\nu = 0$ mit Ausnahme von $a_0$, so liegt ein (rein) rekursives Filter vor.

Im Folgenden beschränken wir uns auf den Sonderfall $M = 1$ (Blockschaltbild entsprechend der Grafik). Dieses Filter weist folgende Eigenschaften auf:

- Der Ausgangswert $y_ν$ hängt (indirekt) von unendlich vielen Eingangswerten ab:

- $$y_\nu = \sum\limits_{\mu = 0}^\infty {a_0 \cdot {b_1} ^\mu \cdot x_{\nu - \mu } .}$$

- Dies zeigt die folgende Rechung:

- $$y_\nu = a_0 \cdot x_\nu + b_1 \cdot y_{\nu - 1} = a_0 \cdot x_\nu + a_0 \cdot b_1 \cdot x_{\nu - 1} + {b_1} ^2 \cdot y_{\nu - 2}. $$

$\text{Definition:}$

- Die zeitdiskrete Impulsantwort $〈\hspace{0.05cm}h_\mu\hspace{0.05cm}〉$ ist definitionsgemäß der Ausgangsfolge, wenn am Eingang eine einzelne „Eins” bei $t =0$ anliegt.

- Bei einem rekursiven Filter reicht die (zeitdiskrete) Impulsantwort schon mit $M = 1$ bis ins Unendliche:

- $$h(t)= \sum\limits_{\mu = 0}^\infty {a_0 \cdot {b_1} ^\mu \cdot \delta ( {t - \mu \cdot T_{\rm A} } )}\hspace{0.3cm} \Rightarrow \hspace{0.3cm}〈\hspace{0.05cm}h_\mu\hspace{0.05cm}〉= 〈\hspace{0.05cm}a_0, \ a_0\cdot {b_1}, \ a_0\cdot {b_1}^2 \ \text{...} \hspace{0.05cm}〉.$$

Weiter ist anzumerken:

- Aus Stabilitätsgründen muss $b_1 < 1$ gelten.

- Bei $b_1 = 1$ würde sich die Impulsantwort $h(t)$ bis ins Unendliche erstrecken und bei $b_1 > 1$ würde $h(t)$ sogar bis ins Unendliche anklingen.

- Bei einem solchen rekursiven Filter erster Ordnung ist jede einzelne Diraclinie genau um den Faktor $b_1$ kleiner als die vorherige Diraclinie:

- $$h_{\mu} = h(\mu \cdot T_{\rm A}) = {b_1} \cdot h_{\mu -1}.$$

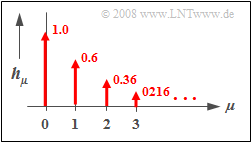

$\text{Beispiel 2:}$ Die nebenstehende Grafik zeigt die zeitdiskrete Impulsantwort $〈\hspace{0.05cm}h_\mu\hspace{0.05cm}〉$ eines rekursiven Filters erster Ordnung mit den Parametern $a_0 = 1$ und $b_1 = 0.6$.

- Der Verlauf ist exponentiell abfallend und erstreckt sich bis ins Unendliche.

- Das Verhältnis der Gewichte zweier aufeinander folgender Diracs ist jeweils $b_1 = 0.6$.

Aufgaben zum Kapitel

Aufgabe 5.3: Digitales Filter 1. Ordnung

Aufgabe 5.3Z: Nichtrekursives Filter

Erwartungswerte von 2D–Zufallsgrößen und Korrelationskoeffizient

Wir betrachten eine zweidimensionale $\rm (2D)$–Zufallsgröße $(X,\ Y)$ mit der Wahrscheinlichkeitsdichtefunktion $\rm (WDF)$ $f_{XY}(x, y)$, wobei zwischen den Einzelkomponenten $X$ und $Y$ statistische Abhängigkeiten bestehen. Ein Sonderfall ist die Korrelation.

$\text{Definition:}$ Unter Korrelation versteht man eine lineare Abhängigkeit zwischen den Einzelkomponenten $X$ und $Y$.

- Korrelierte Zufallsgrößen sind damit stets auch statistisch abhängig.

- Aber nicht jede statistische Abhängigkeit bedeutet gleichzeitig eine Korrelation.

Für das Folgende setzen wir voraus, dass $X$ und $Y$ mittelwertfrei seien ⇒ ${\rm E}\big [ X \big ] = {\rm E}\big [ Y \big ]=0$. Zur Beschreibung der Korrelation genügen dann folgende Erwartungswerte:

- die Varianzen in $X$– bzw. in $Y$–Richtung:

- $$\sigma_X^2= {\rm E}\big [ X^2 \big ] = \int_{-\infty}^{+\infty}\hspace{0.2cm}x^2 \cdot f_{X}(x) \, {\rm d}x\hspace{0.05cm},\hspace{0.5cm}\sigma_Y^2= {\rm E}\big [Y^2 \big ] = \int_{-\infty}^{+\infty}\hspace{0.2cm}y^2 \cdot f_{Y}(y) \, {\rm d}y\hspace{0.05cm};$$

- die Kovarianz zwischen den Einzelkomponenten $X$ und $Y$:

- $$\mu_{XY}= {\rm E}\big [ X \cdot Y \big ] = \int_{-\infty}^{+\infty}\hspace{0.2cm}\int_{-\infty}^{+\infty} x\ \cdot y \cdot f_{XY}(x,y) \, {\rm d}x\, {\rm d}y\hspace{0.05cm}.$$

Bei statistischer Unabhängigkeit der beiden Komponenten $X$ und $Y$ ist die Kovarianz $\mu_{XY} \equiv 0$.

- Das Ergebnis $\mu_{XY} = 0$ ist auch bei statistisch abhängigen Komponenten $X$ und $Y$ möglich, nämlich dann, wenn diese unkorreliert, also linear unabhängig sind.

- Die statistische Abhängigkeit ist dann nicht von erster, sondern von höherer Ordnung, zum Beispiel entsprechend der Gleichung $Y=X^2.$

Man spricht dann von vollständiger Korrelation, wenn die (deterministische) Abhängigkeit zwischen $X$ und $Y$ durch die Gleichung $Y = K · X$ ausgedrückt wird.

Dann ergibt sich für die Kovarianz:

- $\mu_{XY} = σ_X · σ_Y$ bei positivem Wert von $K$,

- $\mu_{XY} = -σ_X · σ_Y$ bei negativem $K$–Wert.

Deshalb verwendet man häufig als Beschreibungsgröße anstelle der Kovarianz den so genannten Korrelationskoeffizienten.

$\text{Definition:}$ Der Korrelationskoeffizient ist der Quotient aus der Kovarianz $\mu_{XY}$ und dem Produkt der Effektivwerte $σ_X$ und $σ_Y$ der beiden Komponenten:

- $$\rho_{XY}=\frac{\mu_{XY} } {\sigma_X \cdot \sigma_Y}.$$

Der Korrelationskoeffizient $\rho_{XY}$ weist folgende Eigenschaften auf:

- Aufgrund der Normierung gilt stets $-1 \le ρ_{XY} ≤ +1$.

- Sind die beiden Zufallsgrößen $X$ und $Y$ unkorreliert, so ist $ρ_{XY} = 0$.

- Bei strenger linearer Abhängigkeit zwischen $X$ und $Y$ ist $ρ_{XY}= ±1$ ⇒ vollständige Korrelation.

- Ein positiver Korrelationskoeffizient bedeutet, dass bei größerem $X$–Wert im statistischen Mittel auch $Y$ größer ist als bei kleinerem $X$.

- Dagegen drückt ein negativer Korrelationskoeffizient aus, dass $Y$ mit steigendem $X$ im Mittel kleiner wird.

$\text{Beispiel 1:}$ Die 2D–Zufallsgröße $(X,\ Y)$ sei diskret und kann nur vier verschiedene Werte annehmen:

- $(+0.5,\ 0)$ sowie $(-0.5,\ 0)$ jeweils mit der Wahrscheinlichkeit $0.3$,

- $(+1,\ +\hspace{-0.09cm}1)$ sowie $(-1,\ -\hspace{-0.09cm}1)$ jeweils mit der Wahrscheinlichkeit $0.2$.

$\rm (A)$ Die Varianzen bzw. die Streuungen können aus $f_{X}(x)$ und $f_{Y}(y)$ berechnet werden:

- $$\sigma_X^2 = 2 \cdot \big [0.2 \cdot 1^2 + 0.3 \cdot 0.5^2 \big] = 0.55\hspace{0.3cm}\Rightarrow\hspace{0.3cm}\sigma_X = 0.7416,$$

- $$\sigma_Y^2 = \big [0.2 \cdot (-1)^2 + 0.6 \cdot 0^2 +0.2 \cdot (+1)^2 \big] = 0.4\hspace{0.3cm}\Rightarrow\hspace{0.3cm}\sigma_Y = 0.6325.$$

$\rm (B)$ Für die Kovarianz ergibt sich der folgende Erwartungswert:

- $$\mu_{XY}= {\rm E}\big [ X \cdot Y \big ] = 2 \cdot \big [0.2 \cdot 1 \cdot 1 + 0.3 \cdot 0.5 \cdot 0 \big] = 0.4.$$

$\rm (C)$ Damit erhält man für den Korrelationskoeffizienten:

- $$\rho_{XY}=\frac{\mu_{XY} } {\sigma_X \cdot \sigma_Y}=\frac{0.4 } {0.7416 \cdot 0.6325 }\approx 0.8528. $$

Eigenschaften der Regressionsgeraden

Ziel der linearen Regression ist es, einen einfachen (linearen) Zusammenhang zwischen zwei Zufallsgrößen $X$ und $Y$ anzugeben, deren $\text{2D-WDF}$ $f_{XY}(x, y)$ durch Punkte $(x_1, y_1 )$ ... $(x_N, y_N )$ in der $(x,\ y)$–Ebene vorgegeben ist. Die Skizze zeigt das Prinzip am Beispiel mittelwertfreier Größen:

- Gesucht ist die Gleichung der Geraden $K$ ⇒ $y=c_{\rm opt} \cdot x$ mit der Eigenschaft, dass der mittlere quadratische (Euklidische) Abstand $\rm (MQA)$ aller Punkte von dieser Geraden minimal ist. Man bezeichnet diese Gerade auch als Korrelationsgerade. Diese kann als eine Art „statistische Symmetrieachse“ interpretiert werden.

Bei einer großen Menge $N$ empirischer Daten ist der mathematische Aufwand beträchtlich, den bestmöglichen Parameter $C = c_{\rm opt}$ zu ermitteln. Der Aufwand wird deutlich reduziert, wenn man den Abstand nur in $x$– oder in $y$–Richtung definiert.

Im Sonderfall Gaußscher 2D-Zufallsgrößen wie in der Skizze verwendet ist die Korrelationsgerade $K$ identisch mit der Ellipsenhauptachse bei Darstellung der 2D-WDF in Form von Höhenlinien (siehe Abschnitt 2.3).

$\text{(a)}\hspace{0.5cm} \text{Regressionsgerade }R_{Y \to X}$ (rote Gerade in der App)

Hier wird der $y$–Wert auf den $x$–Wert zurückgeführt, was in etwa einer der möglichen Bedeutungen „Zurückfallen” des Wortes „Regression” entspricht.

- Geradengleichung, Winkel $\theta_{Y \to X}$ der Geraden $R_{Y \to X}$ zur $x$–Achse:

- $$y=C_{Y \to X} \cdot x \ \ \ \text{mit} \ \ \ C_{Y \to X}=\frac{\sigma_Y}{\sigma_X}\cdot\rho_{XY}= \frac{\mu_{XY}}{\sigma_X^2},\hspace{0.6cm} \theta_{Y \to X}={\rm arctan}\ (C_{Y \to X}).$$

- Kriterium: Der mittlere Abstand aller Punkte $(x_n, y_n )$ von der Regressionsgeraden $R_{Y \to X}$ in $y$–Richtung ist minimal:

- $${\rm MQA}_Y = {\rm E} \big [ y_n - C_{Y \to X} \cdot x_n\big ]^2 = \frac{\rm 1}{N} \cdot \sum_{n=\rm 1}^{N}\; \;\big [y_n - C_{Y \to X} \cdot x_n\big ]^{\rm 2}={\rm Minimum}.$$

- Die zweite Gleichung gilt nur, wenn alle Punkte $(x_n, y_n )$ der 2D–WDF gleichwahrscheinlich sind.

$\text{(b)}\hspace{0.5cm} \text{Regressionsgerade }R_{X \to Y}$ (blaue Gerade in der App)

Die Regression in Gegenrichtung $($also von $X$ auf $Y)$ bedeutet dagegen, dass der $x$–Wert auf den $y$–Wert zurückgeführt wird. Für ${\rm MQA}_X$ ergibt sich der minimale Wert.

- Geradengleichung, Winkel $\theta_{X \to Y}$ der Geraden $R_{X \to Y}$ zur $x$–Achse:

- $$y=C_{X \to Y} \cdot x \ \ \text{mit} \ \ C_{X \to Y}=\frac{\sigma_Y}{\sigma_X\cdot\rho_{XY} }= \frac{\sigma_Y^2} {\mu_{XY}},\hspace{0.6cm} \theta_{X \to Y}={\rm arctan}\ (C_{X \to Y}).$$

- Kriterium: Der mittlere Abstand aller Punkte $(x_n, y_n )$ von der Regressionsgeraden $R_{X \to Y}$ in $x$–Richtung ist minimal:

- $${\rm MQA}_X = {\rm E} \big [ x_n - y_n/C_{X \to Y}\big ]^2 = \frac{\rm 1}{N} \cdot \sum_{n=\rm 1}^{N}\; \;\big [x_n - y_n/C_{X \to Y}\big ]^{\rm 2}={\rm Minimum}.$$

$\text{Beispiel 2:}$ Es gelten die gleichen Voraussetzungen wie im $\text{Beispiel 1}$ und es werden teilweise auch die dort gefundenen Ergebnisse verwendet.

In der oberen Grafik ist die Regressionsgerade $R_{X \to Y}$ als blaue Kurve eingezeichnet:

- Hierfür ergibt sich $C_{X \to Y}={\sigma_Y^2}/\mu_{XY} = 1$ und dementsprechend $ \theta_{X \to Y}={\rm arctan}\ (1) = 45^\circ.$

- Für den mittleren Abstand aller vier Punkte $(x_n, y_n )$ von der Regressionsgeraden $R_{X \to Y}$ in $x$–Richtung erhält man unter Ausnutzung der Symmetrie (beachten Sie die eingezeichneten blauen Horizontalen):

- $${\rm MQA}_X = {\rm E} \big [ x_n - y_n/C_{x \to y}\big ]^2 = 2 \cdot \big [ 0.2 \cdot \left [1 - 1/1\right ]^{\rm 2} +0.3 \cdot \left [0.5 - 0/1\right ]^{\rm 2}\big ]=0.15.$$

- Jede Gerade mit einem anderen Winkel als $45^\circ$ führt hier zu einem größeren ${\rm MQA}_X$.

Betrachten wir nun die rote Regressionsgerade $R_{Y \to X}$ in der unteren Grafik.

- Hierfür ergibt sich $C_{Y \to X}=\mu_{XY}/{\sigma_X^2} = 0.4/0.55\approx0.727$ und $ \theta_{Y \to X}={\rm arctan}\ (0.727) \approx 36^\circ.$

- Hier ist nun der mittlere Abstand der vier Punkte $(x_n, y_n )$ von der Regressionsgeraden $R_{Y \to X}$ in $y$–Richtung minimal (beachten Sie die eingezeichneten roten Vertikalen):

- $${\rm MQA}_Y = {\rm E} \big [ y_n - C_{Y \to X} \cdot x_n\big ]^2 = 2 \cdot \big [ 0.2 \cdot \left [1 - 0.727 \cdot 1\right ]^{\rm 2} +0.3 \cdot \left [0 - 0.727 \cdot 0.5 \right ]^{\rm 2}\big ]\approx 0.109.$$

Die im Text erwähnte „Korrelationsgerade” mit der Eigenschaft, dass der mittlere quadratische Euklidische Abstand $\rm (MQA)$ aller Punkte von dieser Geraden minimal ist, wird sicher zwischen den beiden hier berechneten Regressionsgeraden liegen.

Der Sonderfall Gaußscher 2D–Zufallsgrößen

Im Sonderfall einer mittelwertfreien Gaußschen 2–Zufallsgröße $(X,\ Y)$ lautet die Verbundwahrscheinlichkeitsdichtefunktion:

- $$f_{XY}(x,y)=\frac{\rm 1}{\rm 2\it\pi \cdot \sigma_X \cdot \sigma_Y \cdot \sqrt{\rm 1-\rho_{\it XY}^2}}\cdot\exp\Bigg[-\frac{\rm 1}{\rm 2 \cdot(1-\it\rho_{XY}^{\rm 2} {\rm)}}\cdot(\frac {\it x^{\rm 2}}{\sigma_X^{\rm 2}}+\frac {\it y^{\rm 2}}{\sigma_Y^{\rm 2}}-\rm 2\cdot\it\rho_{XY}\cdot\frac{x \cdot y}{\sigma_X \cdot \sigma_Y}\rm ) \rm \Bigg].$$

- Ersetzt man $x$ durch $(x - m_X)$ sowie $y$ durch $(y- m_Y)$, so ergibt sich die allgemeinere WDF einer zweidimensionalen Gaußschen Zufallsgröße mit Mittelwert.

- Die beiden Randwahrscheinlichkeitsdichtefunktionen $f_{X}(x)$ und $f_{Y}(y)$ einer Gaußschen 2D-Zufallsgröße sind ebenfalls gaußförmig mit den Streuungen $σ_X$ bzw. $σ_Y$.

- Bei unkorrelierten Komponenten $X$ und $Y$ muss in obiger Gleichung $ρ_{XY} = 0$ eingesetzt werden, und man erhält dann das Ergebnis:

- $$f_{XY}(x,y)=\frac{1}{\sqrt{2\pi}\cdot\sigma_{X}} \cdot\rm e^{-\it {x^{\rm 2}}\hspace{-0.08cm}/{\rm (}{\rm 2\it\sigma_{X}^{\rm 2}} {\rm )}} \cdot\frac{1}{\sqrt{2\pi}\cdot\sigma_{\it Y}}\cdot e^{-\it {y^{\rm 2}}\hspace{-0.08cm}/{\rm (}{\rm 2\it\sigma_{Y}^{\rm 2}} {\rm )}} = \it f_{X} \rm ( \it x \rm ) \cdot \it f_{Y} \rm ( \it y \rm ) .$$

- Bei korrelierten Komponenten $X$ und $Y$ ⇒ $ρ_{XY} \ne 0$ sind die Höhenlinien der 2D-WDF jeweils ellipsenförmig. Die Korrelationsgerade $K$ ist hier identisch mit der Ellipsenhauptachse, die unter folgendem Neigungswinkel verläuft:

- $$\theta_{\rm K} = {1}/{2} \cdot {\rm arctan } \ ( 2 \cdot \rho_{XY} \cdot \frac {\sigma_X \cdot \sigma_Y}{\sigma_X^2 - \sigma_Y^2}).$$

- Die (rote) Regressionsgerade $R_{Y \to X}$ einer Gaußschen 2D–Zufallsgröße liegt stets unterhalb der Korrelationsgeraden. Sie kann aus dem Schnittpunkt jeder elliptischen Höhenlinie und ihrer vertikalen Tangente geometrisch konstruiert werden.

- In der Skizze ist dieses Konstruktionsmerkmal in grüner Farbe angedeutet. Die (blaue) Regressionsgerade $R_{X \to Y}$ ist eine Gerade durch den Koordinatenursprung und den Schnittpunkt der elliptischen Höhenlinie mit ihrer horizontalen Tangente.

Programmbeschreibung

Als einfaches Beispiel einer 2D-Zufallsgröße $(X, Y)$ betrachten wir den Fall, dass diese nur vier Werte annehmen kann:

- Punkt $1$ bei $(x_1, \ y_1)$ mit Wahrscheinlichkeit $p_1$: Die Parameter $x_1, \ y_1, \ p_1$ sind im Applet per Slider einstellbar.

- Punkt $2$ bei $(x_2, \ y_2)$ mit Wahrscheinlichkeit $p_2$: Die Parameter liegen durch den Punkt $1$ fest: $x_2=-x_1, \ y_2=-y_1, \ p_2=p_1$.

- Punkt $3$ bei $(+1, +1)$ mit Wahrscheinlichkeit $p_3 = 0.5-p_1$: Die Lage dieses Punktes ist im Applet fest vorgegeben.

- Punkt $4$ bei $(-1, -1)$ mit Wahrscheinlichkeit $p_4 = p_3$: Dieser Punkt liegt ebenso wie der Punkt $3$ auf der Winkelhalbierenden.

Für diese Konstellation werden im Applet folgende Gerade durch den Nullpunkt dargestellt:

- Die Regressionsgerade $R_{X \to Y}$ unter dem Winkel $\theta_{X \to Y}$ ⇒ blaue Kurve,

- die Regressionsgerade $R_{Y \to X}$ unter dem Winkel $\theta_{Y \to X}$ ⇒ rote Kurve,

- eine Hilfsgerade „$\rm (HG)$” unter dem Winkel $\theta_{\rm HG}$ ⇒ grüne Kurve, optional.

Als Zahlenwerte werden die zur Berechnung von $\theta_{X \to Y}$ und $\theta_{Y \to X}$ benötigten statistischen Kenngrößen ausgegeben:

- die Streuungen (Standardabweichungen) $\sigma_X$ und $\sigma_Y$ der Komponenten $X$ bzw. $Y$,

- die Kovarianz $\mu_{XY}$ ⇒ Zentralmoment erster Ordnung der 2D-Zufallsgröße $(X, Y)$,

- der Korrelationskoeffizient $\rho_{XY}$ zwischen den 2D-Zufallsgröße $X$ und $Y$.

Mit Hilfe der (optionalen) Hilfsgeraden sowie der gestrichelt eingezeichneten Abstände der Punkte in $x$– und $y$–Richtung zu dieser lässt sich nachvollziehen, dass

- die rote Regressionsgerade $R_{X \to Y}$ die Eigenschaft hat, dass der mittlere quadrische Abstand aller Punkte in $y$–Richtung ⇒ ${\rm MQA}_Y$ von dieser minimal ist,

- während für die blaue Regressionsgerade $R_{Y \to X}$ der mittlere quadrische Abstand aller Punkte in $x$–Richtung ⇒ ${\rm MQA}_X$ zum Minimum führt.

Versuchsdurchführung

- Wählen Sie zunächst die Nummer 1 ... 6 der zu bearbeitenden Aufgabe.

- Eine Aufgabenbeschreibung wird angezeigt. Die Parameterwerte sind angepasst.

- Lösung nach Drücken von „Musterlösung”.

- Die Nummer 0 entspricht einem „Reset”: Gleiche Einstellung wie beim Programmstart.

In den folgenden Aufgabenbeschreibungen werden folgende Kurzbezeichnungen verwendet:

- Rot: Regressionsgerade $R_{Y \to X}$ (im Applet rot gezeichnet),

- Blau: Regressionsgerade $R_{X \to Y}$ (im Applet blau gezeichnet).

(1) Mit welcher Parametereinstellung sind die beiden Regressionsgeraden $R_{Y \to X}$ und $R_{X \to Y}$ deckungsgleich?

- Es ist offensichtlich, dass gleiche Regressionsgeraden nur möglich sind, wenn diese unter dem Winkel $45^\circ$ verlaufen ⇒ „Winkelhalbierende”.

- Da die fest vorgegebenen Punkte $3$ und $4$ auf der Winkelhalbierenden liegen, muss dies auch für die Punkte $1$ und $2$ gelten ⇒ $y_1 = x_1$.

- Dies gilt für alle Parametereinstellungen $y_1 = x_1$ und auch für alle $p_1$ im erlaubten Bereich von $0$ bis $0.5$.

(2) Nun gelte $x_1 = 0.5,\ y_1 = 0,\ p_1 = 0.3$ Interpretieren Sie die Ergebnisse. Aktivieren Sie hierzu die Hilfsgerade.

- Diese Einstellung stimmt mit den Voraussetzungen zu $\text{Beispiel 1}$ und $\text{Beispiel 2}$ überein. Insbesondere gilt $ \theta_{X \to Y}= 45^\circ$ und $ \theta_{Y \to X}\approx 36^\circ$.

- Durch Variation des Winkels $ \theta_{\rm HG}$ erkennt man, dass für $ \theta_{\rm HG}= 45^\circ$ die Kenngröße ${\rm MQA}_X =0.15$ tatsächlich den kleinsten Wert annimmt.

- Ebenso ergibt sich der kleinstmögliche Abstand ${\rm MQA}_Y =0.109$ in $y$–Richtung für $ \theta_{\rm HG}= 36^\circ$, also entsprechend der Geraden $R_{Y \to X}$.

(3) Es gelten zunächst weiter die Einstellungen von (2). Wie ändern sich die Ergebnisse nach Variation von $p_1$ im erlaubten Bereich $(0\le p_1 \le 0.5)$?

- Die blaue Regressionsgerade $ R_{X \to Y}$ verläuft weiter unter dem Winkel $ \theta_{X \to Y}= 45^\circ$ ⇒ es gilt hier $\mu_{XY} =\sigma_Y^2$, und zwar unabhängig von $p_1 < 0.5$.

- Im Grenzfall $p_1 = 0.5$ ist wegen $\sigma_Y =0$ die blaue Regressionsgerade undefiniert. Es handelt sich nurmehr um eine 1D–Zufallsgröße $X$.

- Mit $p_1=0$ sind nur die äußeren Punkte $3$ und $4$ wirksam ⇒ $ \theta_{Y \to X}= \theta_{X \to Y}= 45^\circ$, mit $p_1=0.5$ nur die inneren Punkte ⇒ $ \theta_{Y \to X}= 0^\circ$.

- Dazwischen wird $ R_{Y \to X}$ kontinuierlich flacher. Sind alle Punkte gleichwahrscheinlich $(p_1=0.25)$, dann ist $\theta_{Y \to X}\approx 38.7^\circ$.

(4) Nun gelte $x_1 = 0,\ y_1 = 0.5,\ p_1 = 0.3$. Variieren Sie $0\le p_1 < 0.5$ und interpretieren Sie die Ergebnisse. $(p_1 = 0.5$ sollte man ausschließen$)$.

- Wegen $\sigma_X \le \sigma_Y$ liegt weiterhin die blaue Gerade nie unterhalb der roten, die für alle $p_1 \ne 0.5$ die Winkelhalbierende ist ⇒ $ \theta_{Y \to X}\approx 45^\circ$.

- Der Winkel der blauen Regressionsgerade wächst von $ \theta_{X \to Y}= 45^\circ \ (p_1 = 0)$ bis $ \theta_{X \to Y} \to 90^\circ \ (p_1 \to 0.5)$ kontinuierlich an.

(5) Beginnen Sie mit $x_1 = 0.8,\ y_1 = -0.8,\ p_1 = 0.25$ und vergrößern Sie $y_1$ bis zum Endwert $y_1 = +0.8$. Interpretieren Sie die Ergebnisse.

- Für $y_1 =-0.8$ ist $ \theta_{X \to Y}= 77.6^\circ$ und $ \theta_{Y \to X}= 12.4^\circ$. Mit steigendem $y_1$ verläuft $ R_{X \to Y}$ (blau) flacher und $R_{Y \to X}$ (rot) steiler.

- Im Endpunkt $(y_1 = +0.8)$ verlaufen die beiden Regressionsgeraden deckungsgleich unter dem Winkel $ \theta_{X \to Y}= \theta_{Y \to X}= 45^\circ$.

(6) Abschließend gelte $x_1 = +1,\ y_1 = -1$. Variieren Sie $p_1$ im gesamten zulässigen Bereich $0\le p_1 \le 0.5$. Wann sind $X$ und $Y$ unkorreliert?

- Für $p_1 = 0$ gilt $ \theta_{X \to Y}=\theta_{Y \to X}= 45^\circ.$ Dann dreht die blaue Gerade entgegen dem Uhrzeigersinn, die rote Gerade im Uhrzeigersinn.

- Für $p_1 = 0.25$ sind die Winkel $ \theta_{X \to Y}=90^\circ, \ \theta_{Y \to X}= 0^\circ.$ Diese Momentaufnahme beschreibt unkorrelierte Zufallsgrößen ⇒ $\mu_{XY}=0$.

- Anschließend drehen beide Geraden weiter in gleicher Richtung. Für $p_1 = 0.5$ gilt schließlich: $ \theta_{X \to Y}=135^\circ= -45^\circ, \ \theta_{Y \to X}= -45^\circ.$

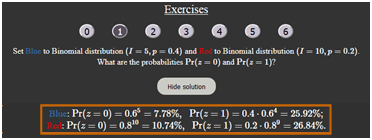

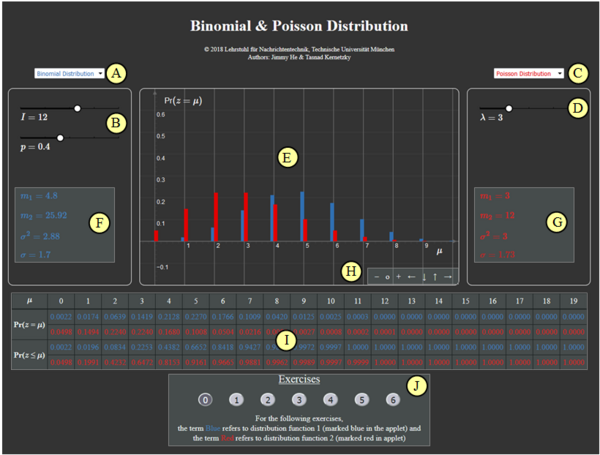

Zur Handhabung des Applets

(A) Vorauswahl für blauen Parametersatz

(B) Parametereingabe $I$ und $p$ per Slider

(C) Vorauswahl für roten Parametersatz

(D) Parametereingabe $\lambda$ per Slider

(E) Graphische Darstellung der Verteilungen

(F) Momentenausgabe für blauen Parametersatz

(G) Momentenausgabe für roten Parametersatz

(H) Variation der grafischen Darstellung

$\hspace{1.5cm}$„$+$” (Vergrößern),

$\hspace{1.5cm}$ „$-$” (Verkleinern)

$\hspace{1.5cm}$ „$\rm o$” (Zurücksetzen)

$\hspace{1.5cm}$ „$\leftarrow$” (Verschieben nach links), usw.

( I ) Ausgabe von ${\rm Pr} (z = \mu)$ und ${\rm Pr} (z \le \mu)$

(J) Bereich für die Versuchsdurchführung

Andere Möglichkeiten zur Variation der grafischen Darstellung:

- Gedrückte Shifttaste und Scrollen: Zoomen im Koordinatensystem,

- Gedrückte Shifttaste und linke Maustaste: Verschieben des Koordinatensystems.

Über die Autoren

Dieses interaktive Berechnungstool wurde am Lehrstuhl für Nachrichtentechnik der Technischen Universität München konzipiert und realisiert.

- Die erste Version wurde 2005 von Bettina Hirner im Rahmen ihrer Diplomarbeit mit „FlashMX–Actionscript” erstellt (Betreuer: Günter Söder).

- 2020 wurde das Programm von Veronika Hofmann (Ingenieurspraxis Mathematik, Betreuer: Benedikt Leible und Tasnád Kernetzky ) unter „HTML5” neu gestaltet.