Technische Neuerungen von LTE

Inhaltsverzeichnis

Zur Sprachübertragung bei LTE

Anders als die bisherigen Mobilfunkstandards unterstützt LTE nur eine paketorientierte Übertragung. Für die Sprachübertragung wäre jedoch eine verbindungsorientierte Übertragung mit fester Reservierung der Ressourcen besser, da eine „gestückelte Übertragung” – wie es beim paketorientierten Verfahren der Fall ist – relativ kompliziert ist.

Das Problem der Einbindung von Sprachübertragungsverfahren war eine der großen Herausforderungen bei der Entwicklung von LTE, denn die Sprachübertragung ist für die Netzbetreiber weiterhin die größte Einnahmequelle. Es gab einige Ansätze, wie dem Internet–Artikel [Gut10][1] entnommen werden kann.

(1) Eine sehr einfache und nahe liegende Methode ist "Circuit Switched Fallback" $\rm (CSFB)$. Hier wird für die Sprachübertragung eine leitungsgebundene Übertragung verwendet. Das Prinzip ist:

- Das Endgerät meldet sich im LTE–Netz an und parallel dazu auch noch in einem GSM– oder UMTS–Netz. Bei eingehendem Anruf erhält das Endgerät von der "Mobile Management Entity" (MME, Kontrollknoten im LTE–Netz zur Nutzer–Authentifizierung) eine Nachricht, woraufhin eine leitungsgebundene Übertragung über das GSM– oder das UMTS–Netz aufgebaut wird.

- Ein Nachteil dieser Lösung (eigentlich ist es nur eine „Problemverschleierung”) ist der stark verzögerte Verbindungsaufbau. Außerdem verhindert CSFB die komplette Umstellung des Netzes auf LTE.

(2) Eine weitere Möglichkeit zur Integration von Sprache in ein paketorientes Übertragungssystem bietet "Voice over LTE via GAN" $\rm (VoLGA)$, die auf der von 3GPP entwickelten GAN-Technologie ⇒ Generic Access Network $\rm (GAN)$ basiert. In aller Kürze lässt sich das Prinzip wie folgt darstellen:

- GAN ermöglicht leitungsbezogene Dienste über ein paketorientiertes Netzwerk $\rm (IP–Netzwerk)$, beispielsweise WLAN ("Wireless Local Area Network"). Mit kompatiblen Endgeräten kann man sich so im GSM–Netz über eine WLAN–Verbindung registrieren lassen und leitungsbasierte Dienste nutzen. VoLGA nutzt diese Funktionalität, indem es WLAN durch LTE ersetzt.

- Vorteilhaft ist die schnelle Implementierung von VoLGA, da keine langwierige Neuentwicklung und auch keine Änderungen am Kernnetz notwendig sind. Allerdings muss dem Netz als Hardware ein sogenannter "VoLGA Access Network Controller" (VANC) hinzugefügt werden. Dieser sorgt für die Kommunikation zwischen Endgerät und der "Mobile Management Entity" bzw. dem Kernnetz.

Auch wenn VoLGA für Sprachverbindungen nicht auf ein GSM– oder UMTS–Netz zurückgreifen muss wie CSFB, wurde es auf Grund ihrer Benutzerunfreundlichkeit vom Großteil der Mobilfunkgemeinde auch nur als (unbefriedigende) Brückentechnologie betrachtet. T–Mobile war lange ein Verfechter der VoLGA–Technologie, beendete im Februar 2011 jedoch ebenfalls die weitere Entwicklung.

Im Folgenden beschreiben wir einen besseren Lösungsvorschlag. Stichworte sind "IP Multimedia Subsystem" $\rm (IMS)$ sowie "Voice over LTE" $\rm (VoLTE)$. Die Betreiber in Deutschland haben relativ spät auf diese Technologie umgestellt: Vodafone und O2 Telefonica Anfang 2015, die Telekom Anfang 2016.

Dies ist auch der Grund dafür, dass der Umstieg auf LTE in Deutschland (und in Europa allgemein) schleppender verlief als in den USA. Viele Kunden wollten nicht die höheren Preise für LTE zahlen, so lange es keine gut funktionierende Lösung für die Integration der Sprachübertragung gab.

VoLTE – Voice over LTE

Der aus heutiger Sicht (2016) erfolgversprechendste, teilweise bereits etablierte Ansatz zur Integration der Sprachdienste in das LTE–Netz ist "Voice over LTE" – kurz: $\rm VoLTE$. Dieser offiziell von der GSMA – die weltweite Industrievereinigung von mehr als 800 Mobilfunkanbietern und über 200 Herstellern von Mobiltelefonen und Netzinfrastruktur – verabschiedete Standard ist ausschließlich IP–paketorientiert und basiert auf dem "IP Multimedia Subsystem" $\rm (IMS)$, das bereits 2010 in der UMTS–Release 9 definiert wurde. Die technischen Fakten zu IMS sind:

- Das IMS–Basisprotokoll ist das von "Voice over IP" bekannte "Session Initiation Protocol" $\rm (SIP)$. Es handelt sich dabei um ein Netzprotokoll, mit dem Verbindungen zwischen zwei Teilnehmern aufgebaut und gesteuert werden können.

- Dieses Protokoll ermöglicht die Entwicklung zu einem vollständig (für Daten und Sprache) IP–basierten Netzwerk und bietet damit Zukunftssicherheit.

Der Grund, warum sich die Einführung von VoLTE gegenüber der LTE–Etablierung im Datenverkehr um vier Jahre verzögert hat, liegt im schwierigen Zusammenspiel von „4G” mit den älteren Vorgängerstandards GSM („2G”) und UMTS („3G”). Hierzu ein Beispiel:

- Verlässt ein Mobilfunknutzer seine LTE–Zelle und wechselt in ein Gebiet ohne 4G–Versorgung, so muss ein unmittelbarer Wechsel zum nächstbesten Standard (3G) erfolgen.

- Sprache wird hier technisch völlig anders übermittelt, nicht mehr durch viele kleine Datenpakete ⇒ „paketvermittelt”, sondern sequentiell in den eigens für den Teilnehmer reservierten logischen und physikalischen Kanälen ⇒ „leitungsvermittelt”.

- Diese Umsetzung muss derart schnell und problemlos verlaufen, dass der Endkunde davon nichts merkt. Und diese Umsetzung muss für alle Mobilfunkstandards und Techniken funktionieren.

Nach Ansicht aller Experten wird VoLTE das mobile Telefonieren ähnlich positiv beeinflussen, wie LTE das mobile Internet seit 2011 vorangebracht hat. Wesentliche Vorteile für die Nutzer sind:

- Eine höhere Sprachqualität, da VoLTE AMR–Wideband Codecs mit $\text{12.65 kbit/s}$ bzw. $\text{23.85 kbit/s}$ nutzt. Außerdem werden die VoLTE–Datenpakete für möglichst niedrige Latenzen priorisiert.

- Ein enorm beschleunigter Verbindungaufbau innerhalb von einer oder zwei Sekunden, während es bei "Circuit Switched Fallback" (CSFB) unangenehm lange dauert, bis eine Verbindung steht.

- Ein niedriger Akkuverbrauch, deutlich geringer als bei „2G” und „3G” und damit verbunden eine längere Akkulaufzeit. Auch gegenüber den gängigen VoIP–Diensten ist der Energiebedarf bis zu $40\%$ geringer.

Aus Sicht der Provider ergeben sich folgende Vorteile:

- Eine bessere Spektraleffizienz: Es sind doppelt so viele Gespräche im gleichen Frequenzband möglich als bei „3G”. Anders ausgedrückt: Bei gleichem Gesprächsaufkommen steht für Datendienste mehr Kapazität zur Verfügung.

- Eine einfache Implementierung von Rich Media Services $\rm (RCS)$, etwa für Videotelefonie oder zukünftige Anwendungen, durch die neue Kunden geworben werden können.

- Eine bessere Akzeptanz der höheren Bereitstellungskosten durch LTE–Kunden, wenn man nicht zum Telefonieren in ein „niederwertigeres” Netz wie „2G” oder „3G” ausgelagert werden muss.

Bandbreitenflexibilität

LTE lässt sich durch die Verwendung von $\rm OFDM$ ("Orthogonal Frequency Division Multiplex") mit relativ wenig Aufwand an unterschiedlich breite Frequenzbänder anpassen. Diese Tatsache ist eine aus verschiedenen Gründen – siehe [Mey10][2] – wichtige Eigenschaft, insbesondere für die Netzbetreiber:

- Abhängig von den gesetzlichen Vorgaben in verschiedenen Ländern können die Frequenzbänder für LTE unterschiedlich groß sein. Auch der Ausgang der staatenspezifischen Versteigerungen der LTE–Frequenzen (getrennt nach FDD und TDD) hat die Breite der Spektren beeinflusst.

- Oft betreibt man LTE im Hinblick auf eine spätere Migration in der „Frequenz–Nachbarschaft” etablierter Funkübertragungssysteme, mit deren Abschaltung in Kürze gerechnet wird. Steigt die Nachfrage, so kann man LTE nach und nach auf den frei werdenden Frequenzbereich ausweiten.

- Als Beispiel sei die Migration der Fernsehkanäle nach der Digitalisierung genannt: Im jetzt frei gewordenen VHF–Frequenzbereich um $\text{800 MHz}$ wird ein Teil des LTE–Netzwerks angesiedelt – siehe Grafik zur Frequenzbandaufteilung.

- Eigentlich könnten die Bandbreiten mit einem Feinheitsgrad von bis zu $\text{15 kHz}$ (entsprechend einem OFDMA–Unterträger) gewählt werden. Da dies jedoch unnötig Overhead produzieren würde, hat man als kleinste adressierbare LTE–Ressource eine Dauer von $\text{einer Millisekunde}$ und eine Bandbreite von $\text{180 kHz}$ festgelegt. Ein solcher Block entspricht zwölf Unterträgern $\text{(180 kHz}$ geteilt durch $\text{15 kHz)}$.

Um die Komplexität und den Aufwand bei der Hardwarestandardisierung möglichst gering zu halten, hat man sich zudem auf eine ganze Reihe zulässiger Bandbreiten zwischen $\text{1.4 MHz}$ und $\text{20 MHz}$ geeinigt. Die folgende Auflistung – entnommen aus [Ges08][3] – gibt die standarisierten Bandbreiten, die Anzahl der verfügbaren Blöcke sowie den „Overhead” an:

- $6$ verfügbare Blöcke in der Bandbreite $\text{1.4 MHz}$ ⇒ relativer Overhead ca. $\rm 22.8\%$,

- $15$ verfügbare Blöcke in der Bandbreite $\text{3 MHz}$ ⇒ relativer Overhead ca. $\rm 10\%$,

- $25$ verfügbare Blöcke in der Bandbreite $\text{5 MHz}$ ⇒ relativer Overhead ca. $\rm 10\%$,

- $50$ verfügbare Blöcke in der Bandbreite $\text{10 MHz}$ ⇒ relativer Overhead ca. $\rm 10\%$,

- $75$ verfügbare Blöcke in der Bandbreite $\text{15 MHz}$ ⇒ relativer Overhead ca. $\rm 10\%$,

- $100$ verfügbare Blöcke in der Bandbreite $\text{20 MHz}$ ⇒ relativer Overhead ca. $\rm 10\%$.

Da sonst einige LTE–spezifische Funktionen nicht funktionieren würden, müssen mindestens sechs Blöcke bereitgestellt werden.

- Der relative Overhead ist bei kleiner Kanalbandbreite $\text{(1.4 MHz)}$ vergleichsweise hoch: $(1.4 - 6 \cdot 0.18)/1.4 ≈ 22.8\%$.

- Ab einer Bandbreite von $\text{3 MHz}$ beträgt der relative Overhead konstant $\rm 10\%$.

- Weiter gilt, dass alle Endgeräte auch die maximale Bandbreite von $\text{20 MHz}$ unterstützen müssen [Ges08][3]

FDD, TDD und Halb–Duplex–Verfahren

Eine weitere Neuerung von LTE ist das Halb–Duplex–Verfahren, welches eine Mischung aus den beiden bereits von UMTS bekannten Duplexverfahren darstellt:

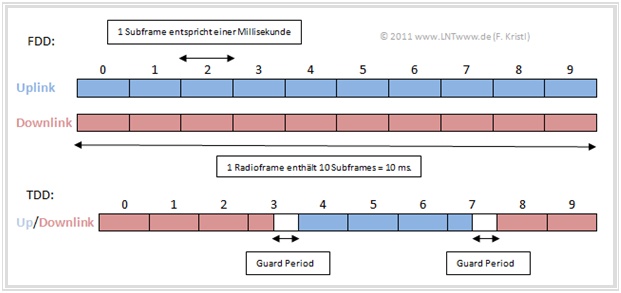

- $\text{Frequency Division Duplex (FDD)}$,

- $\text{Time Division Duplex (TDD)}$ .

Solche Duplexverfahren sind erforderlich, um Uplink und Downlink klar voneinander zu trennen und und so eine reibungslose Übertragung zu ermölichen.

Die beiden Verfahren stellen gewissermaßen einen Gegensatz dar:

- $\rm FDD$ benötigt ein gepaartes Spektrum, also jeweils ein Frequenzband für die Übertragung von der Basisstation in Richtung Endgerät (Downlink) und eines für die Übertragung in umgekehrter Richtung (Uplink). Downlink und Uplink können dabei gleichzeitig benutzt werden.

- $\rm TDD$ wurde für ungepaarte Spektren konzipiert. Zwar benötigt man nun für Uplink und Downlink nur noch ein einziges Band. Sender und Empfänger müssen sich nun allerdings bei der Übertragung abwechseln. Das Hauptproblem von TDD ist die erforderliche Synchronität der Netze.

Mit Hilfe der Methoden FDD und TDD kann also LTE sowohl in gepaarten, als auch in ungepaarten Frequenzbereichen betrieben werden. In der Grafik sind die Unterschiede zwischen FDD und TDD zu erkennen. Man sieht, dass man bei TDD beim Wechsel von Downlink zu Uplink (bzw. umgekehrt) eine "Guard Period" einfügen muss, damit es nicht zu einer Überlagerung der Signale kommt.

Obwohl FDD in der Praxis voraussichtlich stärker genutzt werden wird (und die FDD–Frequenzen für die Provider auch sehr viel teurer waren), gibt es durchaus auch einige Gründe, die für TDD sprechen:

- Frequenzen sind – wie sich bei der Versteigerung 2010 wieder gezeigt hat – ein rares und teures Gut. TDD benötigt aber nur die halbe Frequenzbandbreite.

- Die TDD–Technik ermöglicht verschiedene Modi, die festlegen, wie viel Zeit für Downlink bzw. Uplink verwendet werden soll und kann so auf individuelle Anforderungen abgestimmt werden.

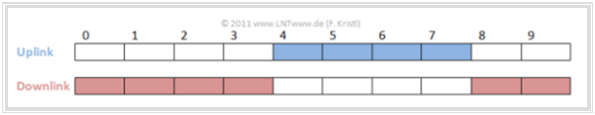

Für die eigentliche Neuerung bei LTE, das $\text{Halb–Duplex–Verfahren}$, benötigt man zwar wie bei FDD auch ein gepaartes Spektrum (siehe zweite Grafik):

- Sender und Empfänger der Basisstation wechseln sich aber trotzdem wie bei TDD ab. Jedes Endgerät kann gleichzeitig entweder nur Senden oder nur Empfangen.

- Durch eine zweite Verbindung zu einem anderen Endgerät mit vertauschtem Downlink/Uplink–Raster kann trotzdem das gesamte zur Verfügung stehende Band voll genutzt werden.

- Der wesentliche Vorteil des Halb–Duplex–Verfahrens besteht darin, dass durch die Verwendung des TDD–Konzepts die Anforderungen an die Endgeräte sinken und sich diese somit billiger produzieren lassen.

Dass dieser Aspekt bei der Standardisierung große Bedeutung hatte, lässt sich auch an der Verwendung von OFDMA im Downlink und von SC–FDMA im Uplink erkennen:

- Dadurch erreicht man eine längere Batterielaufzeit der Endgeräte und es können günstigere Bauteile verwendet werden.

- Mehr dazu finden Sie im Kapitel Die Anwendung von OFDMA und SC-FDMA in LTE.

Mehrantennensysteme

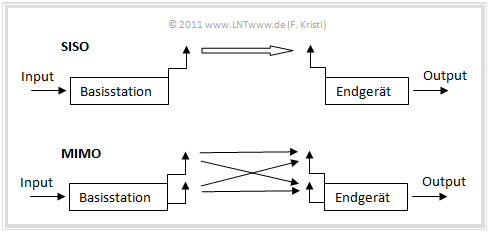

Verwendet ein Funksystem mehrere Sende– und Empfangsantennen, so spricht man von "Multiple Input Multiple Output" $\rm (MIMO)$. Dabei handelt es sich nicht um eine LTE–spezifische Entwicklung. So nutzt beispielweise auch WLAN diese Technologie.

$\text{Beispiel 1:}$ Das Prinzip der Mehrantennensysteme wird in der folgenden Grafik am Beispiel von 2×2–MIMO (zwei Sende– und zwei Empfangsantennen) verdeutlicht.

- Das Neue an LTE ist nicht die eigentliche Nutzung von "Multiple Input Multiple Output", sondern die besonders intensive, nämlich 2×2–MIMO im Uplink und maximal 4×4–MIMO im Downlink.

- Beim Nachfolger LTE–Advanced ist die Nutzung von MIMO noch ausgeprägter, nämlich „4×4” im Uplink und „8×8” in Gegenrichtung.

Ein MIMO–System weist gegenüber "Single Input Single Output" $\rm (SISO$, nur eine Sende– und eine Empfangsantennen$)$ Vorteile auf. Man unterscheidet je nach Kanal zwischen mehreren Gewinnen:

- $\text{Leistungsgewinn}$ gemäß der Anzahl an Empfangsantennen:

Kombiniert man die über mehrere Antennen eintreffenden Funksignale in geeigneter Weise (englisch: Maximal-ratio Combining), so erhöht man die Empfangsleistung und verbessert so die Funkverbindung. Mit einer Verdoppelung der Antennen erreicht man einen Leistungsgewinn von maximal $\text{3 dB}$.

- $\text{Diversitätsgewinn}$ durch Raumdiversität (englisch: Spatial Diversity):

Verwendet man mehrere räumlich getrennte Empfangsantennen in einer Umgebung mit starker Mehrwegeausbreitung, so ist das Fading an den einzelnen Antennen meist unabhängig voneinander und die Wahrscheinlichkeit, dass alle Antennen gleichzeitig von Fading betroffen sind, ist sehr gering.

- $\text{Datenratengewinn}$:

Dieser steigert die Effizienz von MIMO vor allem in einer Umgebung mit erhöhter Mehrwegeausbreitung, insbesondere dann, wenn Sender und Empfänger keine direkte Sichtverbindung haben und die Übertragung über Reflexionen erfolgt. Die Verdreifachung der Antennenzahl bei Sender und Empfänger führt etwa zu einer Verdoppelung der Datenrate.

Nicht möglich ist es jedoch, dass alle Vorteile gleichzeitig eintreten. Abhängig von der Kanalbeschaffenheit kann es auch passieren, dass man nicht einmal die Wahl hat, welchen Vorteil man nutzen will.

Neben den MIMO-Systemen gibt es auch noch folgende Zwischenstufen:

- MISO–Systeme (nur eine Empfangsantenne, somit ist kein Leistungsgewinn möglich), und

- SIMO–Systeme (nur eine Sendeantenne, nur kleiner Diversitätsgewinn).

$\text{Beispiel 2:}$

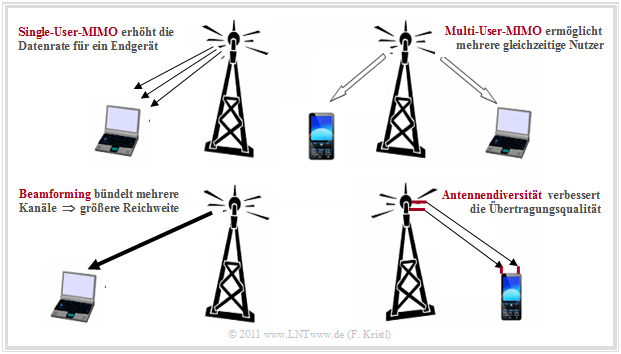

Der Begriff „MIMO” fasst Mehrantennenverfahren mit unterschiedlichen Eigenschaften zusammen, die jeweils in gewissen Situationen von Nutzen sein können. Die folgende Beschreibung ist auf die vier gezeigten Schaubilder abgestimmt.

Werden die weitgehend unabhängigen Kanäle eines MIMO–Systems einem einzigen Teilnehmer zugeteilt (Schaubild oben links), so spricht man von $\text{Single–User MIMO}$.

- Durch 2×2–MIMO verdoppelt sich die Datenrate gegenüber dem SISO–Betrieb und mit jeweils vier Sende– und Empfangsantennen kann die Datenrate bei guten Kanalbedingungen nochmals verdoppelt werden.

- LTE ermöglicht maximal 4×4–MIMO allerdings nur im Downlink. Als Empfänger (Endgeräte) kommen bei 4×4–MIMO aufgrund der Komplexität von Mehrantennensystemen nur Laptops mit LTE–Modems in Frage. Bei einem Handy beschränkt man sich grundsätzlich auf 2×2–MIMO.

Das Ziel von $\text{Multi–User MIMO}$ ist im Gegensatz zum Single–User MIMO nicht die maximale Datenrate für einen Empfänger, sondern die Maximierung der Anzahl der Endgeräte, die das Netz gleichzeitig nutzen können (Schaubild oben rechts).

- Dabei werden verschiedene Datenströme zu unterschiedlichen Nutzern übertragen.

- Dies ist besonders an Orten mit hoher Nachfrage nützlich, wie zum Beispiel an Flughäfen oder in Fußballstadien.

Ein Mehrantennenbetrieb dient aber nicht nur der Maximierung von Nutzerzahl oder Datenrate, sondern im Falle von schlechten Übertragungsbedingungen können mehrere Antennen auch ihre Leistung bündeln und so gezielt Daten zu einem einzigen Nutzer übertragen, um dessen Empfangsqualität zu verbessern. Man spricht dann von $\text{Beamforming}$ (Schaubild unten links), wodurch auch die Reichweite einer Sendestation erhöht wird.

Die vierte Möglichkeit ist $\text{Antennendiversität}$ (Schaubild unten rechts). Dadurch erhöht man die Redundanz (hinsichtlich Systemauslegung) und macht die Übertragung robuster gegenüber Störungen.

- Ein einfaches Beispiel: Es gibt vier Kanäle, die alle die gleichen Daten übertragen.

- Fällt ein Kanal aus, so sind immer noch drei Kanäle für den Informationstransport vorhanden.

Systemarchitektur

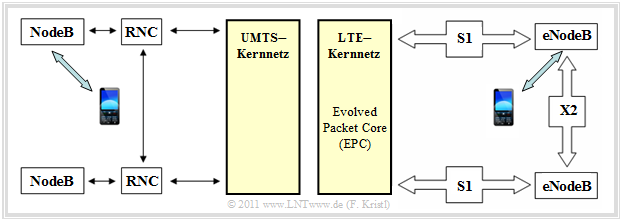

Die LTE–Architektur ermöglicht ein vollständig auf dem IP–Protokoll basierendes Übertragungssystem. Um dieses Ziel zu erreichen, musste die für UMTS spezifizierte Systemarchitektur nicht nur im Detail verändert, sondern teilweise komplett neu konzipiert werden. Dabei wurden auch andere IP–basierte Technologien wie „mobiles WiMAX” oder WLAN integriert, um in diese Netze problemlos wechseln zu können.

- In UMTS–Netzen (linke Grafik) ist zwischen einer Basisstation (NodeB) und dem Kernnetz noch der "Radio Network Controller" (RNC) zwischengeschaltet, der für den Wechsel zwischen verschiedenen Zellen hauptverantwortlich ist und der zu Latenzzeiten von bis zu 100 Millisekunden führen kann.

- Die Neukonzipierung der Basisstationen („eNodeB” anstelle von „NodeB”) und die Schnittstelle $\rm X2$ sind die entscheidenden Weiterentwicklungen von UMTS hin zu LTE. Die rechte Grafik illustriert insbesondere die mit der neuen Technologie einhergegangene Reduzierung der Komplexität gegenüber UMTS.

Die $\text{LTE–Systemarchitektur}$ lässt sich in zwei Bereiche unterteilen:

- das LTE–Kernnetz "Evolved Packet Core" $\rm (EPC)$,

- die Luftschnittstelle "Evolved UMTS Terrestrial Radio Access Network" $\rm (EUTRAN)$ – eine Weiterentwicklung von "UMTS Terrestrial Radio Access Network" (UTRAN).

EUTRAN überträgt die Daten zwischen dem Endgerät und der LTE–Basisstation („eNodeB”) über die sogenannte $\rm S1$–Schnittstelle mit zwei Verbindungen, eine für die Übertragung von Nutzdaten und eine zweite für die Übertragung von Signalisierungsdaten. Aus obiger Grafik erkennt man:

- Die Basisstationen sind außer mit dem EPC auch mit den benachbarten Basisstationen verbunden. Diese Verbindungen (X2–Schnittstellen) bewirken, dass möglichst wenige Pakete verloren gehen, wenn sich das Endgerät aus dem Umkreis einer Basisstation in Richtung einer anderen bewegt.

- Dazu kann die Basisstation, deren Versorgungsgebiet der Nutzer gerade verlässt, eventuell noch zwischengespeicherte Daten direkt und schnell an die „neue” Basisstation weitergeben. Damit ist eine (weitgehend) durchgehende Übertragung sichergestellt.

- Die Funktionalität des RNC geht zum Teil in die Basisstation, zum anderen in die "Mobility Management Entity" $\rm (MME)$ im Kernnetz über. Diese Reduktion der Schnittstellen verkürzt die Signaldurchlaufzeit im Netzwerk und das Handover signifikant auf 20 Millisekunden.

- Die LTE–Systemarchitektur ist zudem so ausgelegt, dass sich zukünftig "Inter–NodeB–Verfahren" (wie "Soft–Handover" oder "Cooperative Interference Cancellation") einfach integrieren lassen.

LTE–Kernnetz: Backbone und Backhaul

Das LTE–Kernnetz "Evolved Packet Core" $\rm (EPC)$ eines Netzbetreibers – in der Fachsprache "Backbone" – besteht aus verschiedenen Netzwerkkomponenten. Das EPC ist mit den Basisstationen über das "Backhaul" (englische Bezeichnung für „Rücktransport”) verbunden. Darunter versteht man die Anbindung eines vorgelagerten, meist hierarchisch untergeordneten Netzknotens an einen zentralen Netzknoten.

Momentan besteht das "Backhaul" zum Großteil aus Richtfunk und sogenannten $\rm E1$–Leitungen. Diese sind Kupferleitungen und erlauben einen Durchsatz von ca. $\text{2 Mbit/s}$. Für GSM– und UMTS–Netzwerke waren diese Verbindungen noch ausreichend, aber bereits für großflächig konzipertes HSDPA reichen solche Datenraten nicht mehr. Für LTE ist ein solches "Backhaul" komplett unbrauchbar:

- Das langsame Kabelnetzwerk würde die schnellen Funkverbindungen ausbremsen; insgesamt wäre kein Geschwindigkeitszuwachs festzustellen.

- Aufgrund der geringen Kapazitäten der Leitungen nach dem E1–Standard wäre auch ein Ausbau mit weiteren baugleichen Leitungen nicht wirtschaftlich.

Im Zuge der LTE–Einführung musste also das "Backhaul" neu entworfen werden. Dabei war es wichtig, Zukunftssicherheit im Auge zu behalten, stand doch die nächste Generation "LTE–Advanced" bereits vor der Einführung. Schenkt man dem von Experten propagierten "Moore's Law" für Mobilfunkbandbreiten Glauben, so ist die teure Neuverlegung besserer Kabel der wichtigste Faktor für die Zukunftssicherheit.

Aufgrund der rein paketorientierten Übertragungstechnik bietet sich für das LTE–Backhaul der ebenfalls IP–basierte Ethernet–Standard an, der mit Hilfe von Lichtwellenleitern realisiert wird. Die Firma Fujitsu stellte 2009 in der Studie [Fuj09][4] zudem die These auf, dass die momentane Infrastruktur noch für die nächsten zehn bis fünfzehn Jahre eine wichtige Rolle für das LTE–Backhaul spielen wird.

Für den Generationenwechsel hin zu einem „Ethernet–basierten Backhaul” gibt es zwei Ansätze:

- der parallele Betrieb der Leitungen mit E1 und Ethernet–Standard,

- die sofortige Migration zu einem auf Ethernet–Backhaul.

Ersteres hätte den Vorteil, dass die Netzbetreiber den Sprachverkehr weiterhin über die alten Leitungen laufen lassen könnten und ausschließlich den bandbreitenintensiven Datenverkehr über die leistungsfähigeren Leitungen abwickeln müssten.

Die zweite Möglichkeit wirft einige technische Probleme auf:

- Die vorher durch die langsamen E1-Standard–Leitungen transportierten Dienste müssten sofort auf ein paketbasiertes Verfahren umgestellt werden.

- Ethernet bietet (anders als der jetzige Standard) bisher keine "End–to–End–Synchronisierung", was beim Funkzellenwechsel zu starken Verzögerungen bis hin zu Dienstunterbrechungen führen kann – also eine gewaltige Einbuße der Servicequalität.

- Im Konzept "Synchronous Ethernet" $\rm (SyncE)$ wurden jedoch von der Fa. Cisco bereits Vorschläge unterbreitet, wie die Synchronisation realisiert werden könnte.

Für Ballungsgebiete wäre eine direkte Umstellung des Backhauls sicher lohnenswert, da für eine vergleichsweise hohe Zahl an neuen Nutzern nur relativ wenige neue Kabel verlegt werden müssten.

Im ländlichen Raum ergäben sich aber durch größere Grabungsarbeiten schnell hohe Kosten. Dies ist aber genau der Bereich, der laut der getroffenen Vereinbarung zwischen der Bundesregierung und den (deutschen) Mobilfunkbetreibern als erstes abgedeckt werden muss. Hier müsste (und wird wohl) der meist vorhandene Richtfunk auf hohe Datenraten erweitert werden.

Aufgaben zum Kapitel

Aufgabe 4.2: FDD, TDD und Halb–Duplex

Aufgabe 4.2Z: MIMO–Anwendungen bei LTE

Quellenverzeichnis

- ↑ Gutt, E.: LTE – eine neue Dimension mobiler Breitbandnutzung. PDF-Dokument im Internet, 2010.

- ↑ Meyer, M.: Siebenmeilenfunk. c't 2010, Heft 25, 2010.

- ↑ 3,0 3,1 Gessner, C.: UMTS Long Term Evolution (LTE): Technology Introduction. Rohde&Schwarz, 2008.

- ↑ Fujitsu Network Communications Inc.: 4G Impacts to Mobile Backhaul. PDF–Internetdokument.