Aufgabe 3.6: Partitionierungsungleichung

Aus LNTwww

Version vom 25. November 2016, 20:33 Uhr von Safwen (Diskussion | Beiträge)

Die $Kullback–Leibler–Distanz$ (kurz KLD) wird auch in der „Partitionierungsungleichung” (englisch: Partition Unequality) verwendet:

- Wir gehen von der Menge

$$X=\{ x_1,x_2,.....,x_M \}$$ und den Wahrscheinlichkeitsfunktionen

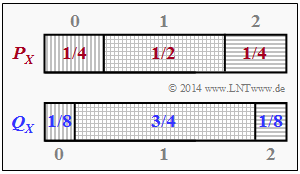

$P_X(X) = P_X(x_1,x_2,....,x_M)$ ,

$Q_X(X) = Q_X(x_1,x_2,....,x_M)$ aus, die in irgendeiner Form „ähnlich” sein sollen

- Die Menge $X$ unterteilen wir in die Partitionen $A_1, ..., A_K$ , die zueinander disjunkt sind und ein $vollständiges System$ ergeben:

$\bigcup_{i=_1}^K A_i = X$ , $A_i \cap A_j = \phi für 1 \leq i \neq j \leq K$

- Die Wahrscheinlichkeitsfunktionen bezüglich der Partitionierungen $A=\{ A_1,A_2,.....,A_K \}$bezeichnen wir im Folgenden mit

$P_X^{ (A) } = [ P_X(A_1),.......,P_X(A_K)]$ , wobei $P_X(A_i) = \sum\limits_{ x \epsilon A_i } P_X(x)$

$Q_X^{ (A) } = [ Q_X(A_1),.......,Q_X(A_K)]$ , wobei $Q_X(A_i) = \sum\limits_{ x \epsilon A_i } Q_X(x)$

Fragebogen

Musterlösung

1.

2.

3.

4.

5.

6.

7.